Java知识点(2024)

# 一. Java基础

# 为什么Java不支持多继承?

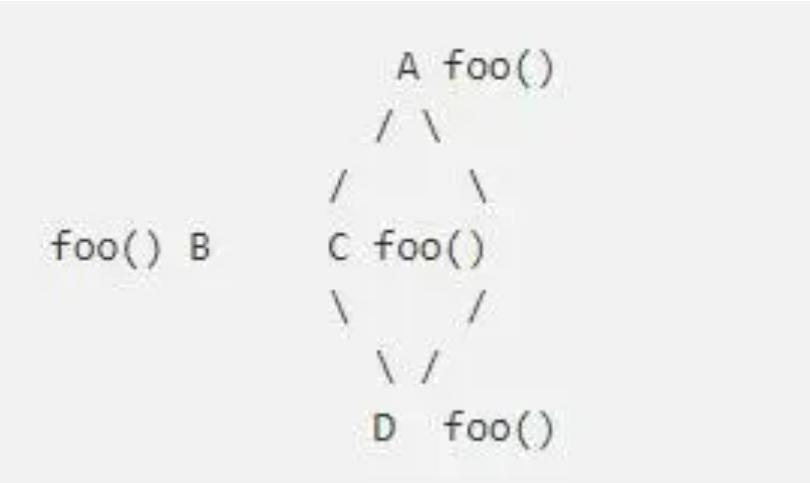

在 Java 语言中,不支持多继承的主要原因是为了简化语言设计和避免潜在的问题(如菱形继承),同时又因为在实际工作中,确实很少用到多继承,所以在 Java 语言中,并不支持多继承。

具体来说,Java 不支持多继承的原因有以下几个:

- 避免菱形继承问题:菱形继承也叫做钻石继承,指的是当一个类从两个不同的父类继承相同的方法,而再次被子类继承时,会导致调用该方法时的二义性。这会造成设计和编译上的困惑和复杂性。

- 简化编程语言:Java 的设计目标之一是简化语言,使其易于学习和使用。多继承在类的设计和使用上增加了复杂性,包括方法解析的问题、命名冲突、继承的混乱等。

- 避免多重继承的层次膨胀:多继承可能导致继承层次的膨胀,如果一个类继承多个父类,再将该类作为基类,子类再继承该类,会造成继承层次的复杂和混乱。

- 避免菱形继承问题:菱形继承也叫做钻石继承,指的是当一个类从两个不同的父类继承相同的方法,而再次被子类继承时,会导致调用该方法时的二义性。这会造成设计和编译上的困惑和复杂性。

# ==和equals有什么区别?

== 任何时候都是基础数据类型都是比较两个值是否相等的,而对于引用类型来说,任何时候都是用来比较两个对象的引用是否相同的,而 equals 对于不同的类来说,它所代表的含义可能是不同的。

例如,对于 Object 来说,== 和 equals 都是一样的,都是用来对比两个对象的引用是否相同的,而 String 或 Integer 等类中,又重写 equals 让其变成了比较值是否相同(而非引用是否相同)。

所以,我们通常会使用 == 来对比两个对象的引用是否相同,而使用 equals 对比两个值是否相同(前提条件是重写了 equals 方法)。

# 返回值不同算方法重载吗?为什么?

返回值不同不算方法重载。

方法重载(Overloading)是指在同一个类中定义了多个同名方法,但它们的参数列表不同,方法重载要求方法:

- 名称相同。

- 参数类型、参数个数或参数顺序,至少有一个不同。

方法重载的目的是提供更多的方法选择,方便程序员根据不同的参数类型或个数来调用合适的方法。

所以,从上面方法的重载要求可以看出,返回值不同是不作为方法重载的依据的。

为什么返回值不同不算方法重载的原因有两个:

- 从程序的执行层面来讲:返回值不同如果作为方法重载,那么会产生歧义;

- 从 JVM 方法签名的角度来讲:返回值并不属于方法签名的一部分,因此无法定位到具体的调用方法。

# String 为什么被设计成不可变的?

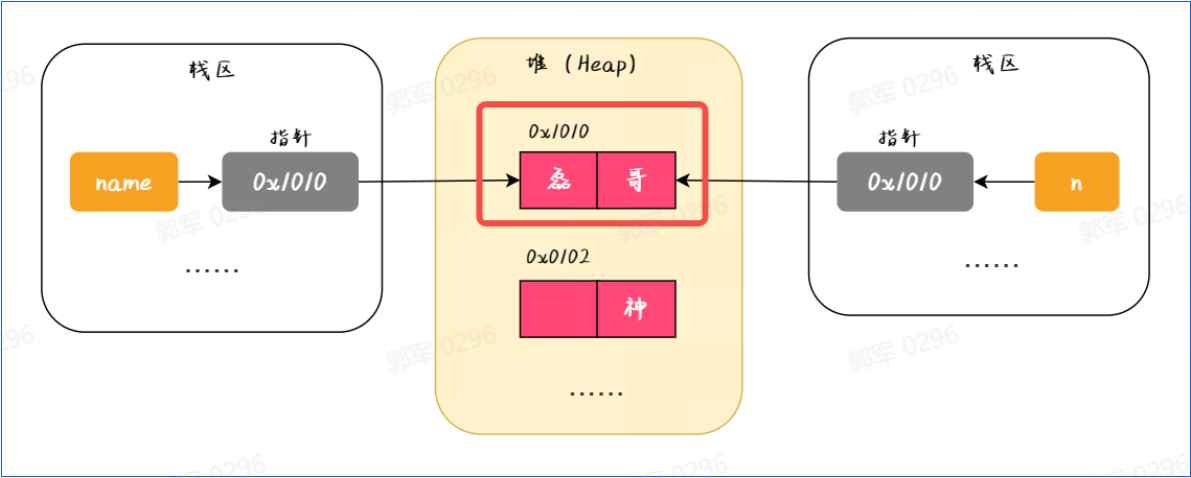

- 安全性:由于 String 是不可变类,即不能被修改,所以使用 final 修饰可以确保 String 类的内部状态不被修改,从而保证了 String 的数据的安全性。例如这幅图中的“0X1010”,系统中只要认定这个指针之后,它就不能被改变了,从而就保证了其安全性。

- 线程安全性:String 是不可变的,因此多个线程可以同时访问和共享 String 对象,而无需进行额外的同步措施。这样可以提高程序的并发性能并减少线程安全问题的出现。线程不安全是由于,多个线程同时修改同一个变量才会导致线程安全问题,而 String 是不可变的,每次操作的都是新对象,那么多个线程操作的就是各自的新对象了,那么也就不会有线程安全问题了。

- 用作键值的准确性:由于 String 的不可变性,它可以安全地用作 HashMap、HashSet 等集合类的键值,这样可以确保散列算法的准确性,避免因修改 String 对象导致哈希值发生变化的情况。

- 性能:String 类在许多地方被广泛使用,使用 final 修饰可以使编译器在编译时对 String 类进行一些优化,从而提高程序的执行效率。

- 安全性:由于 String 是不可变类,即不能被修改,所以使用 final 修饰可以确保 String 类的内部状态不被修改,从而保证了 String 的数据的安全性。例如这幅图中的“0X1010”,系统中只要认定这个指针之后,它就不能被改变了,从而就保证了其安全性。

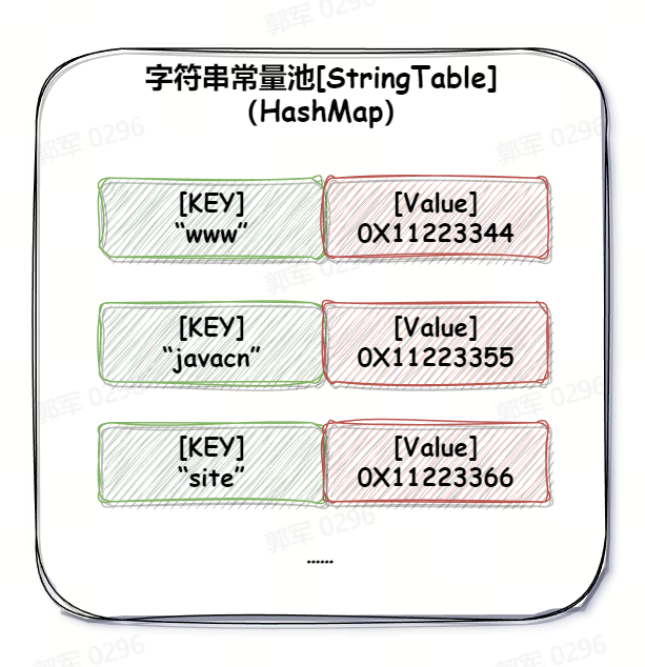

# String str=new String("javacn.site")创建了几个对象?

创建了一个或两个对象。

- 首先,使用 new 关键字,所以无论如何都会在堆上创建一个对象。

- 之后会判断字符串常量池中是否有“javacn.site”字符串,如果有的话就只创建这一个对象。如果没有的话就会在字符串常量池中创建一个字符串对象,所以就是一个或两个对象。

# 包装类的实际应用场景有哪些?

包装类常用的场景有:

- 用于泛型数据存储

- 用于集合类数据存储

- 方法的参数传递

# 说一下 Integer 高速缓存?

在 Java 中,Integer 类内部实现了一个高速缓存,称为 Integer Cache。这个缓存用于缓存一定范围内的整数对象,以提高性能和减少内存消耗。这个特性在 Java 5 及之后的版本中引入。

Integer 类对于小整数值(默认范围为 -128 到 127)会在初始化时创建缓存,即预先创建这些整数对象并存储在一个数组中。当代码中需要创建一个该范围内的整数对象时,实际上是从缓存中获取已存在的对象,而不是每次都创建一个新的对象。这样做的好处是,对于常用的小整数值,不会产生大量的重复对象,从而节省了内存和提高了性能。

这个缓存的范围可以通过 JVM 参数进行调整。例如,可以通过设置 -XX:AutoBoxCacheMax=<size> 来增加缓存的范围。

值得注意的是,对于超过缓存范围的整数值,每次都会创建一个新的 Integer 对象,而不会从缓存中获取。因此,使用整数时要注意是否处于缓存范围,避免在比较整数对象时产生不符合预期的结果

# 为什么重写 equals 时,一定要重写 hashCode?

equals 和 hashCode 是用来协同判断两个对象是否相等的,如果只重写了 equals 方法,而不重写 hashCode,就会导致某些场景下程序异常。

比如给 Set 中插入两个对象时,因为这两个对象引用地址不同,但属性值都相同,那么正常情况下,因为不能重复插入才对。然而,因为未重写 hashCode,所以导致判断 hashCode 不同,就认为它们是不同的对象,这样就会将两个相同的对象都存储到 Set 集合中,这显然是有问题的,因为使用 Set 集合就是用来去重的,结果还存入了两个相同的对象。

# 什么是类型檫除?它有什么好处?

类型擦除(Type Erasure)也叫做泛型檫除,它是指在 Java 中,泛型的参数类型在编译后,被擦除掉的机制。例如编译器会将“new ArrayList<Integer>()”变为“new ArrayList()”,这就是类型檫除。

类型檫除的好处是可以直接兼容之前的代码、节约内存空间,以及 JVM 层面实现更加简单。

举个类型檫除的具体例子,例如以下代码(编译器会将 List<String> 擦除为 List)。类型檫除有以下几个主要优点:

- 兼容之前代码: JDK 5 之前没有泛型,所以在引入泛型后,需要考虑兼容现有代码,而不是大规模的修改现有代码。

- 节约内存:在运行时,泛型类型的参数信息被擦除,因此泛型类在内存占用方面和非泛型类是一样的。这使得泛型的类型参数对应的内存开销为零,从而节约了内存空间。

- 实现简单:类型擦除只需要在编译时去掉类型即可,无需在 JVM 层面添加泛型支持,所以技术实现比较简单。

# 什么是克隆?深克隆和浅克隆有什么区别?

克隆是指创建一个对象的副本,使副本具有与原始对象相同的属性和状态。在计算机编程中,克隆是一种常见的操作,用于复制数据、对象或数据结构,以便在不影响原始数据的情况下进行操作、修改或分发。

克隆最典型的使用场景是原型模式,原型模式是一种创建型设计模式,用于创建对象的克隆副本,而无需依赖复杂的实例化过程。原型模式通过复制现有对象的原型来创建新的对象,从而避免了通过构造函数创建对象的开销和复杂性。

而克隆又分为深克隆和浅克隆:

- 深克隆(Deep Clone)是将原型对象中的所有类型,无论是值类型还是引用类型,都复制一份给克隆对象,也就是说深克隆会把原型对象和原型对象所引用的对象,都复制一份给克隆对象。

- 浅克隆(Shadow Clone)是把原型对象中成员变量为值类型的属性都复制给克隆对象,把原型对象中成员变量为引用类型的引用地址也复制给克隆对象,也就是原型对象中如果有成员变量为引用对象,则此引用对象的地址是共享给原型对象和克隆对象的。简单来说就是浅克隆只会复制原型对象,但不会复制它所引用的对象。

深克隆和浅克隆的主要区别:深克隆会复制原型对象和它所引用所有对象,而浅克隆只会复制原型对象。

# Java是值传递还是引用传递?

值传递(Pass by value)和引用传递(Pass by reference)是关于参数传递方式的两个概念。

值传递:将传递参数的值,复制一份到方法的参数中。换句话说,值传递的是原始数据的一个副本,而不是原始数据本身。

引用传递:将实际参数的引用(内存地址)传递给方法,这意味着方法内部对参数的修改会影响原始数据本身,也就是说引用传递传递的是原始数据,而非原始数据的副本。

也就是,值传递和引用传递最大的区别是传递的是自身,还是复制的副本,如果传递的是自身则为引用传递,如果传递的是复制的副本则为值传递。

在 Java 语言中,只有值传递,没有引用传递!

# 反射的使用场景有哪些?如何实现反射?

反射(Reflection)是指在程序运行时获取和操作类的一种能力。通过反射机制,可以在运行时动态地创建对象、调用方法、访问和修改属性,以及获取类的信息。

反射的主要目的是使程序能够在编译时不知道类的具体信息的情况下,动态地运行和操作类。它提供了一种机制,可以在运行时检查和操作类的信息。

反射使用场景

使用反射我们可以实现动态代理(扩充程序的功能),可以实现设计更多的类库和框架,例如以下这些:

- Spring AOP 功能:Spring 是一个功能强大的企业级开发框架,它广泛使用反射来实现依赖注入、AOP(面向切面编程)等功能。通过反射,Spring 能够在运行时动态地创建和管理对象,并将依赖关系注入到对象中。

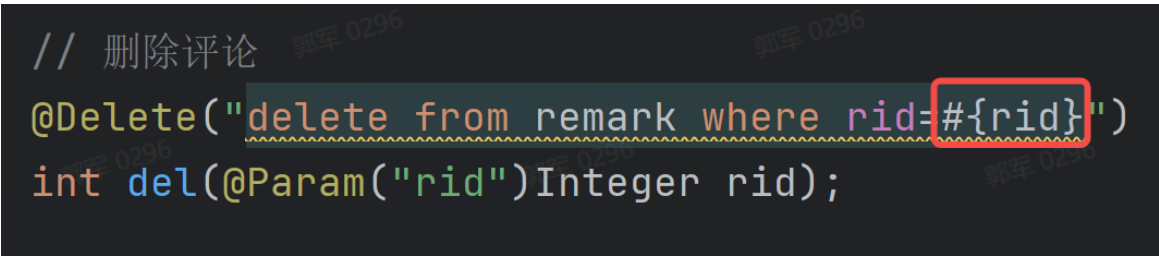

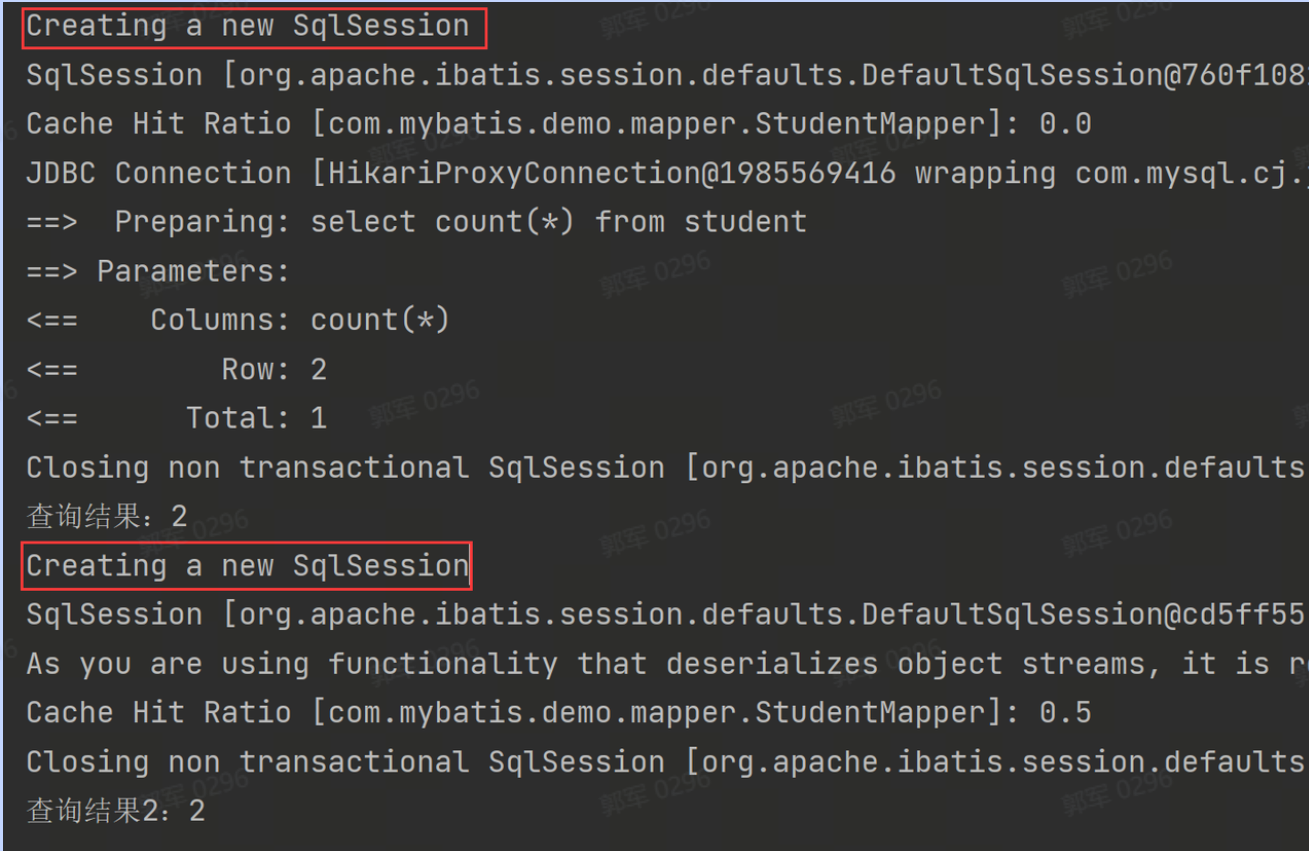

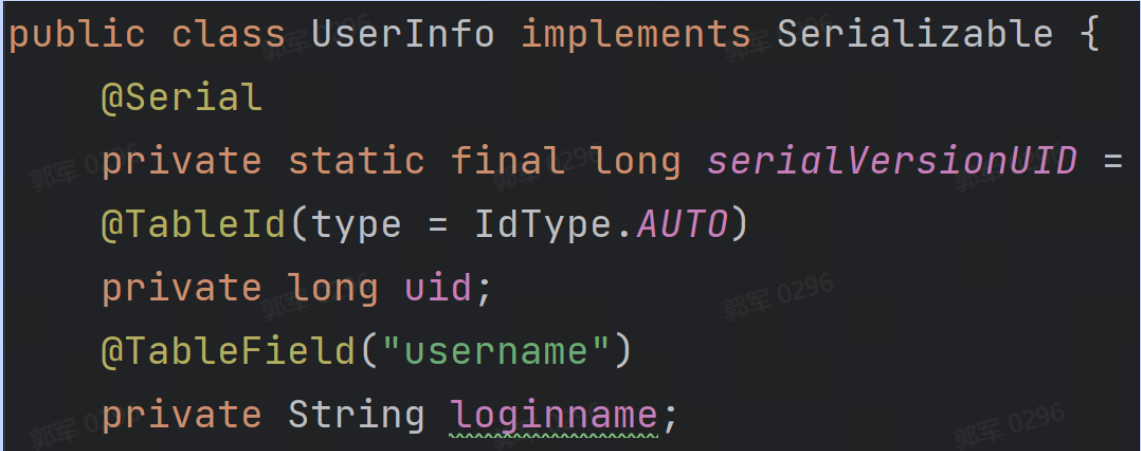

- MyBaits Plus 框架:MyBatis Plus 是一个强大的 ORM(对象关系映射)框架,它是基于 MyBatis 框架的增强框架,MyBatis Plus 中大量使用了反射机制,例如 MyBatis Plus 通过反射来分析实体类的字段和方法,从而动态地生成 SQL 语句和处理数据库操作。通过反射,可以获取实体类的属性、字段名称、数据类型等信息,并将其映射到数据库表的列。

- JUnit 测试框架:JUnit 是用于 Java 单元测试的常用框架,它使用反射来实例化测试类、调用测试方法,并进行断言和校验。通过反射,JUnit 能够在运行时动态地执行测试代码,并获取测试方法的结果。

如何实现反射?

反射的第一步是先获取类,例如使用 Class.forName("xxx") 获取,然后可以通过 getDeclaredFields 方法获取类中的所有字段,以及可以通过 getDeclaredMethods 方法得到类中的所有方法,之后可以使用 getDeclaredConstructor 方法得到构造方法对象 Constructor,然后可以通过构造方法对象 Constructor 提供的 newInstance 得到类对象,然后就可以使用类对象实例了。

# 反射有什么优缺点?为什么反射执行的比较慢?

反射的优点:

- 动态性:反射使得程序在运行时可以动态获取类的信息和操作类或对象,使得代码更加灵活和通用。

- 通用性:反射可以处理不同类的对象,使得代码更加通用和复用。

反射的缺点:

- 性能较低:由于反射需要在运行时动态获取信息和调用方法,会导致性能相对较低,因此在性能要求较高的场景下,应谨慎使用反射。

- 安全性问题:反射可以访问和修改对象的私有字段和方法,这可能导致安全性问题。在使用反射时,需要注意安全性问题,避免滥用反射带来的潜在风险。

为什么反射执行比较慢?

反射执行慢的主要原因是反射涉及到了运行时类型检查、访问权限检查、动态方法调用和一些额外的操作,这些操作都会导致反射的执行比较慢。

具体来说,反射的执行要经历以下过程:

- 运行时类型检查:在使用反射时,需要在运行时进行类型检查,以确保调用的方法、访问的属性等是有效的。这涉及到了额外的运行时判断和类型转换。

- 访问权限检查:Java 的反射机制可以突破访问权限的限制,可以访问私有的方法、属性等。因此,在执行反射操作时,需要进行额外的权限检查和处理,这会带来额外的开销。

- 方法调用的动态性:对于通过反射调用的方法,需要在运行时动态地解析方法的签名,并确定要调用的具体方法。这需要进行方法查找和动态绑定的过程,相对于直接调用方法而言更为耗时。

- 临时对象的创建:反射会导致对象的多次创建和临时对象的产生,这在某些情况下可能会引起额外的开销。反射操作一般不会被 JVM 的即时编译器优化,也没有缓存和重用,所以也会比较慢。

- 禁止的编译器优化:由于反射是在运行时进行的,而不是在编译时,这意味着编译器无法进行静态优化和代码优化。导致反射的执行效率相对较低。

# 动态代理的使用场景有哪些?它和静态代理有什么区别?

动态代理的常见使用场景有以下这些:

- AOP(面向切面编程):动态代理可以用于实现横切逻辑,例如日志记录、性能监控、事务管理等。通过在方法执行前后插入代理逻辑,可以实现对目标方法的增强。

- 远程方法调用(RPC):动态代理可以用于远程方法调用框架,例如使用代理对象作为客户端的远程服务代理,将调用转发给实际的远程服务。

- 动态权限校验:动态代理可以用于动态权限校验,例如在访问某个受限资源时,使用代理对象判断用户是否具有相应的权限。

PS:例如,Spring 中的 AOP、声明式事务、MyBatis/MyBatis Plus 中的分页插件、Dubbo、Openfeign 都是动态代理的典型使用场景。

动态代理 VS 静态代理

动态代理和静态代理的最大的区别是:静态代理是编译期确定的代理类,但是动态代理却是运行期确定的代理类,也就是说:

- 静态代理其实就是事先写好代理类,可以手工编写也可以使用工具生成,但它的缺点是每个业务类都要对应一个代理类,特别不灵活,也不方便。

- 动态代理是在程序运行期,动态的创建目标对象的代理对象,并对目标对象中的方法进行功能性增强的一种技术。

所以,动态代理和静态代理的效果都是一样的,但静态代理使用麻烦,而动态代理使用简单,后者也是现在编程中实现代理的主流方式。

# BIO、NIO、AIO有什么区别?同步非阻塞和异步非阻塞有什么区别?

IO(Input/Output)是指输入/输出,用于描述计算机与外部设备(如文件、网络、键盘、显示器等)之间的数据交换过程。

计算机在运行过程中,需要与外部世界进行数据的输入和输出。例如,从文件中读取数据、将数据写入到网络传输中、从键盘接收用户的输入等都属于 IO 操作。

需要 IO 的主要原因是:

- 数据持久化:将数据从内存写入到磁盘或其他存储介质中,实现数据的持久化和长期存储。

- 数据交互:与外部设备进行数据的输入和输出,在计算机与用户、计算机与计算机之间传输数据。

- 程序与外部设备的交互:程序需要和外部设备(如键盘、鼠标、显示器、网络等)进行交互,接收用户输入,展示输出结果。

IO 操作是计算机系统中的重要组成部分,它通过数据的输入和输出实现了与外部设备的交互和数据的持久化。在计算机软件开发和系统运行中,IO 是不可或缺的一部分。

简单来说,BIO 就是传统 IO 包,它诞生的最早,但它是同步、阻塞的;所以在 JDK 1.4 又有了 NIO, NIO 是对 BIO 的改进提供了多路复用的同步非阻塞 IO,而 AIO 是 NIO 的升级,提供了异步非阻塞 IO。

它们的具体区别如下:

- BIO(Blocking I/O):同步阻塞 IO,传统的 java.io 包,它是基于流模型实现的,交互的方式是同步阻塞方式,也就是说在读入输入流或者输出流时,在读写动作完成之前,线程会一直阻塞在那里,它们之间的调用是可靠的线性顺序。它的优点是代码比较简单、直观;缺点是 IO 的效率和扩展性很低,容易成为应用性能瓶颈。

- NIO(Non-blocking I/O):同步非阻塞 IO,Java 1.4 引入的 java.nio 包,提供了 Channel、Selector、Buffer 等新的抽象,可以构建多路复用的、同步非阻塞 IO 程序,同时提供了更接近操作系统底层高性能的数据操作方式。

- AIO(Asynchronous I/O):异步非阻塞 IO,Java 1.7 之后引入的包,是 NIO 的升级版本,异步 IO 是基于事件和回调机制实现的,也就是应用操作之后会直接返回,不会堵塞在那里,当后台处理完成,操作系统会通知相应的线程进行后续的操作。

所以,简单来说:BIO 是同步阻塞 IO;NIO 是同步非阻塞 IO;AIO 是异步非阻塞 IO。

同步非阻塞和异步非阻塞有什么区别?

同步非阻塞和异步非阻塞最大的区别是,同步非阻塞通常使用轮询的方式来获取结果,然后再执行下一步操作。而异步非阻塞注册了异步事件之后,就去做其他事去了(无需一直轮询获取结果),当程序执行返回结果后,操作系统或程序会调用异步回调方法继续后续流程的执行。例如 NIO 就是同步非阻塞 IO,而 AIO 则属于异步非阻塞 IO。

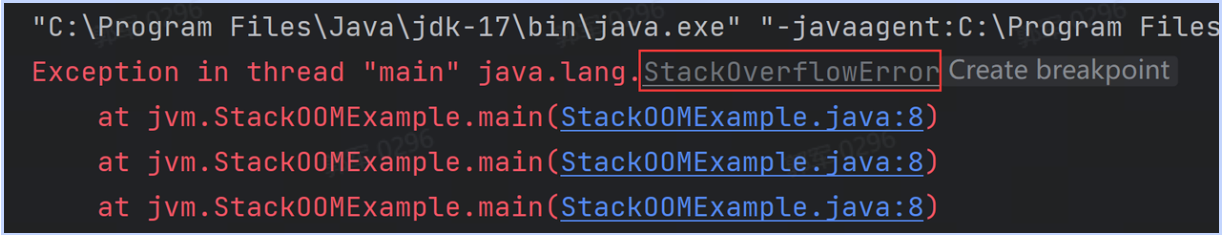

# Exception和Error有什么关联和区别?

Exception 和 Error 的关联是,它们都是继承了 Throwable 类(都属于 Throwable 类的子类),在 Java 中只有 Throwable 类型的实例才可以被抛出(throw)或者捕获(catch),它是异常处理机制的基本组成类型。

它们的区别主要有以下几点:

- 级别不同:Exception 是表示可恢复的异常情况,而 Error 表示不可恢复的严重错误。

- 来源不同:Exception 通常由应用程序代码引起,表示可预料的异常情况,如输入错误、文件不存在等。而 Error 通常由 Java 虚拟机(JVM)引起,表示严重的系统层面的错误(如内存溢出、栈溢出等),通常无法通过代码来处理。

- 代码处理不同:Exception 通常需要程序员在代码中明确地捕获并处理,以防止应用程序的崩溃或异常终止。而 Error 通常是无法通过代码处理的,它表示系统出现了严重的问题,无法恢复。

- 程序影响不同:Exception 是一种正常的控制流程,可能会影响应用程序的正常执行,但不会导致应用程序终止。而 Error 是一种严重的问题,可能会导致应用程序的崩溃或终止。

也就是说,Exception 和 Error 的关联是,它们都是继承了 Throwable 类(都属于 Throwable 类的子类),而 Exception 表示可以通过代码处理的可恢复的异常情况,通常由应用程序引起;而 Error 表示不可恢复的严重错误,通常由 Java 虚拟机(JVM)引起,无法通过代码处理。

# 抽象类和接口有什么区别?

接口和抽象类都是用来定义对象公共行为的,二者的主要区别有以下几点不同:

- 类型扩展不同:抽象类是单继承,而接口是多继承(多实现)。

- 方法/属性访问控制符不同:抽象类方法和属性使用访问修饰符无限制,只是抽象类中的抽象方法不能被 private 修饰;而接口有限制,接口默认的是 public 控制符,不能使用其他修饰符。

- 方法实现不同:抽象类中的普通方法必须有实现,抽象方法必须没有实现;而接口中普通方法不能有实现(不考虑 JDK 8 中 defualt 默认方法)。

- 使用目的不同:接口是为了定义规范,而抽象类是为了复用代码。

使用抽象类是用了复用代码,而使用接口是为了定义规范。它和接口的区别主要体现在:类型扩展不同、方法/属性访问控制符不同、方法实现不同,以及使用目的不同。

# 二. 集合模块

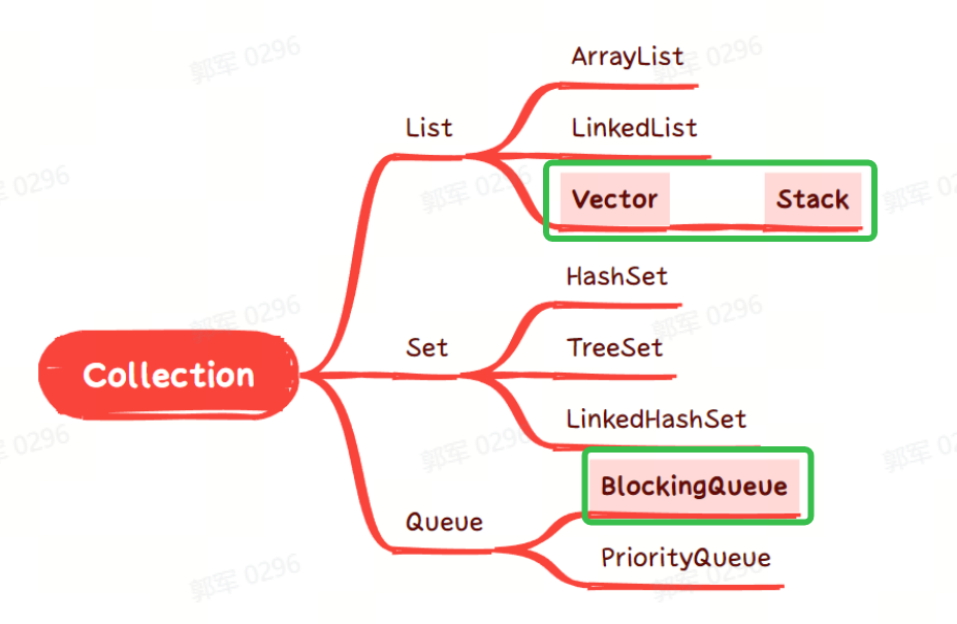

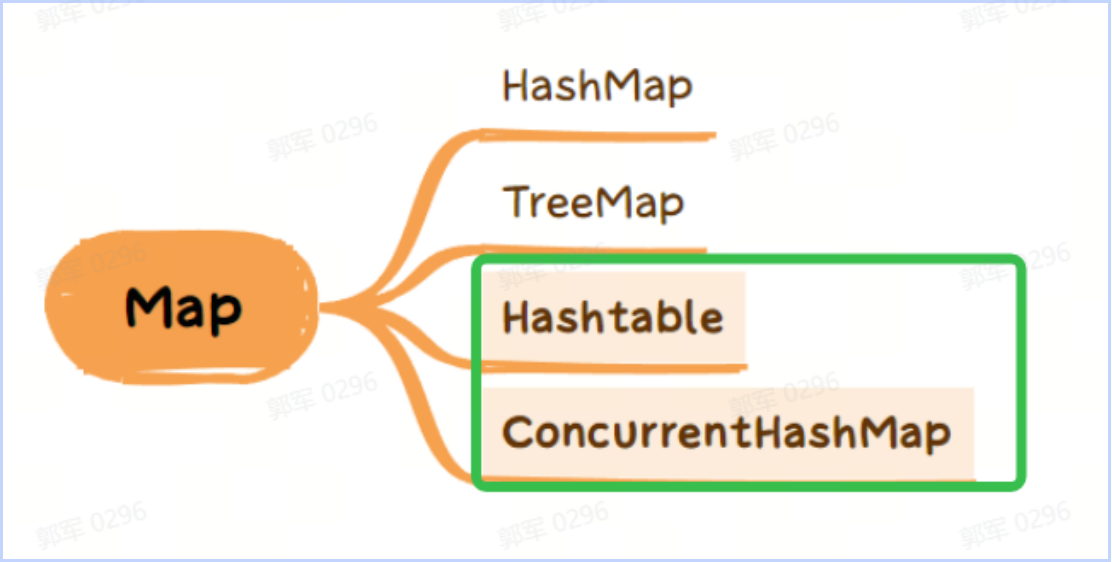

# Java中线程安全的容器有哪些?它们分别是怎么保证安全性的?

Java 中常见的线程安全的容器有以下这些(绿色勾中的为安全容器,其他为非安全容器):

- Vector 和 Stack 是通过 synchronized 加锁写入方法来保证线程安全的。

- BlockingQueue 是通过 ReentrantLock 来保证线程安全的,如下图所示(ArrayBlockQueue 是 BlockingQueue 的子类):

- Hashtable 是通过 synchronized 保证线程安全的。

- ConcurrentHashMap JDK 1.7 是通过分段锁保证线程安全的,之后是通过 synchronized 或 CAS 保证线程安全的。

# ArrayList和LinkedList有什么区别?

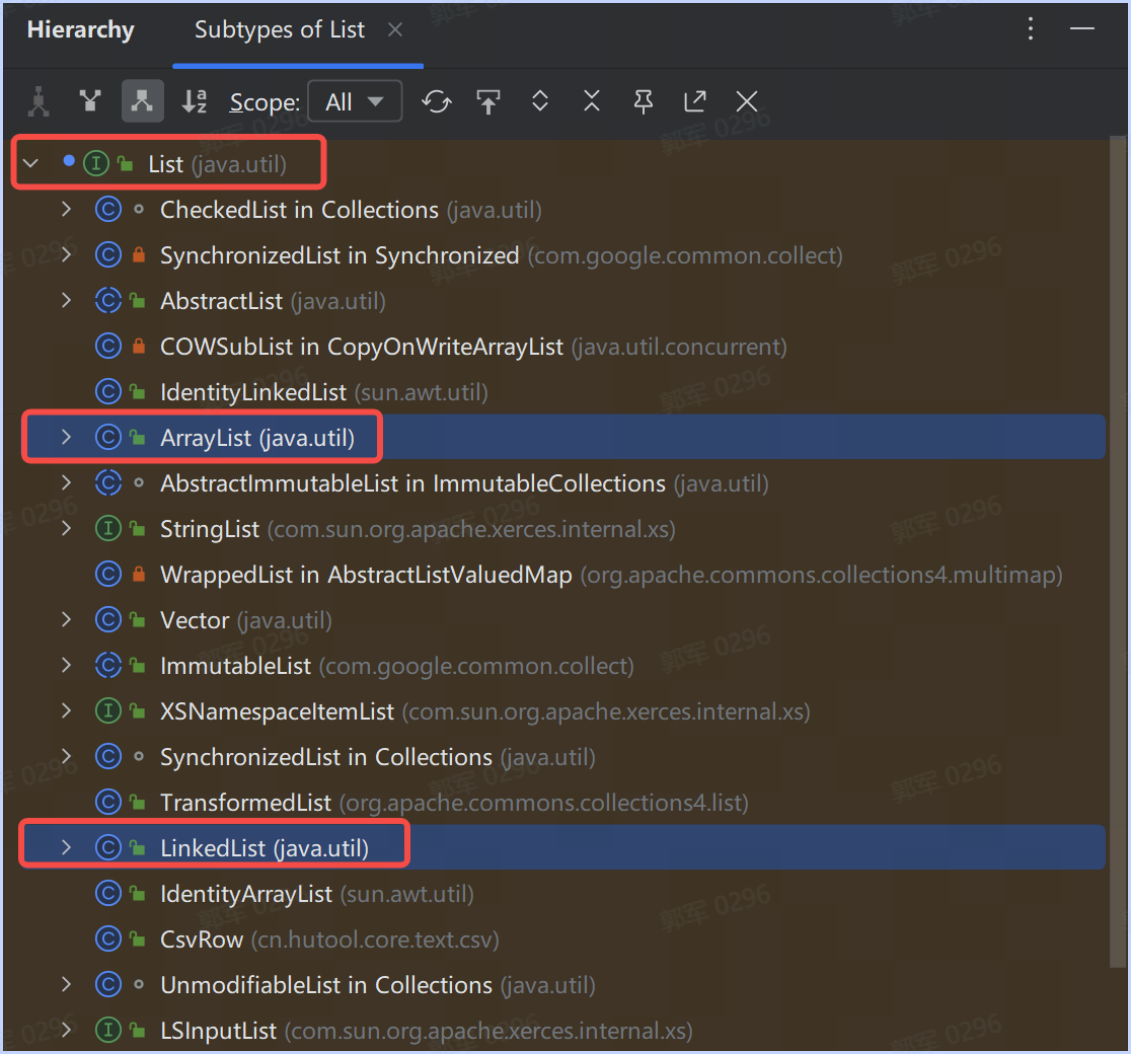

ArrayList 和 LinkedList 是 Java 中常用的集合类,它们都实现了 List 接口,如下图所示:

但二者有以下几点不同:

底层数据结构实现不同:

- ArrayList 底层使用数组实现,它通过一个可调整大小的数组来存储元素。

- LinkedList 底层使用双向链表实现,它通过链表节点来连接元素。

插入和删除的效率不同:

- ArrayList 对于插入和删除操作的性能相对较低,因为需要进行元素的移动和数组的重新分配,尤其是在 ArrayList 列表最前面插入和删除时,效率最慢。

- LinkedList 对于插入和删除操作会比 ArrayList 更好,因为它只需要修改相邻节点的指针即可。

随机访问效率不同:

- ArrayList 对于随机访问(根据索引获取元素)具有更好的性能,因为可以通过索引直接计算元素在数组中的位置,时间复杂度为 O(1)。

- LinkedList 对于随机访问的性能较差,需要通过链表节点一个个遍历找到对应的索引位置,时间复杂度为 O(n)。

内存要求和占用空间大小不同:

- ArrayList 在内存中需要连续的存储空间,因此在存储大量数据时,需要有大块的连续内存空间,所以对内存要求较高(不能有太多的内存碎片)。

- LinkedList 不要求有连续的内存空间,它的链表是逻辑的先后顺序,每个元素用额外的空间来存储指向前、后的节点指针,所以,LinkedList 相对而言会占用更多的内存空间。

因此,在多查的场景下考虑使用 ArrayList,而在插入和删除比较多的场景下考虑使用 LinkedList。

# HashMap底层是如何实现的?

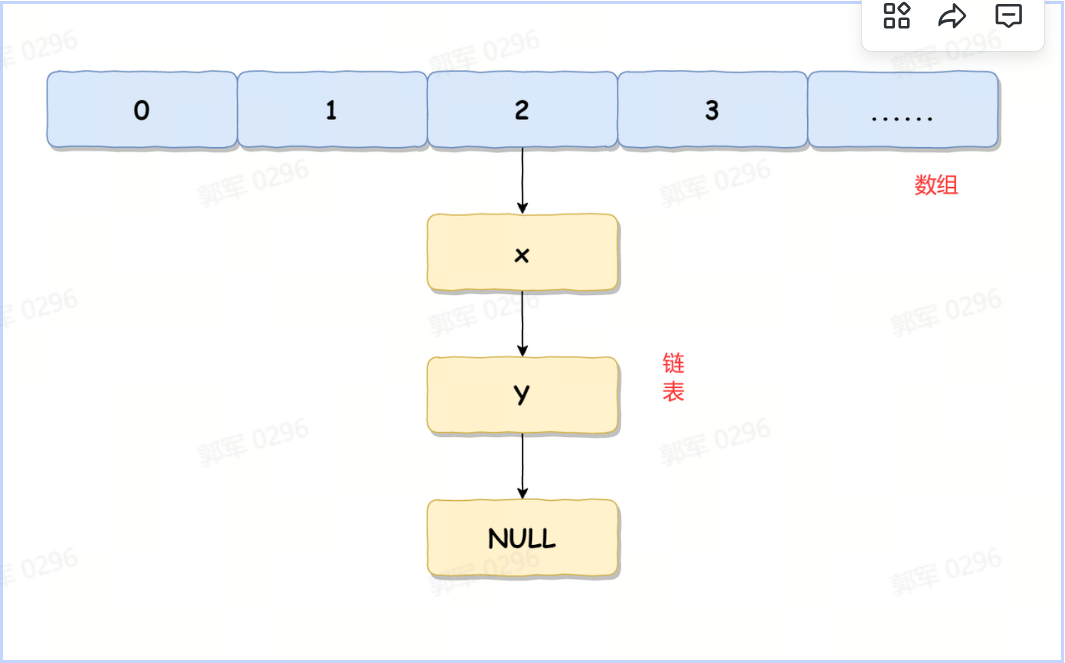

不同的 JDK 版本,HashMap 的底层实现是不一样的,总体来说:在 JDK 1.8 之前(不包含 JDK 1.8),HashMap 使用的是数组 + 链表实现的,而 JDK 1.8 之后(包含 JDK 1.8)使用的是数组 + 链表或红黑树实现的。

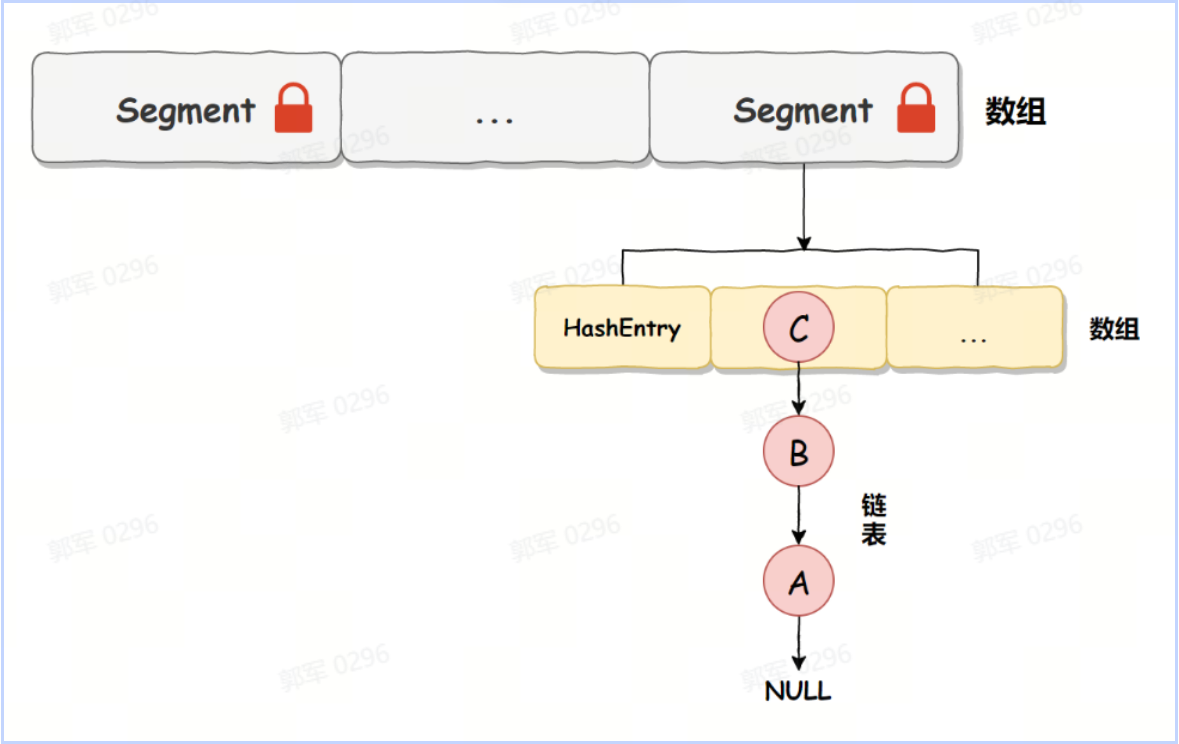

HashMap 在 JDK 1.8 以前(不包含 JDK 1.8)的版本中的实现如下图所示:

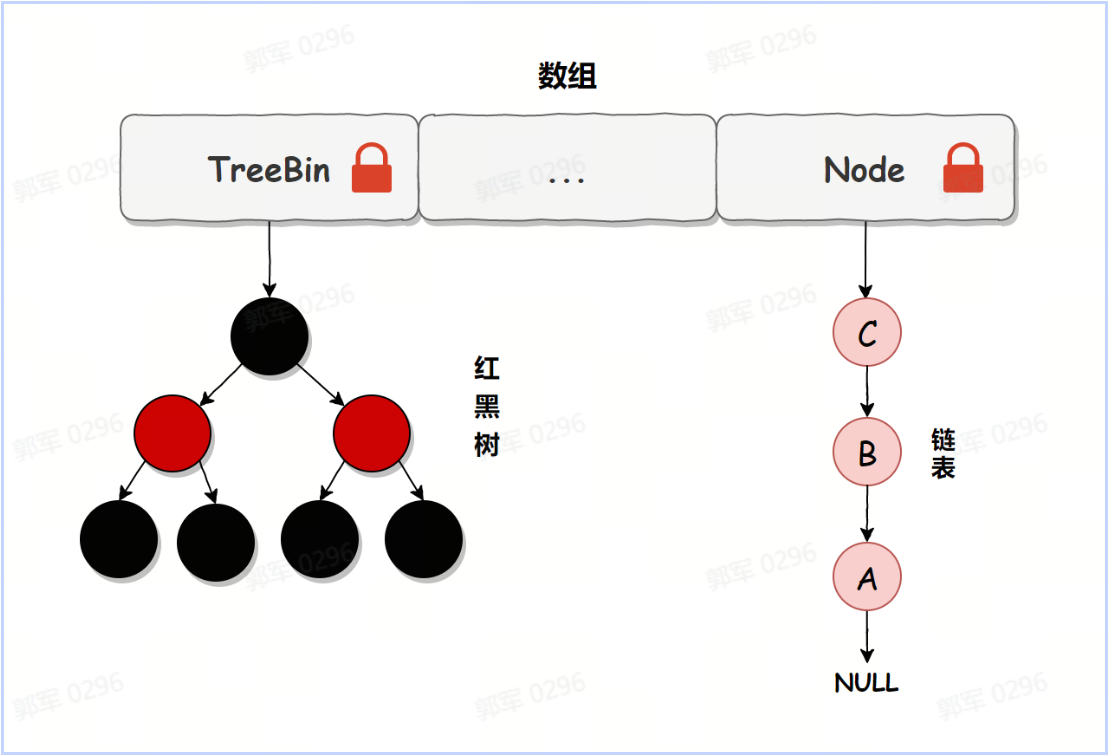

HashMap 在 JDK 1.8+ 中(包含 JDK 1.8)的实现如下图所示:

HashMap 在 JDK 1.8 之前(不包含 JDK 1.8),使用的是数组 + 链表实现的;而 JDK 1.8 之后(包含 JDK 1.8)使用的是数组 + 链表或红黑树实现的。

# HashMap为什么要使用红黑树而非其他数据结构来存储数据?

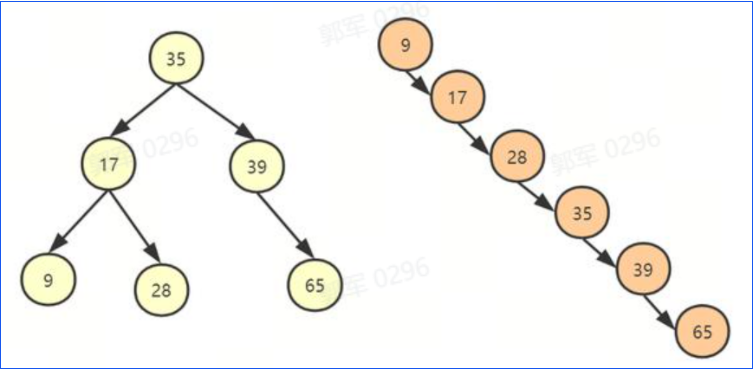

HashMap 中之所以使用红黑树,是因为红黑树最合适做 HashMap 多节点的数据存储和查询。因为使用二叉搜索树在某些情况下会退化为链表,所以它的查询效率可能会存在问题;而使用 AVL 树,在添加或删除时,效率又不如红黑树,所以选择使用红黑树是 HashMap 最合适的选择。

为什么要这么说呢?

我们这里采用排除法来帮你理解这个问题,对于 HashMap 而言,我们可以使用以下数据结构来进行数据的存储:

二叉搜索树(Binary Search Tree):是一种特殊的二叉树,每个节点的左子树上的节点值都小于该节点的值,右子树上的节点值都大于该节点的值。但二叉搜索树在极端的情况下会退化成链表结构,所以并不是最适合的存储结构。

AVL 树(Balanced Binary Tree):在二叉搜索树的基础上,增加了平衡性的要求,保持左右子树的高度差不超过 1,通过旋转操作来保持树的平衡。但是因为 AVL 树插入节点或者删除节点,整体的性能不如红黑树,所以也不是最合适的选择。在 AVL 树中,每个节点的平衡因子是其左子树高度和右子树高度的差值。平衡因子只能为 -1、0、1,任何节点的平衡因子超过这个范围,就需要通过旋转操作进行平衡调整,使得整个树重新平衡。而红黑树的平衡要求相对宽松,插入和删除操作会导致较少的旋转操作,因此在频繁的插入和删除操作场景下,红黑树的性能可能略优于 AVL 树。

红黑树(Red-Black Tree):也是一种具有平衡性质的二叉搜索树。通过约束节点的颜色(红色或黑色)和一些平衡性质来保持树的平衡。红黑树它的查找性能接近于 AVL 树,但增、删节点的效率又优于 AVL 树,因此使用红黑树替代链表是 HashMap 最佳的选择。

所以综合来看,HashMap 因为数据量相对来说比较少,所以使用红黑树是最合适的选择(比二叉搜索树查询快,而 AVL 树插入和删除效率高),数据量也不会像 MySQL 中的表一样有很多的数据,所以用不上结构更复杂的多叉树,那么红黑树就是最好的选择了。

# 什么是负载因子?它的值为什么是0.75?

负载因子(Load Factor)也叫扩容因子,它是一个用于控制 HashMap 何时进行扩容的参数。当 HashMap 中存储的键值对数量,超过了 HashMap 总容量乘以扩容因子时,HashMap 就会进行扩容操作。

例如 HashMap 的总容量为 16,扩容因子为 0.75,那么当 HashMap 中存储的键值对大于 12(16*0.75)时,HashMap 就会进行扩容。

PS:负载因子的值是 0 到 1 之间(大于 0,小于 1)。

为什么负载因子是 0.75?

- 当负载因子比较大的时候,那么扩容就会比较晚,空间利用率就会比较高,但发生哈希冲突的概率就会增大,那么插入的时间就会变长;

- 当负载因子比较小的时候,那么扩容会比较早,发生哈希冲突的概率会变小,插入的时间会变快,但空间利用率就会很低。

因此选择 0.75 是空间和时间效率的一种平衡。

# HashMap是线程安全的吗?说下具体原因?

HashMap 是线程不安全的,原因主要体现在以下两个方面:

HashMap 在 JDK 1.7 之前(包含 JDK 1.7)它线程不安全的原因体现在两个方面:

- HashMap 可能会造成环形链表,导致程序执行死循环。

- 多线程下并发执行,可能会导致数据覆盖。 HashMap 在 JDK 1.8 之后(包含 JDK 1.8)不再有死循环问题,但依旧存在数据覆盖问题。

所以,HashMap 是线程不安全的。

# HashMap会导致CPU 100%?什么场景下会出现这个问题?

HashMap 在极端情况下可能会导致 CPU 100%,这个问题出现在 JDK 1.8 之前,当链表在多线程并发扩容时,可能会导致链表死循环,而死循环会导致 CPU 一直执行,从而慢慢飙升为 100% 的情况,发生这种情况,需要同事满足以下三个条件:

多线程同时执行添加操作。

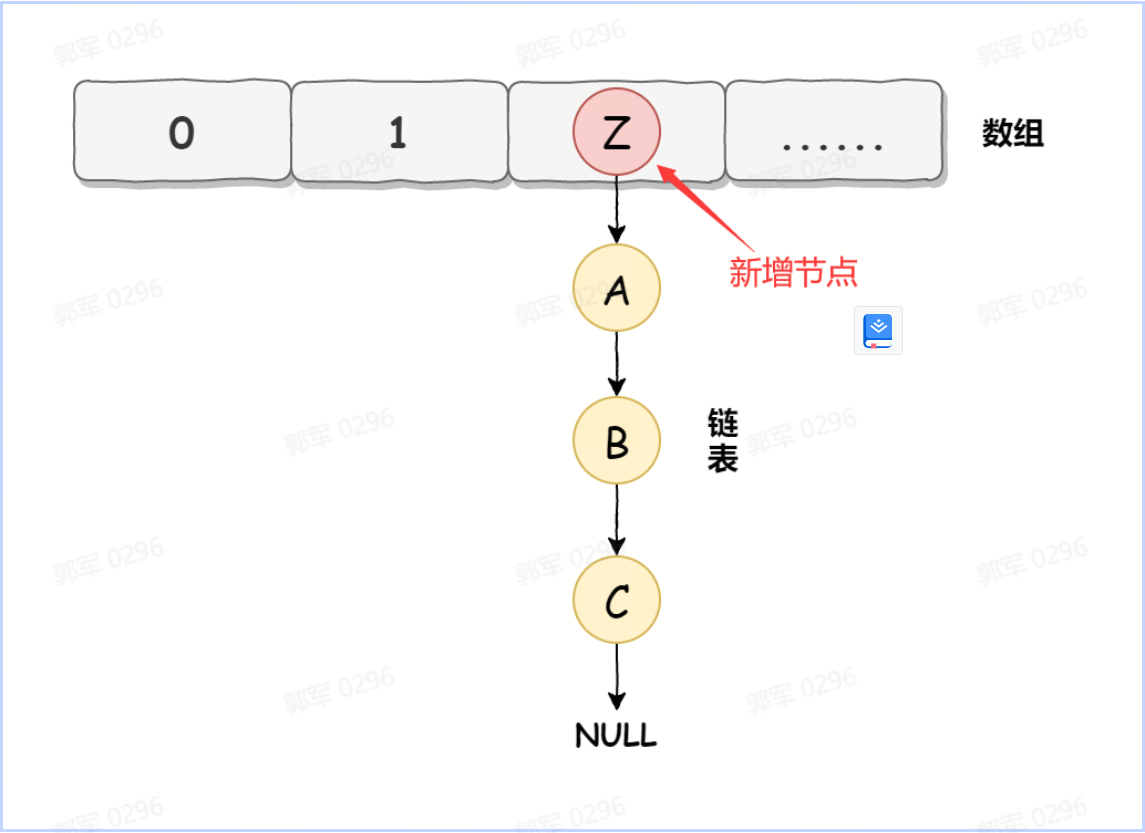

触发 HashMap 扩容机制。 JDK 1.7 之前(包含 JDK 1.7)采用的是头插法。 以下是 HashMap 发生死循环的具体过程。 在 JDK 1.7 中 HashMap 的底层数据实现是数组 + 链表的方式,如下图所示:

而 HashMap 在数据添加时使用的是头插入,如下图所示:

而 HashMap 在数据添加时使用的是头插入,如下图所示:

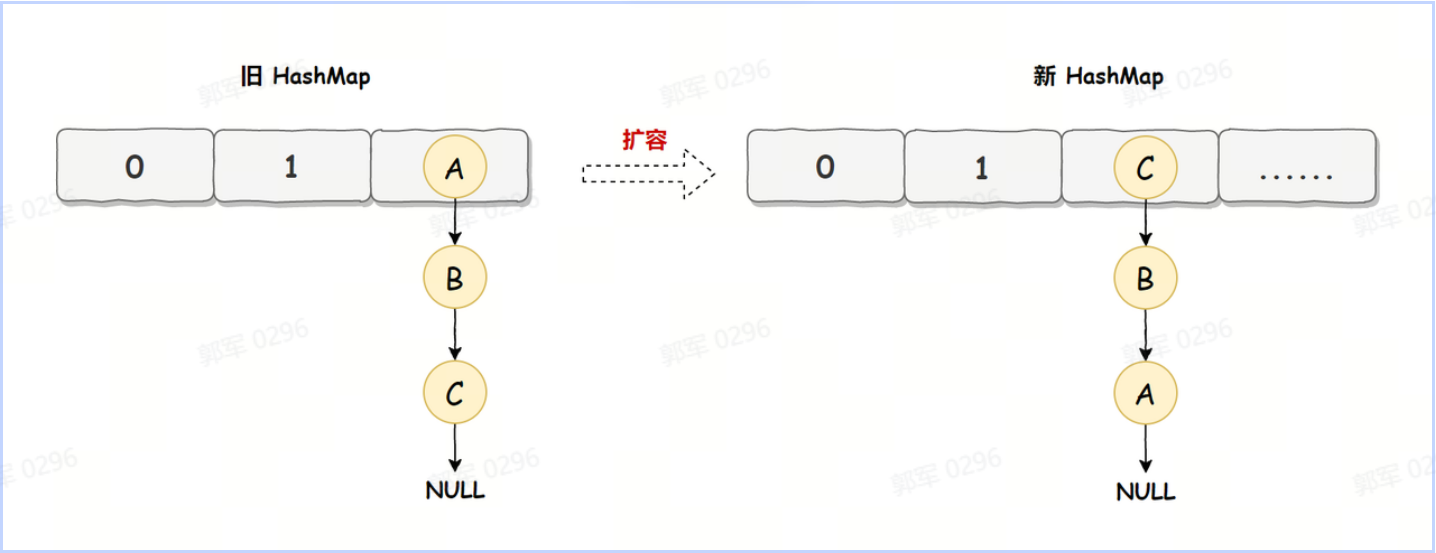

HashMap 正常情况下的扩容实现如下图所示:

HashMap 正常情况下的扩容实现如下图所示:

旧 HashMap 的节点会依次转移到新 HashMap 中,旧 HashMap 转移的顺序是 A、B、C,而新 HashMap 使用的是头插法,所以最终在新 HashMap 中的顺序是 C、B、A,也就是上图展示的那样。有了这些前置知识之后,咱们来看死循环是如何诞生的?

旧 HashMap 的节点会依次转移到新 HashMap 中,旧 HashMap 转移的顺序是 A、B、C,而新 HashMap 使用的是头插法,所以最终在新 HashMap 中的顺序是 C、B、A,也就是上图展示的那样。有了这些前置知识之后,咱们来看死循环是如何诞生的?死循环执行步骤1

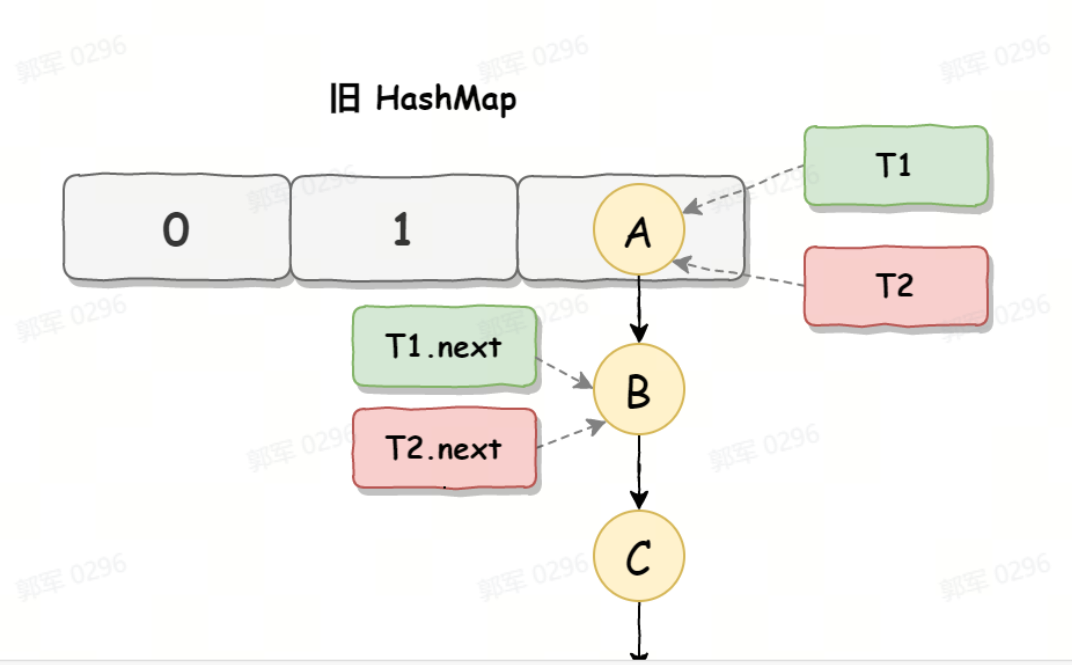

死循环是因为并发 HashMap 扩容导致的,并发扩容的第一步,线程 T1 和线程 T2 要对 HashMap 进行扩容操作,此时 T1 和 T2 指向的是链表的头结点元素 A,而 T1 和 T2 的下一个节点,也就是 T1.next 和 T2.next 指向的是 B 节点,如下图所示:

死循环执行步骤2

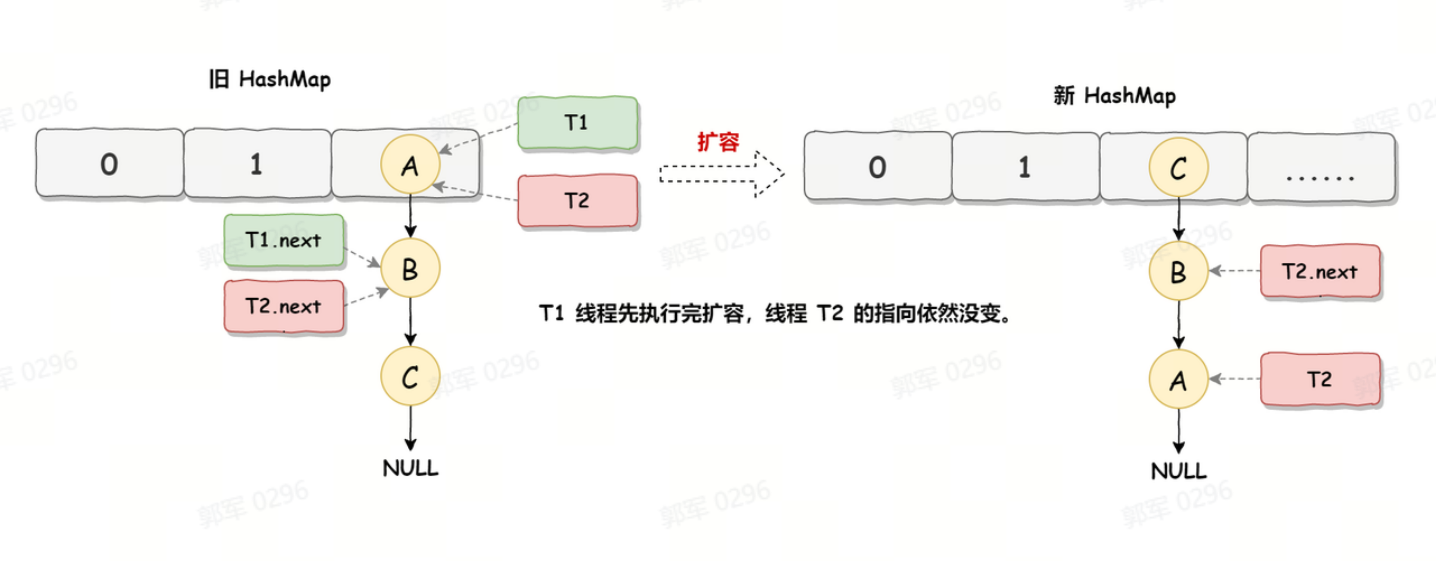

死循环的第二步操作是,线程 T2 时间片用完进入休眠状态,而线程 T1 开始执行扩容操作,一直到线程 T1 扩容完成后,线程 T2 才被唤醒,扩容之后的场景如下图所示:

从上图可知线程 T1 执行之后,因为是头插法,所以 HashMap 的顺序已经发生了改变,但线程 T2 对于发生的一切是不可知的,所以它的指向元素依然没变,如上图展示的那样,T2 指向的是 A 元素,T2.next 指向的节点是 B 元素。

从上图可知线程 T1 执行之后,因为是头插法,所以 HashMap 的顺序已经发生了改变,但线程 T2 对于发生的一切是不可知的,所以它的指向元素依然没变,如上图展示的那样,T2 指向的是 A 元素,T2.next 指向的节点是 B 元素。死循环执行步骤3

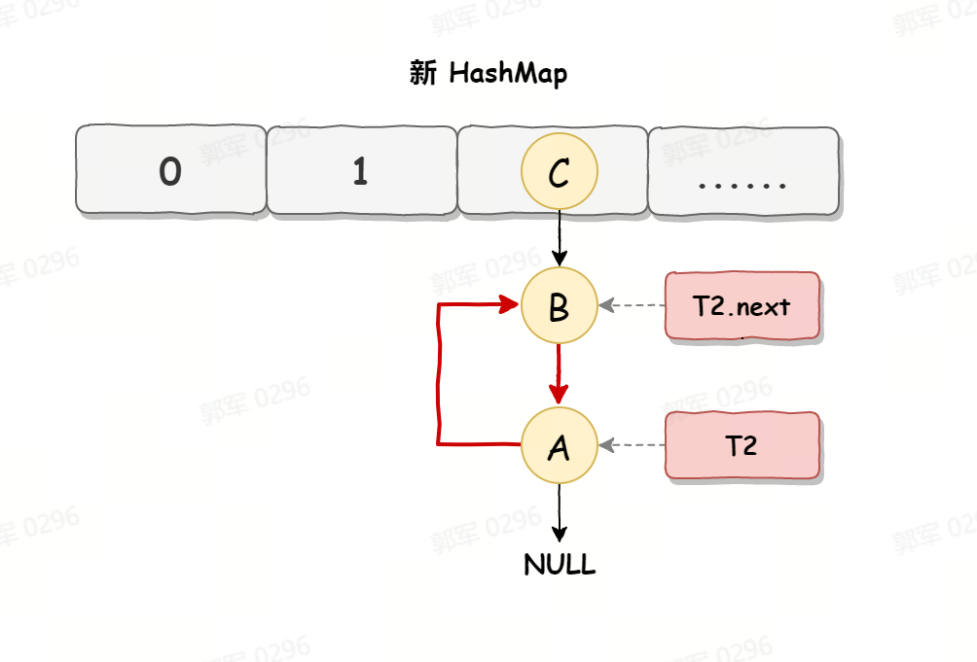

当线程 T1 执行完,而线程 T2 恢复执行时,死循环就建立了,如下图所示:

因为 T1 执行完扩容之后 B 节点的下一个节点是 A,而 T2 线程指向的首节点是 A,第二个节点是 B,这个顺序刚好和 T1 扩完容完之后的节点顺序是相反的。T1 执行完之后的顺序是 B 到 A,而 T2 的顺序是 A 到 B,这样 A 节点和 B 节点就形成死循环了,这就是 HashMap 死循环导致的原因。

# 什么是哈希冲突?如何解决哈希冲突?

哈希冲突(Hash Collision)是指不同的输入数据在进行哈希函数计算后,得到相同的哈希值的情况。由于哈希函数是将输入映射到一个有限的哈希表中,而输入的数据量可能是无限的,所以在特定的哈希函数和哈希表大小的限制下,哈希冲突是难以避免的。

解决哈希冲突的常见方法有以下几种:

- 链地址法(Separate Chaining):将哈希表中的每个桶都设置为一个链表,当发生哈希冲突时,将新的元素插入到链表的末尾。这种方法的优点是简单易懂,适用于元素数量较多的情况。缺点是当链表过长时,查询效率会降低。

- 再哈希法(Rehashing):当发生哈希冲突时,使用另一个哈希函数计算出一个新的哈希值,然后将元素插入到对应的桶中。这种方法的优点是简单易懂,适用于元素数量较少的情况。缺点是需要额外的哈希函数,且当哈希函数不够随机时,容易产生聚集现象。

- 开放地址法(Open Addressing):当发生哈希冲突时,就去寻找下一个空的哈希地址,只要哈希表足够大,空的哈希地址总能找到,之后再将数据进行存储。

在 Java 的 HashMap 中,是通过链地址法来解决哈希冲突的。

# 说下HashMap的查询流程?

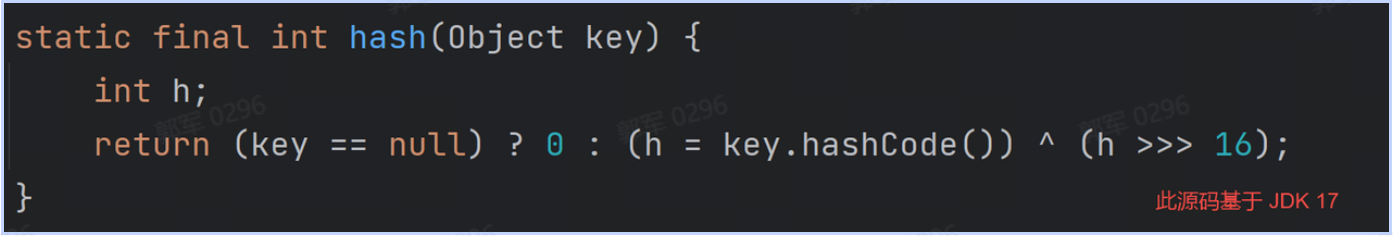

- 首先,根据要查询元素的键(Key)通过哈希函数计算出哈希值(Hash Value),哈希函数实现源码如下:

这行源码的主要含义是把哈希码按位异或哈希码右移 16 位的操作,让高位与低位混合,可以更好地分散元素在哈希表中的位置,减少哈希冲突的发生。

这行源码的主要含义是把哈希码按位异或哈希码右移 16 位的操作,让高位与低位混合,可以更好地分散元素在哈希表中的位置,减少哈希冲突的发生。 - 使用哈希值与哈希表的容量进行与操作(hash & (table.length-1)),得到元素在哈希表中的位置,即索引。

- 在该索引位置上,如果没有任何元素,则说明哈希表中不存在该键对应的元素,查询失败。

- 如果该索引位置上存在元素(可能是一个元素或者一个链表/红黑树),则进行以下操作:

- 如果仅有一个元素,则判断该元素的键是否与要查询的键相等。如果相等,则返回该元素的值;否则查询失败。

- 如果存在链表或红黑树,则遍历链表或红黑树,逐个比较键的值,找到与要查询的键相等的元素,并返回对应的值。

- 首先,根据要查询元素的键(Key)通过哈希函数计算出哈希值(Hash Value),哈希函数实现源码如下:

# HashMap和Hashtable有什么区别?

HashMap 和 Hashtable 都实现了 Map 接口,都是用来存储键值对的数据结构。

它们的区别主要有以下几点:

- 线程安全性:HashMap 是非线程安全的,而 Hashtable 是线程安全的。

- null 键和 null 值的支持:HashMap 允许键和值都为 null,即可以插入 null 键和 null 值;而 Hashtable 不允许键或值为 null,如果尝试插入 null 键或 null 值,会抛出NullPointerException。

- 性能:由于 HashMap 不是线程安全的,在单线程环境下通常有更好的性能。Hashtable 是线程安全的,但会带来额外的同步开销,因此在单线程环境下性能可能较差。

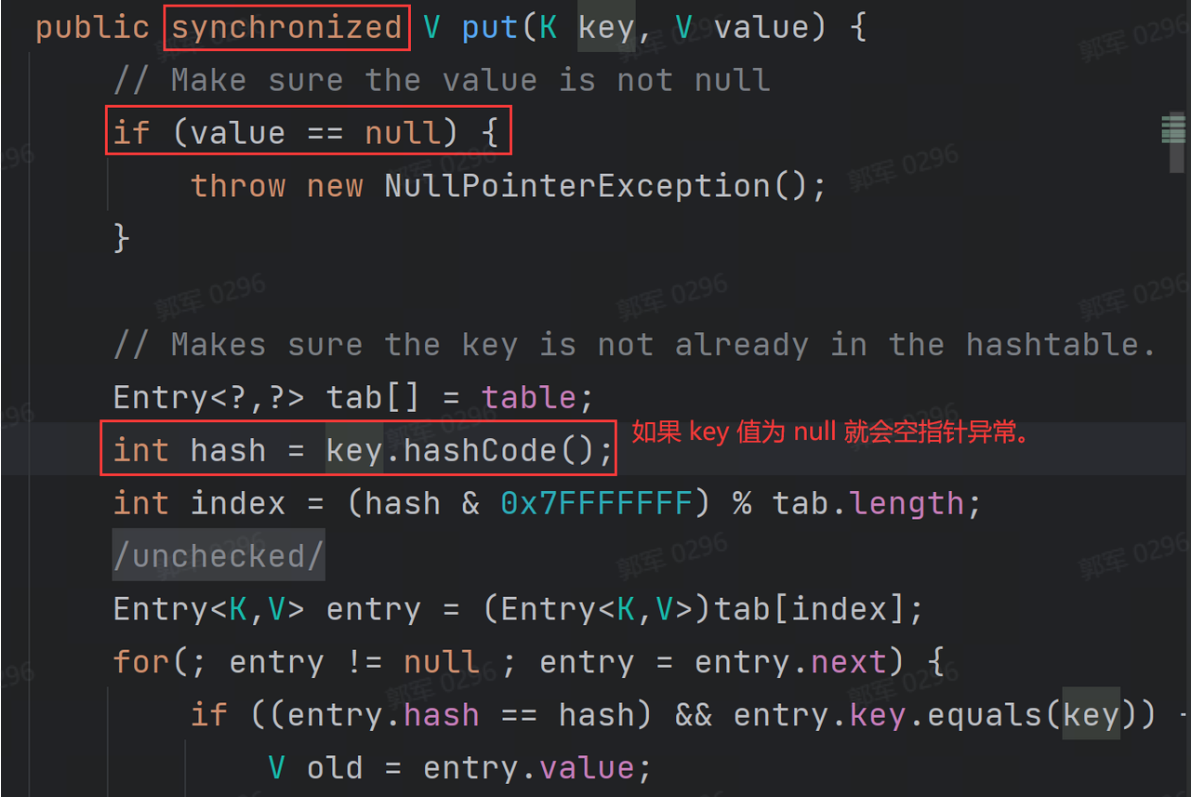

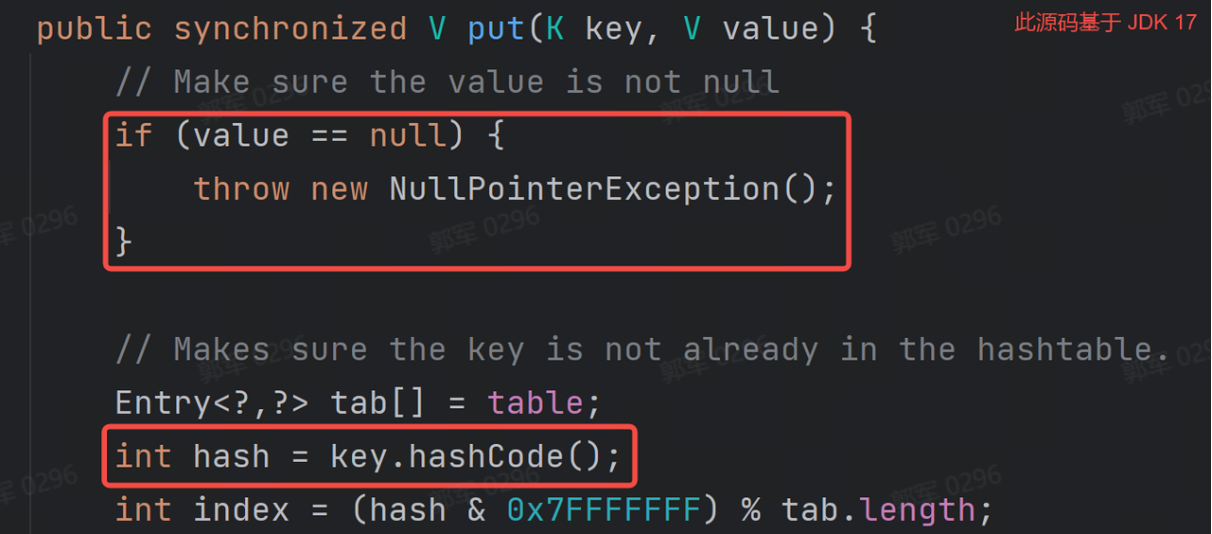

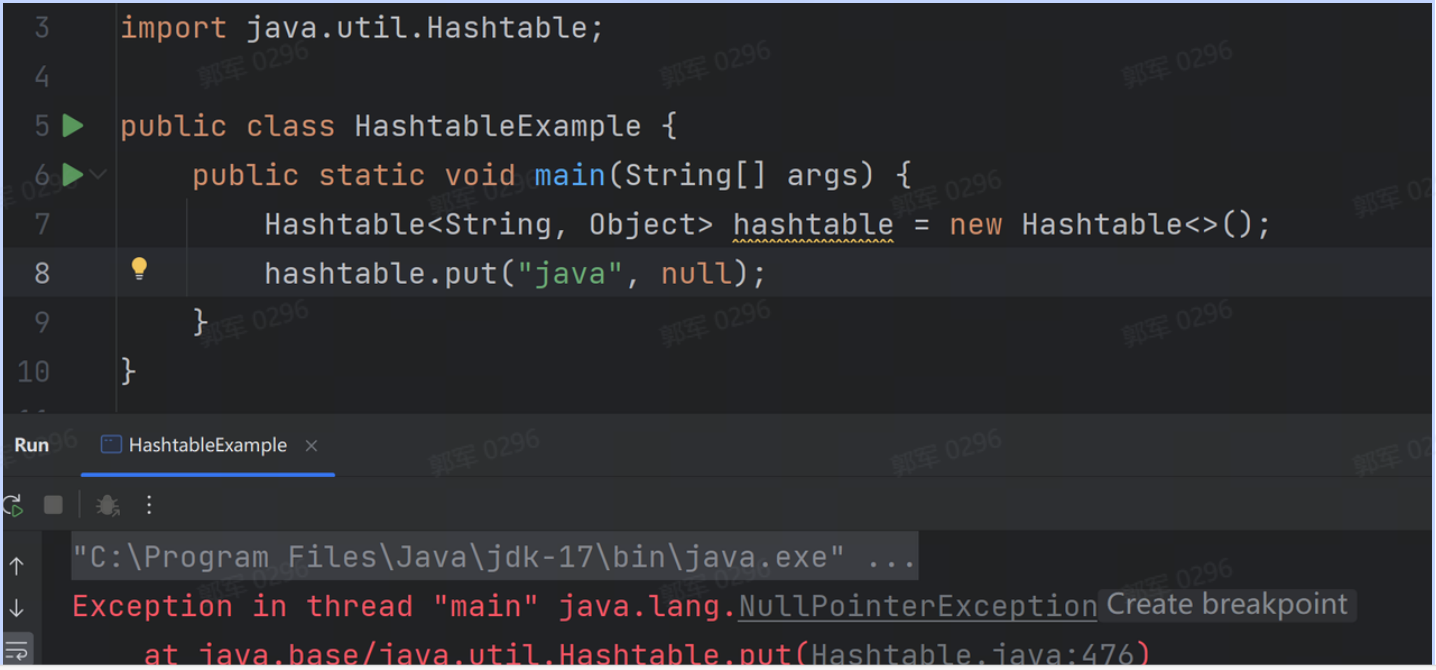

# 为什么Hashtable不允许插入null?而HashMap却可以?

浅层次的来回答这个问题的答案是,JDK 源码不支持 Hashtable 插入 value 值为 null,如以下 JDK 源码所示:

也就是 JDK 源码规定了,如果你给 Hashtable 插入 value 值为 null 就会抛出空指针异常。

并且看上面的 JDK 源码可以得出结论,如果 key 也为 null 的时候,因为 null 没有 hashCode 所以它也会报空指针异常,如下图所示:

也就是 JDK 源码规定了,如果你给 Hashtable 插入 value 值为 null 就会抛出空指针异常。

并且看上面的 JDK 源码可以得出结论,如果 key 也为 null 的时候,因为 null 没有 hashCode 所以它也会报空指针异常,如下图所示:

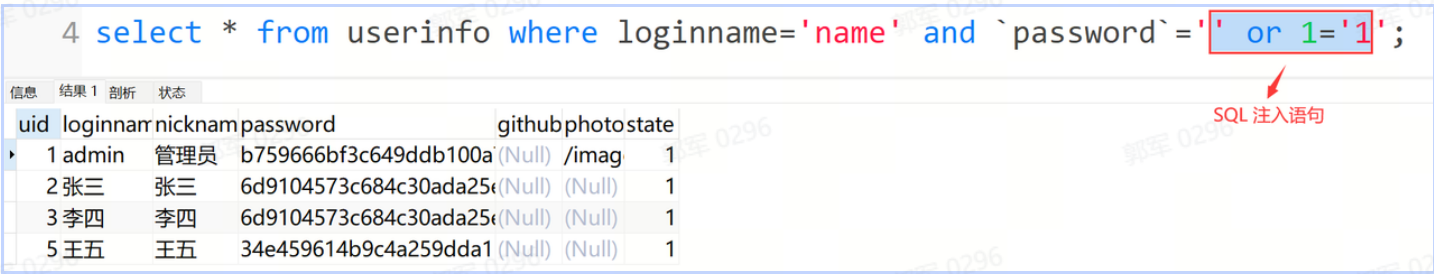

深层次的原因就是,设计的 Hashtable 是在多线程下使用的,而如果 Hashtable 的 key 或 value 允许为 null 的话,那么程序就会存在二义性问题。 如果我们假设 Hashtable 允许插入 null,那么此时它就会有二义性问题,这个 null 值就有两层含义: 这个 key 不存在,所以返回 null。 key 存在,并且值本身就为 null,所以返回的就是 null。 而在多线程下,你没有办法证明真伪,因为你在判断证明的时候,其他线程可能同时做了修改,所以不能被证明的二义性问题需要从源头上杜绝,所以多线程下的 Hashtable 是不允许 key 和 value 插入 null 值的。

ConcurrentHashMap 也是不允许插入 null,原因和 Hashtable 是一样的(因为有二义性问题)。

为什么 HashMap 允许插入 null 值?

因为 HashMap 设计是在单线程下使用的,而单线程可以证明真伪,它在进行查询判断的时候,不用担心有其他线程对这个值同时做修改,所以它不存在二义性问题,所以 HashMap 允许 key 和 value 都为 null。

# ConcurrentHashMap是怎么保证线程安全的?

ConcurrentHashMap 在不同 JDK 版本中,保证线程安全的手段是不同的,它主要分为以下两种情况: JDK 1.7 之前(包含 JDK 1.7),ConcurrentHashMap 主要是通过分段锁(Segment Lock)来保证线程安全的。

而在 JDK 1.8 之后(包含 JDK 1.8),使用了粒度更小锁,通过在数组的头节点加锁来保证线程安全的,并且加锁的手段也进行了优化,它使用的是 CAS + volatile 或 synchronized 来保证线程安全的。

# 说一下ConcurrentHashMap锁优化?

ConcurrentHashMap 锁优化主要有以下两点:

- 锁粒度优化:JDK 1.7 ConcurrentHashMap 使用的是分段锁(加锁多个数组),而 JDK 1.8 之后是加锁一个数组的头节点。锁粒度更小,意味着在多线程并发环境下执行效率越高。

- 锁实现优化:JDK 1.7 使用的是 ReentrantLock 实现加锁的,而 JDK 1.8 使用的是 CAS 或 synchronized 来实现加锁的,CAS 是乐观锁的实现,相比于 ReentrantLock 和 synchronized 的悲观锁,性能得到了一定的优化。

# 三.并发模块

# 线程中 start() 方法和 run() 方法有什么区别?

start() 方法是用来启动一个新线程的,而 run() 方法是一个普通方法,并不会重启线程,run() 方法中存放的是当前线程要执行的任务代码。 它们的区别主要有以下几点:

- 方法性质不同:run() 是一个普通方法,而 start() 是开启新线程的方法。

- 执行流程不同:调用 run() 方法会立即执行任务,而调用 start() 方法是将当前线程的状态,从新建状态改为就绪状态。此时它会等待操作系统调度器为其分配 CPU 时间片,一旦获得时间片,线程开始执行其 run() 方法中的代码了。

- 多次调用次数不同:run() 方法可以被重复多次调用,而 start() 方法只能被调用一次,如果被多次调用会抛出 IllegalThreadStateException 异常。

- 并发执行不同:调用 start() 方法会重启新线程,并发运行;而调用 run() 方法是在当前的主线程中执行,它依然是单线程执行的。

为什么 start() 方法不能被重复调用?

这个问题的浅层次原因是 JVM 不允许,当多次调用 start() 方法的时候程序会提示 IllegalThreadStateException 的异常,但为什么 JVM 会提示这个异常?

更深层次的原因是,线程生命周期管理的需要,因为在调用 start() 方法时,此线程的状态会从新建状态(NEW)变为就绪状态(RUNNABLE),JVM 会会为此线程分配必要的系统资源,如内存、程序计数器、线程栈等,此时如果允许多次调用 start() 方法的话,将会导致线程生命周期的混乱,也会让线程进入无

# 线程是如何通讯的?它的通讯方法有哪些?(说出你知道的所有通讯方法)

线程通信是指多个线程之间通过某种机制进行协调和交互,例如,线程等待和通知机制就是线程通讯的主要手段之一。 在 Java 中,线程通讯的实现方法主要有以下几种:

- Object 类下的 wait()、notify() 和 notifyAll() 方法。

- Condition 类下的 await()、signal() 和 signalAll() 方法。

- LockSupport 类下的 park() 和 unpark() 方法。

为什么一个线程通信机制需要这么多的实现方式呢?

我们先看每种通讯方式的使用,再讲原因。

① Object 类下的 wait()、notify() 和 notifyAll() 方法

- wait():让当前线程处于等待状态,并释放当前拥有的锁;

- notify():随机唤醒等待该锁的其他线程,重新获取锁,并执行后续的流程,只能唤醒一个线程;

- notifyAll():唤醒所有等待该锁的线程(锁只有一把,虽然所有线程被唤醒,但所有线程需要排队执行)。

② Condition 类下的 await()、signal() 和 signalAll() 方法

- await():对应 Object 的 wait() 方法,线程等待;

- signal():对应 Object 的 notify() 方法,随机唤醒一个线程;

- signalAll():对应 Object 的 notifyAll() 方法,唤醒所有线程。

③ LockSupport 下的 park() 和 unpark() 方法

- LockSupport.park():休眠当前线程。

- LockSupport.unpark(线程对象):唤醒某一个指定的线程。

PS:LockSupport 无需配锁(synchronized 或 Lock)一起使用。

为什么一个线程等待和唤醒的功能需要这么多的实现呢?

LockSupport 存在的必要性:前两种方法 notify 方法以及 signal 方法都是随机唤醒,如果存在多个等待线程的话,可能会唤醒不应该唤醒的线程,因此有 LockSupport 类下的 park 和 unpark 方法指定唤醒线程是非常有必要的。

Condition 存在的必要性:Condition 相比于 Object 类的 wait 和 notify/notifyAll

方法,前者可以创建多个等待集,例如,我们可以创建一个生产者等待唤醒对象,和一个消费者等待唤醒对象,这样我们就能实现生产者只能唤醒消费者,而消费者只能唤醒生产者的业务逻辑了,如下代码所示:

也就是 Condition 是 Object 等待唤醒模型的升级,Object 类可以实现的功能它都能实现,但 Condition 能实现的功能,Object 却不能实现,这就是 Condition 类存在的必要性。 那问题来了,为什么还有会 Object 的 wait 和 notify 方法呢? 因为 Object 类诞生的比较早,也就是说 Condition 和 LockSupport 都是 JDK 后期版本才出现的功能,所以就有了现在这么多线程唤醒和等待的方法了。

# 说一下线程的生命周期?

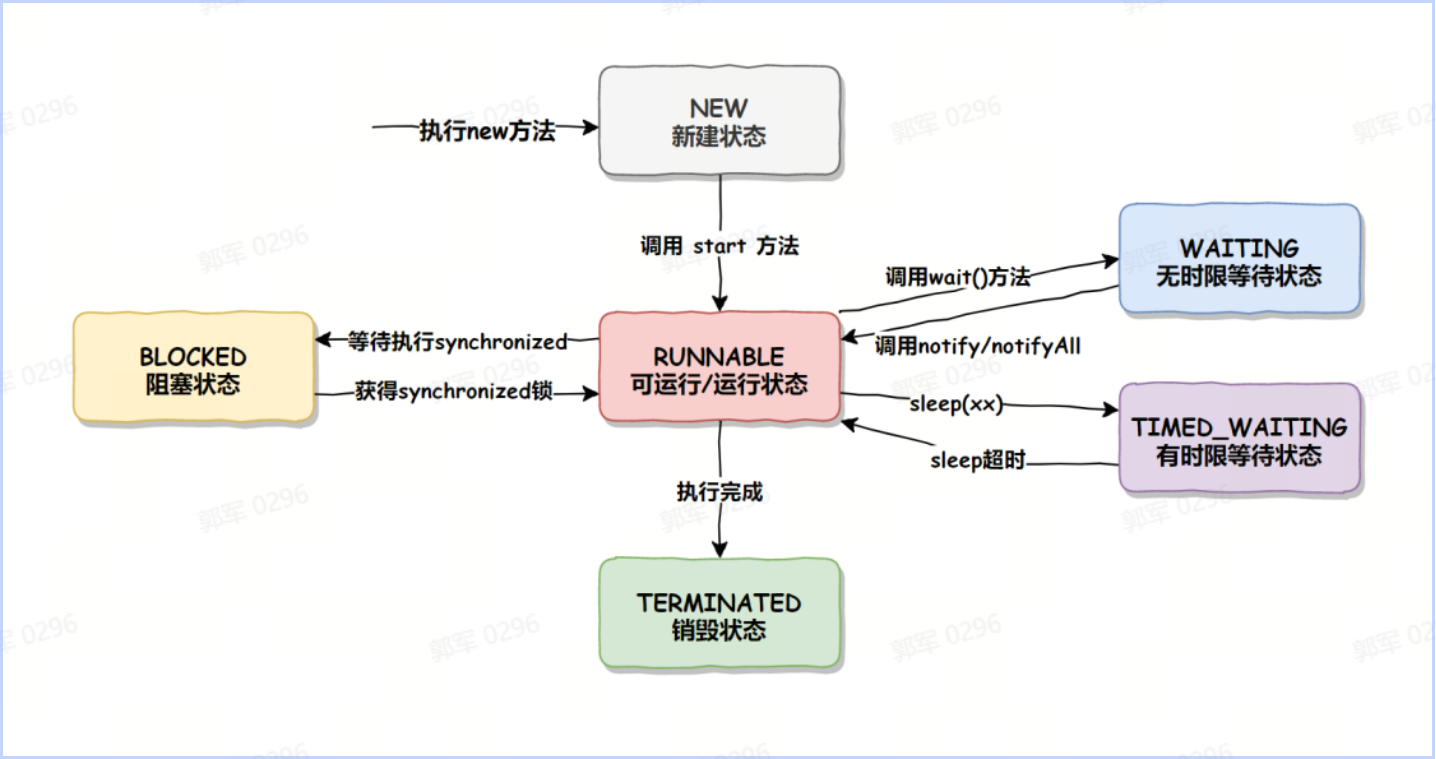

Java 线程的生命周期有以下 6 种:

- NEW(初始化状态)

- RUNNABLE(可运行/运行状态)

- BLOCKED(阻塞状态)

- WAITING(无时限等待状态)

- TIMED_WAITING(有时限等待状态)

- TERMINATED(终止状态)

PS:Java 线程状态可能和操作系统的状态叫法和分类是不同。

线程状态的转换如下图所示:

- NEW(新建状态):new Thread() 时线程的状态。

- RUNNABLE(可运行/运行状态):调用 start() 方法后的状态。

- BLOCKED(阻塞状态):调用了 synchronized 加锁之后的状态。获得锁之后就从 BLOCKED 状态变成了 RUNNABLE 状态。

- WAITING(无时限等待状态):调用了 wait() 方法之后会进入此状态。

- TIMED_WAITING(有时限等待状态):调用了 sleep(long millis) 方法之后会进入此状态。

- TERMINATED(终止状态):线程任务执行完成之后就变成此状态。

# 如何停止线程?

在 Java 中,停止线程是一个相对复杂的问题,因为线程的终止需要考虑多线程的同步和资源的正确释放。 而在 Java 中,停止线程的手段主要有以下三种:

- 使用自定义标识停止线程。

- 使用 interrupt() 方法停止线程。

- 使用 stop() 方法停止线程。

# wait() 方法和 sleep() 方法有什么区别?

wait() 方法和 sleep() 方法都是用于暂停线程执行的,但它们有以下几个主要区别:

所属类不同:

- wait() 方法是 java.lang.Object 类的一个方法,所有对象都可以调用。

- sleep() 方法是 java.lang.Thread 类的一个静态方法,直接作用于线程。

锁操作不同:

- wait() 方法必须在 synchronized 代码块或方法中调用,因为它会释放当前线程持有的对象监视器(锁),使得其他等待该锁的线程有机会继续执行。

- sleep() 方法不需要获取任何锁,它只是使当前线程休眠指定的时间,不会释放任何锁。

唤醒方式不同:

- wait() 方法的执行通常与 notify() 或 notifyAll() 方法配合使用。当一个线程调用 wait() 方法后,它将进入等待状态,直到被其他线程通过调用 notify() 或 notifyAll() 方法唤醒。

- sleep() 方法在指定的休眠时间结束后会自动唤醒线程,无需其他线程的干预。

使用场景不同:

- wait() 方法主要用于线程间的协作和通信,例如在生产者-消费者模式、条件队列等场景中。

- sleep() 方法通常用于简单的延时操作或者防止线程过于频繁地执行某些操作的场景。

总体来说,wait() 方法主要用于线程间的同步和协作,而 sleep() 方法主要用于控制线程的执行延迟。

# 线程池相比于线程有什么优点?

线程池是一种管理和复用线程的机制,它预先创建了一组线程,并维护一个任务队列,当任务来的时候,会从线程池中选择线程去执行任务,而不是直接创建线程去执行。

线程池的主要目的是提高多线程应用程序的性能,通过避免线程频繁创建和销毁带来的性能开销,提高了资源利用率、响应速度和系统的稳定性。

线程池是一种管理和复用线程的机制,它相比于线程来说主要具备以下优点:

- 线程重用(降低资源消耗):线程池可以重复利用已经创建的线程,避免了频繁创建和销毁线程的开销。通过线程池,可以有效地管理和控制线程的数量,避免线程过多导致资源消耗过大。

- 提高响应速度:线程池中的线程是预先创建好的,当有任务到达时,可以立即分配线程来处理任务,提高了任务的响应速度。相比于每次都创建新线程的方式,线程池可以减少线程创建的时间开销。

- 提供更强大的功能:线程池具备可拓展性,允许开发人员向其中增加更多的功能。例如线程池中的任务队列,使用任务队列可以存储更多的待执行任务,还有延时定时线程池 ScheduledThreadPoolExecutor 允许任务延期执行或定期以某种频率执行。

- 提高系统稳定性:线程池可以限制并发线程的数量,避免系统因为线程过多而导致资源耗尽或系统崩溃。通过合理配置线程池的参数,可以控制系统的负载,提高系统的稳定性。

# 说下线程池创建参数都有哪些?它们都有哪些含义?

线程池 ThreadPoolExecutor 最多支持 7 个参数的设置,如下代码所示:

public ThreadPoolExecutor(int corePoolSize, int maximumPoolSize, long keepAliveTime, TimeUnit unit, BlockingQueue<Runnable> workQueue, ThreadFactory threadFactory, RejectedExecutionHandler handler) { if (corePoolSize < 0 || // maximumPoolSize 必须大于 0,且必须大于 corePoolSize maximumPoolSize <= 0 || maximumPoolSize < corePoolSize || keepAliveTime < 0) throw new IllegalArgumentException(); if (workQueue == null || threadFactory == null || handler == null) throw new NullPointerException(); this.acc = System.getSecurityManager() == null ? null : AccessController.getContext(); this.corePoolSize = corePoolSize; this.maximumPoolSize = maximumPoolSize; this.workQueue = workQueue; this.keepAliveTime = unit.toNanos(keepAliveTime); this.threadFactory = threadFactory; this.handler = handler; }这 7 个参数的含义如下:

- corePoolSize:核心线程数,表示线程池的常驻核心线程数。如果设置为 0,则表示在没有任何任务时,销毁线程池;如果大于 0,即使没有任务时也会保证线程池的线程数量等于此值。但需要注意,此值如果设置的比较小,则会频繁的创建和销毁线程(创建和销毁的原因会在本课时的下半部分讲到);如果设置的比较大,则会浪费系统资源,所以开发者需要根据自己的实际业务来调整此值。

- maximumPoolSize:最大线程数,表示线程池在任务最多时,最大可以创建的线程数。官方规定此值必须大于 0,也必须大于等于 corePoolSize,此值只有在任务比较多,且不能存放在任务队列时,才会用到。

- keepAliveTime:表示临时线程的存活时间(最大线程数-核心线程数)。当线程池空闲时并且超过了此时间,多余的线程就会销毁,直到线程池中的线程数量销毁的等于 corePoolSize 为止,如果 maximumPoolSize 等于 corePoolSize,那么线程池在空闲的时候也不会销毁任何线程。

- unit:表示临时线程的存活时间单位。它是配合 keepAliveTime 参数三共同使用的。

- workQueue:表示线程池执行的任务队列,当线程池的所有线程都在处理任务时,如果来了新任务就会缓存到此任务队列中排队等待执行。

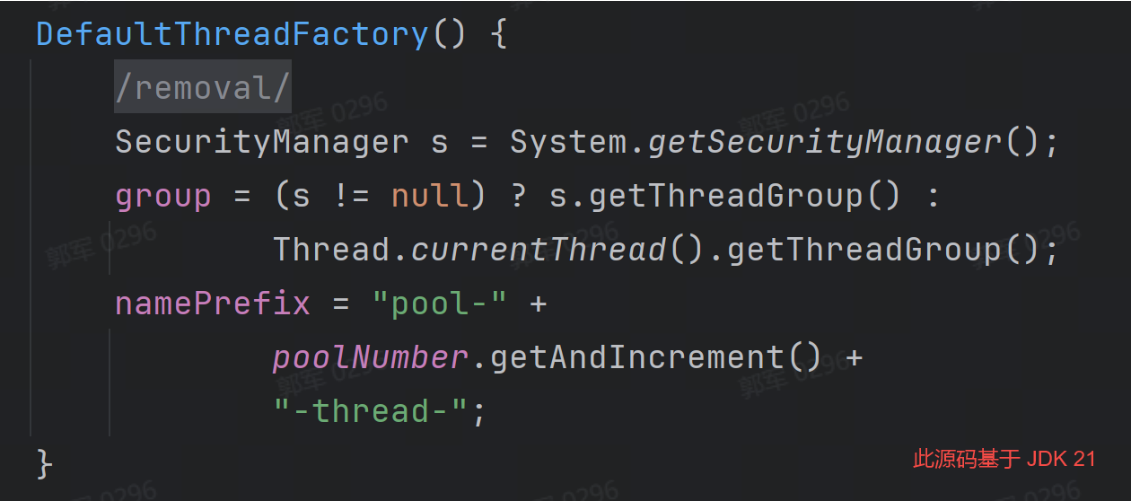

- threadFactory:表示线程的创建工厂,此参数一般用的比较少,我们通常在创建线程池时不指定此参数,它会使用默认的线程创建工厂的方法来创建线程。

- RejectedExecutionHandler:表示指定线程池的拒绝策略,当线程池的任务已经在缓存队列 workQueue 中存储满了之后,并且不能创建新的线程来执行此任务时,就会用到此拒绝策略,它属于一种限流保护的机制。

# 线程工厂有什么用?不设置线程工厂会怎样?

线程池中的线程工厂可以设置线程池的名称格式、线程的优先级、线程分组、以及线程类型(用户线程或守护线程)等信息,如下代码所示:不设置线程工厂会怎样? 当线程池中不设置线程工厂时,会使用默认的线程工厂,具体源码如下:public static void main(String[] args) { // 创建一个线程组 ThreadGroup threadGroup = new ThreadGroup("MyThreadGroup"); // 创建线程工厂 ThreadFactory threadFactory = new ThreadFactory() { @Override public Thread newThread(Runnable r) { // 创建线程池中的线程(设置线程组和任务) Thread thread = new Thread(threadGroup, r); // 设置线程名称 thread.setName("Thread-" + r.hashCode()); // 设置线程优先级(最大值:10) thread.setPriority(Thread.MAX_PRIORITY); //... return thread; } }; // 创建线程池 ThreadPoolExecutor threadPoolExecutor = new ThreadPoolExecutor(10, 10, 0, TimeUnit.SECONDS, new LinkedBlockingQueue<>(), threadFactory); // 使用自定义的线程工厂 threadPoolExecutor.submit(new Runnable() { @Override public void run() { Thread thread = Thread.currentThread(); System.out.println(String.format("线程:%s,线程优先级:%d", thread.getName(), thread.getPriority())); } }); }

# 线程的优先级有什么用?如何设置线程池的优先级?

线程的优先级用整数表示,范围从 1 到 10,数字越大表示优先级也越高,线程的默认优先级为 5。

需要注意的是,线程的优先级越高,表示它在竞争 CPU 资源时更有可能被调度执行。然而,线程优先级的具体行为在不同的操作系统和 Java 虚拟机实现中可能会有所不同。所以,线程优先级仅仅是给操作系统一个提示,告诉它应该优先调度哪个线程,但操作系统可能不会严格按照优先级来调度线程。

Java 中,线程的优先级由 Thread 类的 setPriority() 和 getPriority() 方法来设置和获取线程的优先级。

# 说一下线程池的执行流程?

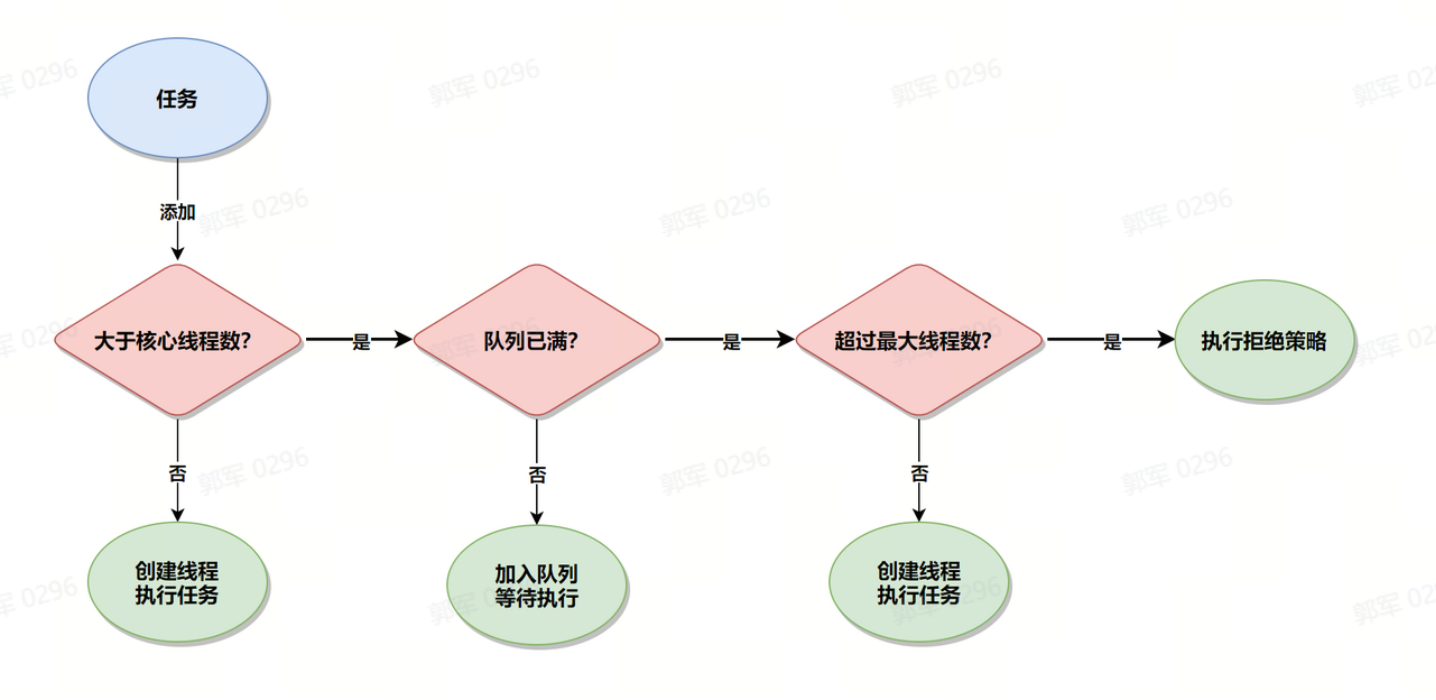

当有任务来了之后,线程池的执行流程是这样的:

- 先判断当前线程数是否大于核心线程数,如果结果为 false,则新建线程并执行任务。

- 如果大于核心线程数,则判断任务队列是否已满?如果结果为 false,则把任务添加到任务队列中等待线程执行。

- 如果任务队列已满,则判断当前线程数量是否超过最大线程数?如果结果为 false,则新建线程执行此任务。

- 如果超过最大线程数,则将执行线程池的拒绝策略。

# 说一下线程池的拒绝策略有哪些?实际工作中会使用哪种拒绝策略?为什么?

JDK 自带了四种拒绝策略加上一种自定义拒绝策略,所以总共有五种拒绝策略,这些拒绝策略分别是:

- AbortPolicy(默认):抛出一个 RejectedExecutionException 异常,阻止任务的提交。

- CallerRunsPolicy:使用调用线程来执行该任务。意味着将任务返回给任务提交者进行执行,而不是在线程池中处理。

- DiscardPolicy:默默地丢弃无法接受的任务,不提供任何错误日志或其他通知。

- DiscardOldestPolicy:丢弃队列中最旧的任务,然后尝试重新提交被拒绝的任务。通过这种方式,可以让新提交的任务有机会得到执行。

- 自定义拒绝策略通过 new RejectedExecutionHandler 实现,并重写 rejectedExecution 方法来实现

实际开发中会使用哪种拒绝策略?为什么?

实际开发中会使用自定义拒绝策略,因为自定义拒绝策略灵活好控制,可以在自定义拒绝策略中发送一条通知给消息中心,让消息中心发送告警信息给开发者,这样就能实时监控线程池的运行状况,并能及时发现和排查问题了。

# 如何判断线程池中的任务是否执行完成?

判断线程池中的任务是否执行完成的方法主要有以下两个:

- 使用 getCompletedTaskCount() 统计已经执行完的任务,和 getTaskCount() 线程池的总任务进行对比,如果相等则说明线程池的任务执行完了,否则既未执行完。

- 使用 FutureTask 等待所有任务执行完,线程池的任务就执行完了。

# 导致线程安全问题的因素有哪些?

线程安全问题指的是在多线程环境下,多个线程同时操作共享资源时,导致程序执行结果与预期不符的问题。

线程安全问题可能导致数据的不一致、程序崩溃、死锁等问题。

导致线程安全问题的因素主要有以下几点:

- 多线程同时执行:多个线程同时执行是造车并发问题的根本原因。

- 操作共享数据:当多个线程访问和修改同一块共享数据时,可能会导致数据覆盖,数据可见性等问题。

- 非原子操作:某些操作虽然看起来是单个语句,但在计算机内部可能被分解为多个步骤。如果这些操作在多线程环境中没有得到适当同步,就可能导致线程安全问题。

- 指令重排序:编译器和处理器为了优化性能,可能会对代码进行重新排序。这种重排序在单线程环境下通常是安全的,但在多线程环境下可能会导致意料之外的结果。

- 内存可见性问题:在多线程环境中,一个线程对共享变量的修改可能不会立即对其他线程可见。这是因为每个线程都有自己的本地缓存,而且编译器和处理器可能会进行各种优化。

# 解决线程安全问题的手段有哪些?

解决线程安全问题主要是通过加锁(让多线程执行变成多线程排队执行,每个时刻只有一个线程在执行)或每个线程操作自己的私有变量,这样也不会存在线程安全问题,因为大家各改各的,互不影响。

总结来说,在 Java 中解决线程安全问题的主要手段有以下 3 种:

- 通过锁机制处理:多线程排队执行,每个时刻只有一个线程在执行,如 Lock 或 synchronized。

- 使用线程安全的容器:如 ConcurrentHashMap、CopyOnWriteArrayList 等。

- 使用 ThreadLocal:线程局部变量,每个线程操作自己的变量,也不会导致线程安全问题。

PS:使用线程安全的容器底层还是通过锁机制来保证线程安全的。

# synchronized 底层是如何实现的?

synchronized 是通过 JVM 内置的 Monitor 监视器实现的,而监视器又是依赖操作系统的互斥锁 Mutex 实现的。

当我们给程序加了 synchronized 之后,那么在编译成字节码时,就会给相应的代码块添加 monitor.

# 说一下 synchronized 锁升级的流程?

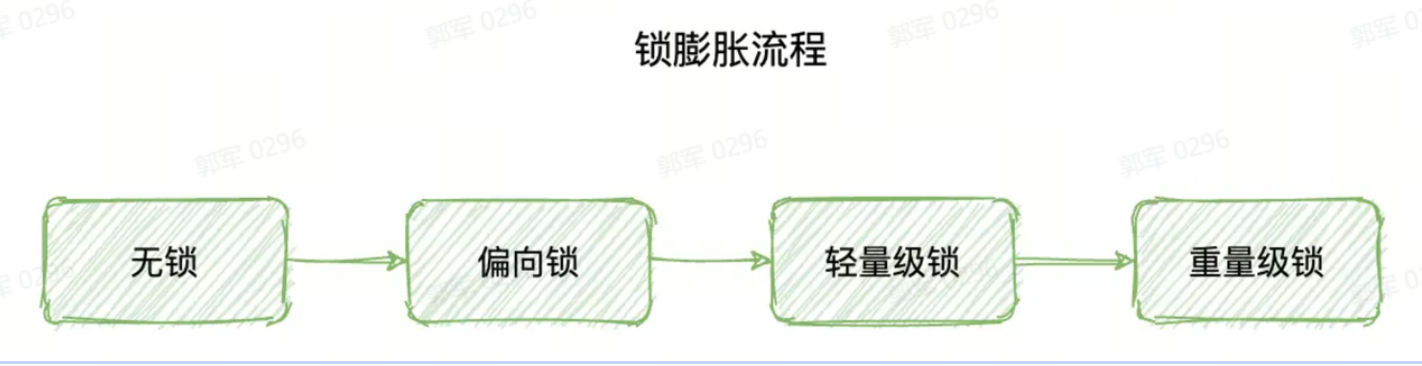

synchronized 锁升级的流程如下:

- 无锁

- 偏向锁

- 轻量级锁

- 重量级锁

synchronized 会按照上述先后顺序依次升级,我们把这个升级的过程称之为“锁膨胀”。

synchronized 锁升级的流程如下:

- 刚开始程序先是无锁状态,没有线程使用。

- 当一个线程访问同步代码块并获取锁时,会在对象头的 Mark Word 里存储锁偏向的线程 ID,此时就是偏向锁。

- 如果 Mark Word 中的线程 ID 和访问的线程 ID 一致,则可以直接进入同步块进行代码执行,如果线程 ID 不同,则使用 CAS 尝试获取锁,如果获取成功则进入同步块执行代码,否则会将锁的状态升级为轻量级锁。

- 轻量级锁之后会通过自旋来获取锁,自旋执行一定次数之后还未成功获取到锁,此时就会升级为重量级锁,并且进入阻塞状态。

# synchronized 是固定自旋次数吗?

synchronized 是自适应自旋锁,不是固定自旋次数。

自适应自旋锁是指,线程自旋的次数不再是固定的值,而是一个动态改变的值。这个值会根据前一次自旋获取锁的状态来决定此次自旋的次数。

例如,上一次通过自旋成功获取到了锁,那么这次通过自旋也有可能会获取到锁,所以这次自旋的次数就会增多一些,而如果上一次通过自旋没有成功获取到锁,那么这次自旋可能也获取不到锁,所以为了避免资源的浪费,就会少循环或者不循环,以提高程序的执行效率。简单来说,如果线程自旋成功了,则下次自旋的次数会增多,如果失败,下次自旋的次数会减少。

# synchronized 和 ReentrantLock 有什么区别?

synchronized 和 ReentrantLock 都提供了锁的功能,都是 Java 中保证线程安全的主要手段,但它们有很大的区别。

- synchronized 属于独占式悲观锁,是通过 JVM 隐式实现的,synchronized 只允许同一时刻只有一个线程操作资源。

- ReentrantLock 是 Lock 的默认实现方式之一,它是基于 AQS(Abstract Queued Synchronizer,队列同步器)实现的,它默认是通过非公平锁实现的,在它的内部有一个 state 的状态字段用于表示锁是否被占用,如果是 0 则表示锁未被占用,此时线程就可以把 state 改为 1,并成功获得锁,而其他未获得锁的线程只能去排队等待获取锁资源。

在 JDK 1.5 中 synchronized 的性能远远低于 ReentrantLock,但在 JDK 1.6 之后 synchronized 的性能和 ReentrantLock 的性能差别不大。

主要区别详情

- ReentrantLock 只能修饰代码块,而 synchronized 可以用于修饰方法、修饰代码块等。

- ReentrantLock 需要手动加锁和释放锁,如果忘记释放锁,则会造成资源被永久占用,而 synchronized 无需手动释放锁。

- ReentrantLock 使用时更加灵活,比如 ReentrantLock 可以知道是否成功获得了锁,而 synchronized 却不行。

- ReentrantLock 可设置为公平锁,而 synchronized 却不行。

- 二者的底层实现不同,synchronized 是 JVM 层面通过监视器(Monitor)实现的,而 ReentrantLock 是通过 AQS(AbstractQueuedSynchronizer)程序级别的 API 实现。

# volatile 能保证线程安全吗?为什么?

volatile 不能保证线程执行安全,volatile 主要作用有两个:保证内存的可见性和禁止指令重排序。

也就说使用 volatile 可以保证多个线程在操作同一个变量时,始终可以读取到最新的数据;并且使用 volatile 可以禁止指令重排序,从而关闭掉系统优化所给程序代码执行结果不一致的风险。

但是 volatile 不能保证原子性,而原子性也是导致线程不安全的因素之一,所以 volatile 不能保证线程安全。

# volatile 在实际工作中,有那些使用场景?

volatile 在实际工作中,常用的场景有以下几个:

- 单例模式(双重检查锁定,Double-checked locking):在单例模式等场景下,volatile 可以配合使用双重检查锁定来确保只有一个实例被创建。在获取实例时,通过对实例对象进行 volatile 检查,确保其他线程能够正确读取已创建的实例,如下代码所示:

public class Singleton { private Singleton() {} private static volatile Singleton instance = null; public static Singleton getInstance() { if (instance == null) { // ① synchronized (Singleton.class) { if (instance == null) { instance = new Singleton(); // ② } } } return instance; } }- 定时任务控制标志:在一些定时任务中,可能需要用到标志位来控制任务的启停。通过将标志位声明为 volatile,确保在修改标志位时能够立即对其他线程可见,并及时停止或启动相关任务。例如以下代码:如下代码所示:

public class MyThread extends Thread { private volatile boolean flag = true; public void stopThread() { flag = false; } @Override public void run() { while (flag) { // 线程执行的代码 } } }如果不加的话,那么编译器可能将上面的代码优化为以下代码:

public class MyThread extends Thread { private boolean flag = true; public void stopThread() { flag = false; } @Override public void run() { while (false) { // 线程执行的代码 } } }那么,定时任务就失控了,永远停不下来了。

- 线程间消息通知:当一个线程需要向另一个线程发送通知时,可以使用 volatile 作为信号量。当一个线程修改了 volatile 变量的值时,其他线程能够立即看到该变化,从而得知有新的消息到达。

# 什么是乐观锁?乐观锁底层是如何实现的?

乐观锁认为并发访问不会导致冲突,因此在读取数据时不立即加锁,而是在更新数据时检查自上次读取以来数据是否已经被其他人修改过。

乐观锁底层是通过 CAS(Compare And Swap,比较并替换)机制实现的,CAS 机制包含三个组件:内存地址 V、预期值 A 和新值 B。

CAS 的操作过程如下:

- 比较内存地址 V 中的值与预期值 A 是否相等。

- 如果相等,将内存地址 V 的值修改为新值 B。

- 如果不相等,表示预期值 A 与实际值不匹配,操作失败。

CAS 的操作是原子性的,即整个操作过程是不可中断的,要么成功执行并修改值,要么不执行修改。如果由于竞争或并发导致操作失败(预期值不匹配),则可以通过循环重新尝试操作,直到成功或达到最大尝试次数操作失败。

# 什么是ABA问题?如何解决ABA问题?

ABA 问题是在使用 CAS 时可能出现的一种并发问题。在多线程环境下,如果一个变量的值先被线程 A 修改为 B,然后又被线程 B 修改回 A,那么在使用 CAS 进行比较和交换操作时,尽管变量的当前值与预期值相同(都是 A),但实际上这个变量的值已经被修改过,这就是 ABA 问题。

解决 ABA 问题的常见方案是加版本号,通过版本号 + 旧值共同来决定变量是否有变动。

# ReentrantLock底层是如何实现的?

ReentrantLock(可重入锁)是 Java 并发包 java.util.concurrent.locks 中提供的一个互斥同步器,其底层实现基于 AbstractQueuedSynchronizer(AQS)框架。AQS 是一个实现了阻塞式锁和相关同步器(信号量、事件等)的框架,提供了基于 FIFO 等待队列的线程调度机制。

ReentrantLock 底层实现和主要特性:

状态变量(state):ReentrantLock 内部维护了一个 volatile int 类 型的成员变量 state,用来表示锁的持有者数量以及当前锁的状态(是否被锁定)。当 state 为 0 时代表锁未被任何线程持有;大于 0 则表示被某个线程持有,并且 state 值也代表了重入次数。

公平与非公平锁:ReentrantLock 通过两个内部类 FairSync 和 NonfairSync 来分别实现公平锁和非公平锁。公平锁在获取锁时会遵循 FIFO 原则,而非公平锁则允许“插队”,即不管线程等待队列顺序,有机会就尝试获取锁。

获取锁过程:

- lock() 方法首先会尝试 CAS 操作(compareAndSetState())去获取锁,如果当前没有其他线程持有锁或者锁已经被当前线程持有,则增加 state 计数并成功获得锁。

- 当 CAS 操作失败时,表明有其他线程持有锁或锁正被竞争。此时,当前线程会被封装成一个节点(Node)加入到 AQS 的等待队列中。如果是公平锁,新节点会排在队尾;如果是非公平锁,则可能尝试直接获取锁或插入队列头部。

解锁过程:unlock() 方法会递减 state 计数,当 state 减少至 0 时,表明所有锁都被释放,此时如果有等待线程,则唤醒等待队列中的第一个节点的线程继续尝试获取锁。

可重入性:可重入体现在同一个线程可以对已经持有的锁再次调用 lock() 方法而不被阻塞,此时只是简单地增加 state 计数,而不是将自己放入等待队列。

超时获取锁:ReentrantLock 还提供了带超时限制的 tryLock(long timeout, TimeUnit unit) 方法,它会在指定时间内尝试获取锁,若无法获取则返回 false,避免线程无休止地等待。

ReentrantLock 通过 AQS 提供的底层支持,结合 CAS 原子操作、自旋、线程挂起和恢复等技术手段,高效地实现了可重入、公平/非公平、可中断等复杂功能的锁机制。

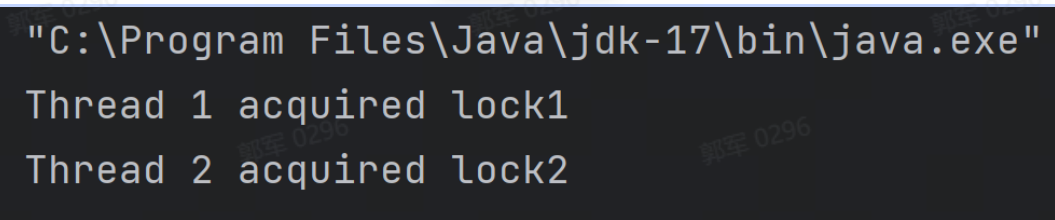

# 手写一个死锁代码?产生死锁的因素有哪些?

以下是实现死锁的代码:

public class DeadlockDemo { private static Object lock1 = new Object(); private static Object lock2 = new Object(); public static void main(String[] args) { Thread thread1 = new Thread(() -> { synchronized (lock1) { System.out.println("Thread 1 acquired lock1"); try { Thread.sleep(1000); } catch (InterruptedException e) { e.printStackTrace(); } synchronized (lock2) { System.out.println("Thread 1 acquired lock2"); } } }); Thread thread2 = new Thread(() -> { synchronized (lock2) { System.out.println("Thread 2 acquired lock2"); try { Thread.sleep(1000); } catch (InterruptedException e) { e.printStackTrace(); } synchronized (lock1) { System.out.println("Thread 2 acquired lock1"); } } }); thread1.start(); thread2.start(); } }

产生死锁的条件有以下 4 个:

- 互斥条件:指运算单元(进程、线程或协程)对所分配到的资源具有排它性,也就是说在一段时间内某个锁资源只能被一个运算单元所占用。

- 请求和保持条件:指运算单元已经保持至少一个资源,但又提出了新的资源请求,而该资源已被其它运算单元占有,此时请求运算单元阻塞,但又对自己已获得的其它资源保持不放。

- 不可剥夺条件:指运算单元已获得的资源,在未使用完之前,不能被剥夺。

- 环路等待条件:指在发生死锁时,必然存在运算单元和资源的环形链,即运算单元正在等待另一个运算单元占用的资源,而对方又在等待自己占用的资源,从而造成环路等待的情况。

# 如何排查死锁? 如何解决死锁?

- jstack:可以查看 Java 应用程序的线程状态和调用堆栈,可用于发现死锁线程的状态。

- jconsole 和 JVisualVM:这些是 Java 自带的监视工具,可以用于监视线程、内存、CPU 使用率等信息,从而帮助排查死锁问题。

- Thread Dump Analyzer(TDA):是一个开源的线程转储分析器,可用于分析和诊断 Java 应用程序中的死锁问题。

- Eclipse TPTP:是一个开源的性能测试工具平台,其中包含了一个名为 Thread Profiler 的工具,可以用于跟踪线程运行时的信息,从而诊断死锁问题。

如何解决死锁?

我们可以通过顺序锁或轮询锁来解决死锁的问题。

- 顺序锁: 所谓的顺序锁指的是通过有顺序的获取锁,从而避免产生环路等待条件,从而解决死锁问题的。

- 轮询锁: 是通过打破“请求和保持条件”来避免造成死锁的,它的实现思路简单来说就是通过轮询来尝试获取锁,如果有一个锁获取失败,则释放当前线程拥有的所有锁,等待下一轮再尝试获取锁。

# Java 中乐观锁的实现类有哪些?悲观锁的实现类有哪些?

Java 乐观锁的实现有以下几个:

- java.util.concurrent.atomic 包下的原子类如 AtomicInteger、AtomicLong、AtomicReference 等。

- ReentrantLock 其底层是使用 AQS 中的乐观锁 CAS 实现的,但其本身(的业务属性)为悲观锁(底层实现依靠的是乐观锁 CAS)。

Java 悲观锁的实现有以下几个:

- synchronized:使用 synchronized 关键字可以将代码块或方法进行同步,保证在同一时间只有一个线程可以访问。它是内置的关键字,可以用于实现对对象的悲观锁。

- ReentrantLock:ReentrantLock 是 JDK 提供的一个可重入锁的实现,通过它可以实现对临界区的加锁和解锁操作。它提供了更多的灵活性和功能,例如可设置超时、可中断、公平性等特性。它的底层是通过乐观锁 CAS 实现的,但其本身为悲观锁。

- ReadWriteLock:ReadWriteLock 是 JDK 提供的读写锁的实现,通过它可以在读多写少的情况下提供更高的并发性。它允许多个线程同时读取数据,但只允许一个线程进行写入。

# Java 中除了乐观锁和悲观锁外还有哪些锁?

除了乐观锁和悲观锁之外,其他的常用锁策略还有以下几个:

- 公平锁:公平锁是指多个线程按照申请锁的顺序来获取锁。

- 非公平锁:非公平锁是指多个线程获取锁的顺序并不是按照申请锁的顺序,有可能后申请的线程比先申请的线程优先获取锁。

- 独占锁:独占锁是指任何时候都只有一个线程能执行资源操作。

- 共享锁:共享锁指定是可以同时被多个线程读取,但只能被一个线程修改。比如 Java 中的 ReentrantReadWriteLock 就是共享锁的实现方式,它允许一个线程进行写操作,允许多个线程读操作。

- 可重入锁:可重入锁指的是该线程获取了该锁之后,可以无限次的进入该锁锁住的代码。

- 自旋锁:自旋锁是指尝试获取锁的线程不会立即阻塞,而是采用循环的方式去尝试获取锁,这样的好处是减少线程上下文切换的消耗,缺点是循环会消耗 CPU。

Java 中的所有锁默认都是非公平锁,因为非公平锁的效率高,但有很小的几率非公平锁会产生线程饥饿的问题,指的是某个线程竞争了很多次、等待了很长时间但依然没有获得锁资源。

我们可以使用 ReentrantLock 来创建公平锁,实现代码为“ReentrantLock lock = new ReentrantLock(true);”其中参数 true 表示创建公平锁,默认值为 false 非公平锁。

# AtomicInteger 是线程安全的吗?它属于哪种锁类型?它存在 ABA 问题吗?如何解决这些问题?

AtomicInteger 底层是通过 CAS 乐观锁实现的,所以它也属于乐观锁实现的线程安全的容器。

AtomicInteger 存在 ABA 的问题,想要解决此问题,可以使用它的兄弟类 AtomicStampedReference 类来实现,AtomicStampedReference 类通过设置版本号和累计版本号的方式解决了 ABA 问题,它的使用代码如下:

import java.util.concurrent.atomic.AtomicStampedReference; public class AtomicStampedReferenceExample { public static void main(String[] args) { // 创建一个初始值为100,初始版本号为0的AtomicStampedReference对象 AtomicStampedReference<Integer> atomicStampedRef = new AtomicStampedReference<>(100, 0); // 获取当前值和版本号 int currentValue = atomicStampedRef.getReference(); int currentStamp = atomicStampedRef.getStamp(); System.out.println("当前值:" + currentValue + ",当前版本号:" + currentStamp); // 尝试将值从100更新为200,版本号加1 int newStamp = currentStamp + 1; boolean success = atomicStampedRef.compareAndSet(currentValue, 200, currentStamp, newStamp); System.out.println("更新结果:" + success); // 获取更新后的值和版本号 int updatedValue = atomicStampedRef.getReference(); int updatedStamp = atomicStampedRef.getStamp(); System.out.println("更新后的值:" + updatedValue + ",更新后的版本号:" + updatedStamp); }# 什么是Semaphore?它有什么用?它的底层是如何实现的?

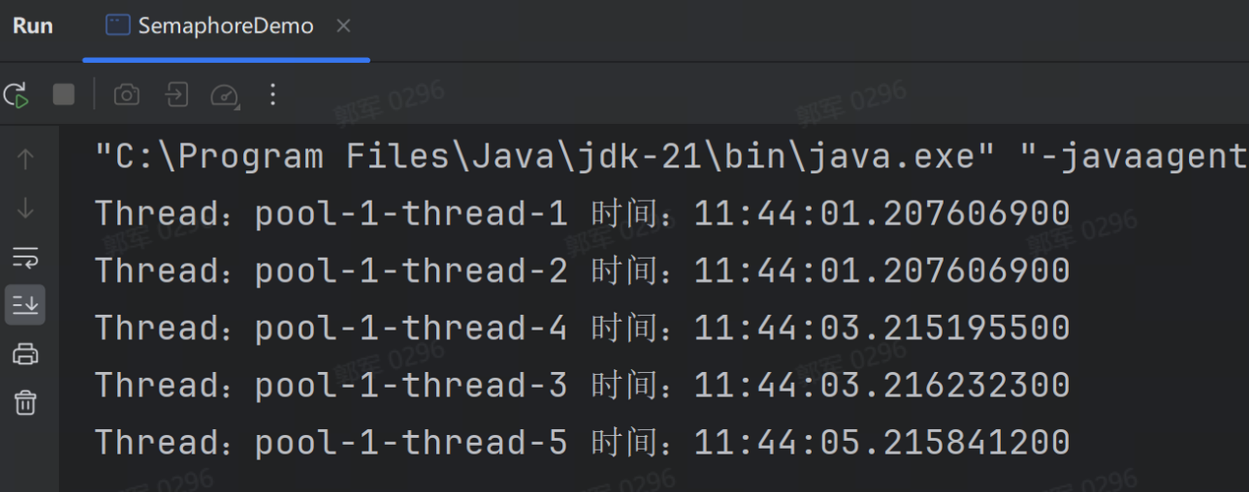

Semaphore(信号量)是一种同步工具,可以用来限制并发访问的数量,或者作为一种许可机制来管理资源的使用。

Semaphore 就好比停车场的门卫,可以控制车位的使用资源。比如来了 5 辆车,只有 2 个车位,门卫可以先放两辆车进去,等有车出来之后,再让后面的车进入,它的实现代码如下

import java.time.LocalTime; import java.util.concurrent.Semaphore; import java.util.concurrent.ThreadPoolExecutor; import java.util.concurrent.TimeUnit; import java.util.concurrent.LinkedBlockingQueue; public class SemaphoreDemo { public static void main(String[] args) { // 同时只允许两个线程访问 Semaphore semaphore = new Semaphore(2); ThreadPoolExecutor semaphoreThread = new ThreadPoolExecutor(10, 50, 60, TimeUnit.SECONDS, new LinkedBlockingQueue<>()); for (int i = 0; i < 5; i++) { semaphoreThread.execute(() -> { try { // 堵塞获取许可 semaphore.acquire(); System.out.println("Thread:" + Thread.currentThread().getName() + " 时间:" + LocalTime.now()); TimeUnit.SECONDS.sleep(2); // 释放许可 semaphore.release(); } catch (InterruptedException e) { e.printStackTrace(); } }); } } }

执行流程如下图:

Semaphore 底层实现主要依赖于 AQS(AbstractQueuedSynchronizer)框架,它使用一个同步队列来管理等待许可的线程。Semaphore 内部维护了一个计数器,记录着可用的许可数量。每次线程调用 acquire() 方法时,Semaphore 会将计数器减一,如果计数器小于等于 0,则线程会被加入到同步队列中阻塞等待。当线程调用 release() 方法释放许可时,Semaphore 会将计数器加一,并唤醒一个等待的线程。

# CountDownLatch 和 CyclicBarrier 有什么区别?

CountDownLatch 和 CyclicBarrier 都是 JUC(java.util.concurrent)下的包,但它们的使用场景略有不同。

CountDownLatch 侧重于单向等待执行(只能使用一次),用于一个或多个线程等待其他线程完成之后再进行后续操作,而 CyclicBarrier 则更适用于多线程之间的协作和同步,可以重复使用多次。

①. CountDownLatch

CountDownLatch(闭锁)可以看作一个只能做减法的计数器,可以让一个或多个线程等待执行。

CountDownLatch 有两个重要的方法:

countDown():使计数器减 1;

await():当计数器不为 0 时,则调用该方法的线程阻塞,当计数器为 0 时,可以唤醒等待的一个或者全部线程。

CountDownLatch 使用场景:

以生活中的情景为例,比如去医院体检,通常人们会提前去医院排队,但只有等到医生开始上班,才能正式开始体检,医生也要给所有人体检完才能下班,这种情况就要使用 CountDownLatch,流程为:患者排队 → 医生上班 → 体检完成 → 医生下班。

CountDownLatch 使用代码如下:

public static void main(String[] args) throws InterruptedException { // 创建 CountDownLatch CountDownLatch countDownLatch = new CountDownLatch(2); // 创建固定线程数的线程池 ExecutorService executorService = Executors.newFixedThreadPool(2); // 任务一 executorService.submit(new Runnable() { @Override public void run() { // do something try { // 让此任务执行 1.2s Thread.sleep(1200); } catch (InterruptedException e) { e.printStackTrace(); } System.out.println("我是任务一"); countDownLatch.countDown(); } }); // 任务二 executorService.submit(new Runnable() { @Override public void run() { // do something try { // 让此任务执行 1.2s Thread.sleep(1000); } catch (InterruptedException e) { e.printStackTrace(); } System.out.println("我是任务二"); countDownLatch.countDown(); } }); // 等待任务执行完成 countDownLatch.await(); System.out.println("程序执行完成~"); }②. CyclicBarrier

CyclicBarrier(循环屏障)通过它可以实现让一组线程等待满足某个条件后同时执行。 CyclicBarrier 经典使用场景是公交发车,为了简化理解我们这里定义,每辆公交车只要上满 4 个人就发车,后面来的人都会排队依次遵循相应的标准。 CyclicBarrier 使用代码如下:

import java.util.Date; import java.util.Random; import java.util.concurrent.*; public class CyclicBarrierExample { public static void main(String[] args) { // 创建 CyclicBarrier final CyclicBarrier cyclicBarrier = new CyclicBarrier(2, new Runnable() { @Override public void run() { System.out.println("人满了,准备发车:" + new Date()); } }); // 线程调用的任务 Runnable runnable = new Runnable() { @Override public void run() { // 生成随机数 1-3 int randomNumber = new Random().nextInt(3) + 1; // 进入任务 System.out.println(String.format("我是:%s 再走:%d 秒就到车站了,现在时间:%s", Thread.currentThread().getName(), randomNumber, new Date())); try { // 模拟执行 TimeUnit.SECONDS.sleep(randomNumber); // 调用 CyclicBarrier cyclicBarrier.await(); // 任务执行 System.out.println(String.format("线程:%s 上车,时间:%s", Thread.currentThread().getName(), new Date())); } catch (InterruptedException e) { e.printStackTrace(); } catch (BrokenBarrierException e) { e.printStackTrace(); } } }; // 创建线程池 ExecutorService threadPool = Executors.newFixedThreadPool(10); // 执行任务 1 threadPool.submit(runnable); // 执行任务 2 threadPool.submit(runnable); // 执行任务 3 threadPool.submit(runnable); // 执行任务 4 threadPool.submit(runnable); // 等待所有任务执行完终止线程池 threadPool.shutdown(); } }CountDownLatch 和 CyclicBarrier 内部都是使用计时器实现的,但 CountDownLatch 的计数器只能使用一次,而 CyclicBarrier 的计数器可以循环使用,这就是二者最大的区别。

# 四.MySql模块

# 用自己的话说一下什么是三范式?为什么要遵循三范式?实际开发中一定要严格遵循三范式吗?为什么?

数据库三范式的具体内容如下:

第一范式(1NF:First Normal Form):第一范式规定表中的每个列都应该是不可分割的最小单元。

- 含义说明:也就说,一个属性不能包含多个值,例如,不能将地址中的省、市、区存储在一个字段中,而是要分成多个字段分别进行存储。

第二范式(2NF:Second Normal Form):在满足第一范式的基础上,第二范式要求数据库表中的每个非主键列都必须完全依赖于整个主键,而不能只依赖于主键的一部分。

- 含义说明:这意味着如果一个表有两个或更多的独立字段组成联合主键,那么其他非主键列的值必须与整个主键相关,而不能只与联合主键的一部分相关。

第三范式(3NF:Third Normal Form):在满足第二范式的基础上,第三范式进一步要求数据库表中的每个非主键列都必须直接依赖于主键,而不能依赖于其他非主键列。

- 含义说明:这样可以消除传递依赖,避免数据冗余和更新异常。

用自己的话说一下什么是三范式?

- 第一范式是将列分割成最小单元。

- 第二范式是每个字段都必须和所有主键完全相关。

- 第三范式是每个字段不能和主键间接相关。

为什么要遵循三范式?

遵循数据库三范式是主要用于减少数据冗余和方便后续的维护和更新。

实际开发中一定要严格遵循三范式吗?为什么?

实际开发中,并不会严格遵循三范式,因为在实际工作中除了要考虑设计规范三范式之外,还要考虑查询的性能。

例如,某些场景如果要严格遵循三范式,那么可能需要将多个字段存储到多张表中进行查询,而多张表的联查效率是非常低的,这样情况下为了满足性能的需求,我们通常会涉及成冗余字段存放到更少的表中,以减少联表查询的性能开销,这就是使用空间换时间的做法。

# 关系型数据库和非关系数据库有什么区别?它们对应的使用场景分别有哪些?

关系型数据库介绍

关系型数据库(RDBMS)是基于关系模型的数据库,使用表格结构来组织和存储数据,数据是以行和列的形式存储,并且可以通过定义主键和外键来建立表之间的关系。

关系型数据库的特点主要有以下几个:

- 统一数据结构:数据以表格的形式存储,表格由行和列组成,每个列都有对应的数据类型,提供了规范和结构化的数据存储方式。

- 强一致性:关系型数据库遵循 ACID(原子性、一致性、隔离性、持久性)原则,保证数据的一致性和事务的完整性。

- 数据完整性:关系型数据库支持定义表之间的关联关系,通过主键和外键进行数据的完整性约束。

- 丰富的查询功能:通过 SQL 查询语言,可以进行复杂的关系查询和连接操作,支持多表查询、条件查询、聚合查询等。

关系型数据库的典型代表有:OracleDB、MySQL、SQL Server(Microsoft)、PostgreSQL、DB2(IBM)等。

非关系型数据库介绍

非关系型数据库,或称为 NoSQL(Not Only SQL)数据库,是一种不同于传统关系型数据库的数据库系统。它们不依赖于表格和关系模型,而是采用各种不同的数据模型(如键值对、文档、列族、图等)来存储和管理数据,并且放宽了对数据一致性的要求。

非关系型数据库的特点主要有以下几个:

- 灵活的数据模型:非关系型数据库可以根据应用的需求选择和定制适合的数据模型,例如键值对、文档、列族、图等,以满足不同场景和数据结构的存储需求。

- 高可扩展性:非关系型数据库天生支持分布式计算和存储,可以方便地进行横向扩展,以应对大规模数据和高并发访问的需求。

- 高性能和可用性:由于非关系型数据库放宽了对一致性的要求,可以进行异步写入和读写分离等优化,从而获得较好的性能和可用性。

非关系型数据库的典型代表有:MongoDB、Redis、HBase、Neo4j 等。

关系型数据库 VS 非关系型数据库

它们的区别主要体现在以下几点:

数据模型不同:

- 关系型数据库:基于关系模型,数据以表格的形式存储,每个表都有预定义的列和数据类型。表与表之间通过外键建立关系,形成一个相互关联的数据集合。

- 非关系型数据库:不采用表格和关系模型,数据可以以各种形式存储,如键值对、文档、图形等。

数据结构不同:

- 关系型数据库:数据结构严格,需要预先定义好表结构和字段类型,数据修改通常需要遵循一定的规范和约束。

- 非关系型数据库:数据结构灵活,无需预先定义严格的模式,可以根据需要随时添加或修改数据结构。

查询语言不同:

- 关系型数据库:通常使用 SQL(Structured Query Language)进行查询,支持复杂的查询条件、联接操作和聚合函数。

- 非关系型数据库:查询语言因数据库类型而异,有些支持类似 SQL 的查询语法(如 MongoDB 的 MongoDB Query Language),有些则使用特定的 API 或 DSL(领域特定语言)。

事务支持不同:

- 关系型数据库:通常支持 ACID(Atomicity, Consistency, Isolation, Durability)事务特性,保证数据的一致性和完整性。

- 非关系型数据库:事务支持程度因数据库类型而异,只有少量的 NoSQL 数据库可能只提供部分 ACID 特性,或者采用不同的一致性模型(如最终一致性)。

扩展性与性能不同:

- 关系型数据库:传统的关系型数据库在水平扩展方面可能存在挑战,通常通过垂直扩展(增加单台服务器的硬件资源)来提高性能。

- 非关系型数据库:设计上通常更易于水平扩展,通过添加更多服务器来分散数据和负载,以应对大规模数据和高并发访问。

应用场景

- 关系型数据库:适用于需要高度一致性和复杂查询的场景,如金融交易、企业级应用和内容管理系统等。

- 非关系型数据库:适用于海量数据存储、日志系统、大数据分析、实时处理、Web 应用和移动应用等领域,尤其在处理半结构化和非结构化数据时具有优势。

# MySQL 常用引擎有哪些?

MySQL 常用的存储引擎有以下几个:

InnoDB:MySQL(5.5+)的默认存储引擎,支持事务处理、行级锁定和物理外键约束。

- 特性:提供良好的数据一致性、崩溃恢复和高并发性能。

- 使用场景:适用于需要事务支持和多用户读写操作的应用场景。

MyISAM:MySQL 早期的默认存储引擎,不支持事务和行级锁定。

- 特性:提供快速的读取速度和较小的数据存储文件。

- 使用场景:适用于只读或读多写少的应用场景,不需要事务的场景。

MEMORY:将表的数据存储在内存中,提供极快的访问速度。

- 特性:数据在服务器重启后会丢失。

- 使用场景:适用于临时表、缓存表或者需要快速查询的小型表。

# InnoDB 和 MyISAM 有什么区别?

InnoDB 和 MyISAM 是 MySQL 中两种常用的存储引擎,它的区别主要体现在以下几点:

- 事务支持不同:InnoDB 支持事务,MyISAM 不支持事务。

- 锁粒度不同:InnoDB 支持最小的锁粒度为行级锁,而 MyISAM 支持最小的锁粒度是表级锁。

- 外键支持不同:InnoDB 支持物理外键,而 MyISAM 不支持物理外键。

- 索引存储方式不同:InnoDB 索引叶子节点存储的是当前行的数据,而 MyISAM 索引叶子节点存储的是地址,根据地址才能获取当前行的数据。

# 为什么阿里巴巴《Java开发手册》不建议使用物理外键?使用物理外键会带了什么问题?

阿里巴巴《Java开发手册》对于外键的规定如下:

【强制】不得使用外键与级联,一切外键概念必须在应用层解决。 说明:(概念解释)学生表中的 student_id 是主键,那么成绩表中的 student_id 则为外键。如果更新学 生表中的 student_id,同时触发成绩表中的 student_id 更新,即为级联更新。 外键与级联更新适用于单机低并发,不适合分布式、高并发集群;级联更新是强阻塞,存在数据库更新风暴的风险;外键影响数据库的插入速度。

也就是说使用物理外键会带来问题:

- 性能问题:插入之前会先去主键中查询,性能较慢。

- 可能会带来数据库更新风暴问题:数据库更新风暴是指在一个较短的时间内,大量并发的数据库更新操作集中发生,导致数据库服务器在处理这些请求时面临巨大压力,可能引发性能瓶颈、延迟增大甚至系统崩溃的现象。这种情况通常发生在高并发场景下。

# 物理删除和逻辑删除有什么区别?日常开发中会使用哪种删除方式?为什么?

物理删除和逻辑删除的定义如下:

- 物理删除:物理删除是指直接从数据库中永久删除数据记录。物理删除会直接删除相应的数据库行,并释放相关的存储空间。被删除的数据将无法恢复,且不再对应原有的唯一标识。

- 逻辑删除:逻辑删除是指在程序中实现“删除功能”,通常是通过添加一个标记字段或者状态字段来标记该数据为已删除状态。逻辑删除不会直接删除数据记录,而是将数据状态字段标记为已删除状态,表示该数据不再有效。 逻辑删除可以在业务逻辑上使数据不可见,但数据仍然存在于数据库中。逻辑删除可以通过修改查询条件来筛选出未删除或已删除状态的数据。

在日常开发中,使用哪种删除方式会取决于具体需求和业务场景。

- 大部分情况下,对重要的数据,在数据库空间和性能满足的情况下,会采用逻辑删除。这样的好处是可以保留历史数据,方便后续数据恢复和保证数据的完整性。

- 但是如果数据不重要,例如具有时效性的一些日志数据,且数据库对性能和空间有要求的场景下,会使用物理删除来节约系统空间,和提高查询性能。

# 内连接和外连接有什么区别?什么是自连接?举例说明一下?

内连接(INNER JOIN):返回两个表中存在匹配记录的行组合。结果集只包含两个表中键值相等的行。

外连接(OUTER JOIN):外连接分为左外连接(LEFT JOIN 或 LEFT OUTER JOIN)、右外连接(RIGHT JOIN 或 RIGHT OUTER JOIN)和全外连接(FULL JOIN 或 FULL OUTER JOIN)。

- 左外连接:返回所有左表的记录,以及与右表匹配的记录。如果右表没有匹配的记录,则结果集中对应的右表字段为 NULL。

- 右外连接:返回所有右表的记录,以及与左表匹配的记录。如果左表没有匹配的记录,则结果集中对应的左表字段为 NULL。

- 全外连接:返回所有左表和右表的记录,以及两表之间的匹配记录。如果一方没有匹配的记录,则另一方的对应字段为 NULL。

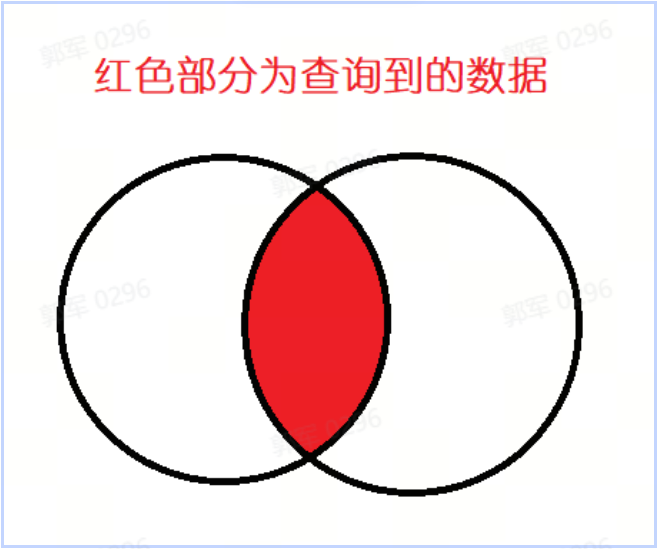

它们的区别是:内连接会查询并返回两个表中的都存在的数据,如下图所示:

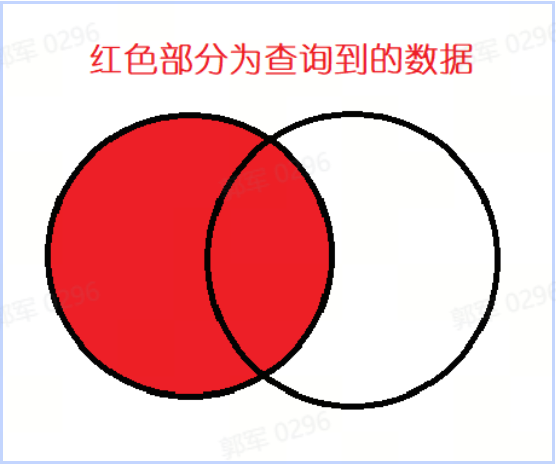

而左外连接是左表的所有数据和右表匹配到的数据,如下图所示:

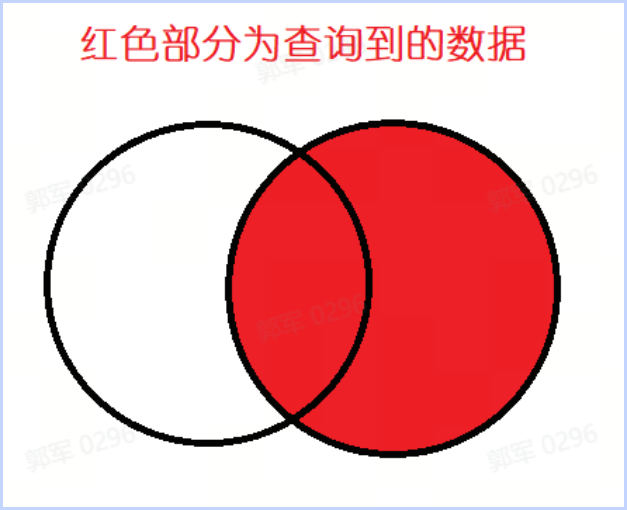

右外连接查询的数据如下图所示:

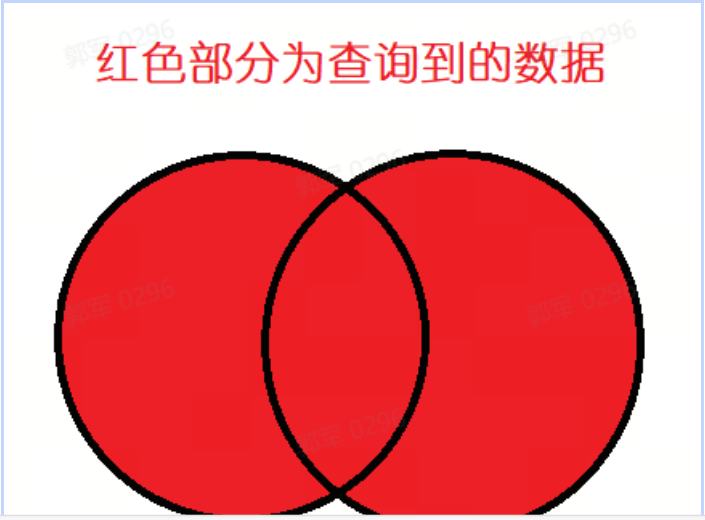

全外查询到的数据如下图所示:

什么是自连接?举例说明

自连接(SELF JOIN):一种特殊的内连接或外连接,用于在同一个表中关联不同的行。通常通过给表别名来实现。

SELECT u1.name AS u_name, u2.name AS manager_name FROM users u1 LEFT JOIN users u2 ON u1.manager_id = u2.id;# 创建索引时会锁表吗?为什么?

在 MySQL 5.6 之前,创建索引时会锁表,所以,在早期 MySQL 版本中一定要在线上慎用,因为创建索引时会导致其他会话阻塞(select 查询命令除外)。

但这个问题,在 MySQL 5.6.7 版本中得到了改变(不再锁表了),因为在 MySQL 5.6.7 中引入了 Online DDL 技术(在线 DDL 技术),它允许在创建索引时,不阻塞其他会话,也就是不再锁表了(所有的 DML 操作都可以一起并发执行)。

Online DDL(Online Data Definition Language,在线数据定义语言)是指在数据库运行期间执行对表结构或其他数据库对象的更改操作,而不需要中断或阻塞其他正在进行的事务和查询。

# 聚簇索引和非聚簇索引有什么区别?

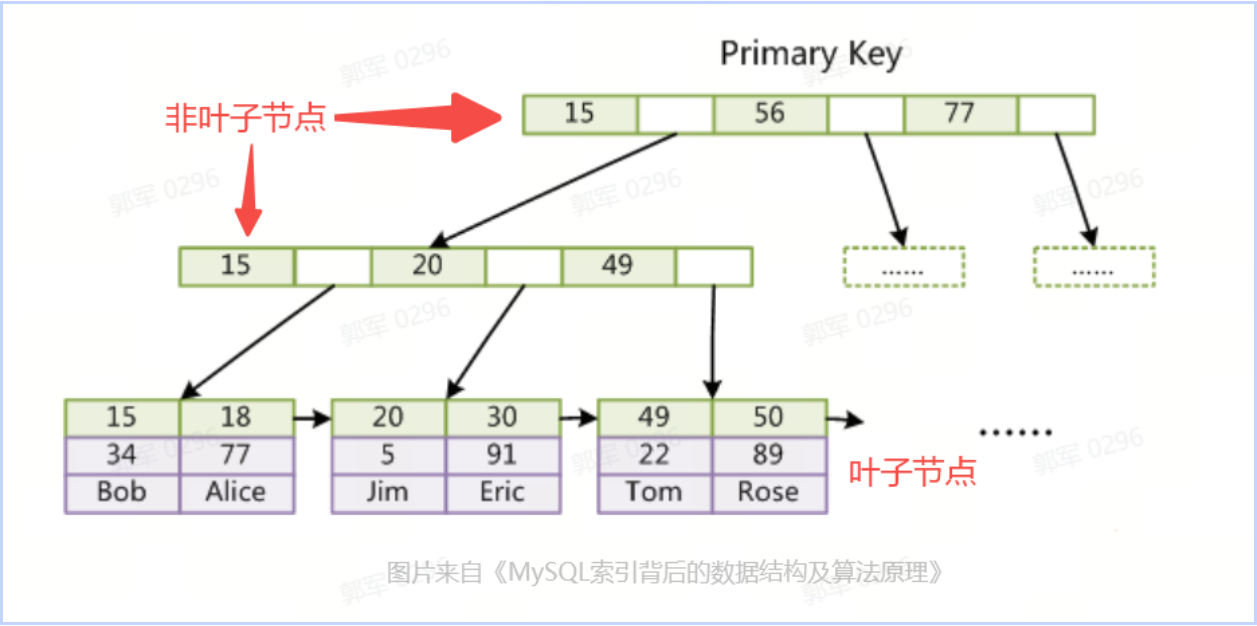

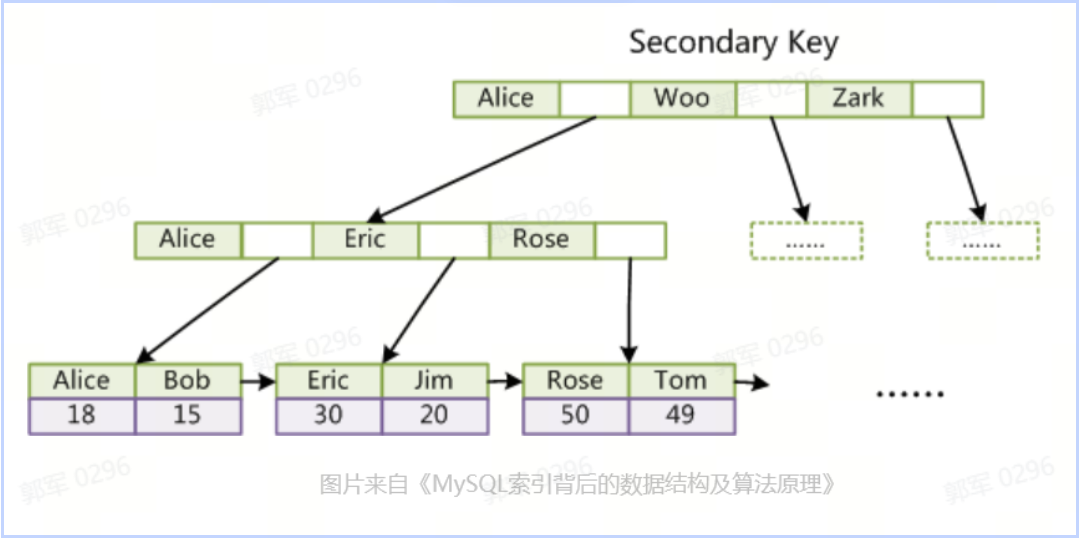

聚簇索引的叶子节点(最底层节点)存储的是数据本身(行数据),而非叶子节点(非最底层节点)存储的是索引键(通常是主键),如下图所示:

叶子节点(Leaf Node)是指没有子节点的节点。它是树的末端节点,也被称为终端节点或终端叶子节点。

非聚簇索引的叶子节点存储的是聚簇索引键(通常是主键),而非数据本身,如下图所示:

# 聚簇索引等于主键索引吗?聚簇索引的生成规则是啥?

聚簇索引大多数情况下等于主键索引(如果主键索引存在的情况下),但如果表中没有主键索引的情况下,聚簇索引就等于其他索引类型了。

聚簇索引的生成规则

如果有主键索引时,那么聚簇索引就等于主键索引,如果没有主键索引,那么聚簇索引的诞生流程依次如下:

- 无主键索引,则使用非空唯一索引:如果表中没有主键索引,那么 InnoDB 会使用第一个唯一索引(unique),且此唯一索引设置了非空约束(not null),我们就使用它作为聚簇索引。

- 无任何满足索引,则生成隐藏聚簇索引:如果一张表既没有主键索引,又没有符合条件的唯一索引,那么 InnoDB 会生成一个名为 GEN_CLUST_INDEX 的隐藏聚簇索引,这个隐藏的索引为 6 字节的长整数类型。

# 索引底层是如何实现的?

MySQL 索引的底层实现取决于存储引擎,但大部分的存储引擎的底层是通过 B+ 树实现的,以默认的存储引擎 InnoDB 为例,其底层是通过 B+ 树实现的,如下图所示:

B+ 树是一种自平衡的、多路搜索树,它的主要特征包含以下几点:

B+ 树是一种自平衡的、多路搜索树,它的主要特征包含以下几点:- 非叶子节点只存储键值和指向子节点的指针。

- 所有叶子节点(最底层的节点)都在同一个级别,并且包含所有的键值和对应的数据行指针或行数据。

- 所有叶子节点在同一层上,并通过双向链表连接,便于范围查询。

# InnoDB索引、MyISAM索引和MEMORY索引底层实现一样吗?

InnoDB 索引、MyISAM 索引和 MEMORY 索引底层实现都不太一样,其中:

- InnoDB 索引底层是通过 B+ 树实现的,并且其叶子节点为整行数据。

- MyISAM 索引底层也是通过 B+ 树实现的,但其叶子节点存储的是内存地址,要根据内存地址寻址才能找到这行数据。

- Memory 索引底层不是通过树实现的,因为其主要为内存引擎,并且适合存储键值数据,所以它使用的是哈希结构实现的索引。

# 索引为什么要使用B+树,其他数据类型不行吗? 为什么?

既然是做索引,那么查询性能就是第一优先考虑条件,而树结构比其他数据类型,例如:链表、队列、栈等查询效率都高,所以首先一定大方向是使用树结构。

哈希索引的查询效率也很高,但没办法进行范围查询,所以也不合适作为大部分存储引擎的底层数据结构。

而树又分为二叉树搜索树和多叉搜索树,而二叉搜索树的每个节点只有一个或两个子节点,这意味着查找一个元素可能需要多次 I/O 操作,而多路搜索树(如 B 树和 B+ 树)的每个节点可以有多个子节点,这使得每个层级可以包含更多的数据,从而减少了查询过程中所需的 I/O 次数。而 I/O 次数是查询中最慢的操作,所以使用多叉搜索树比二叉树更适合做索引。

在多叉树 B+ 树相比于 B 树有以下几点主要优势,所以它更适合做索引:

- IO 次数更少(查询效率更高):B+ 树的非叶子节点不存放实际的记录数据,仅存放索引,因此数据量相同的情况下,相比即存储索引又存储数据的 B 树来说,B+ 树的非叶子节点可以存放更多的索引,因此在查询时 I/O 次数更少,查询效率更高。

- 范围查询性能更高:B+ 树叶子节点之间用链表连接了起来,有利于范围查询;而 B 树要实现范围查询,因此只能通过树的遍历来完成范围查询,这会涉及多个节点的磁盘 I/O 操作,范围查询效率不如 B+ 树。

- 插入和删除性能更好:B+ 树有大量的冗余节点(所有非叶子节点都是冗余索引),这些冗余索引让 B+ 树在插入、删除的效率都更高,比如删除根节点的时候,不会像 B 树那样会发生复杂的树的变化。

# 索引的类型有哪些?

在 MySQL 中索引有很多种分类方法,按照不同的维度,其分类也是不同的。

例如,可以按照字段特性分类、物理存储结构分类或索引的数量等维度进行分类,具体内容如下。

①字段特性分类

- 主键索引:一张表只能有一个主键索引,不允许重复、不允许为 NULL。

- 唯一索引:数据列不允许重复,允许为 NULL 值,一张表可有多个唯一索引,但是一个唯一索引只能包含一列,比如身份证号码、卡号等都可以作为唯一索引。

- 普通索引:一张表可以创建多个普通索引,一个普通索引可以包含多个字段,允许数据重复,允许 NULL 值插入。

- 全文索引:让搜索关键词更高效的一种索引。

②物理存储结构分类

- 聚簇索引(聚集索引):一般是表中的主键索引,如果表中没有显示指定主键,则会选择表中的第一个不允许为 NULL 的唯一索引,如果还是没有的话,就采用 Innodb 存储引擎为每行数据内置的 6 字节 ROWID 作为聚簇索引或聚集索引。每张表只有一个聚集索引,因为聚集索引的键值的逻辑顺序决定了表中相应行的物理顺序。聚集索引在精确查找和范围查找方面有良好的性能表现(相比于普通索引和全表扫描),聚集索引就显得弥足珍贵,聚集索引选择还是要慎重的(一般不会让没有语义的自增 id 充当聚集索引)。

- 非聚簇索引:也叫做二级索引或辅助索引,该索引中索引的逻辑顺序与磁盘上行的物理存储顺序不同(非主键的那一列),一个表中可以拥有多个非聚簇索引。

③ 索引数量分类

- 单列索引:是指对表中的单个列创建的索引。它可以根据该列的值快速定位到对应的记录。单列索引适用于对单个列进行频繁的查询、排序和过滤操作的场景。例如,对于一个用户表,可以为用户 ID 列创建单列索引,以便快速根据用户 ID 进行查询。

- 联合索引(也称为复合索引或组合索引):是指对表中的多个列创建的索引。它可以根据多个列的值进行排序和搜索。组合索引适用于需要同时根据多个列进行查询、排序和过滤操作的场景。例如,对于一个订单表,可以为订单日期和订单状态两列创建组合索引,以便快速根据日期和状态进行查询和排序。

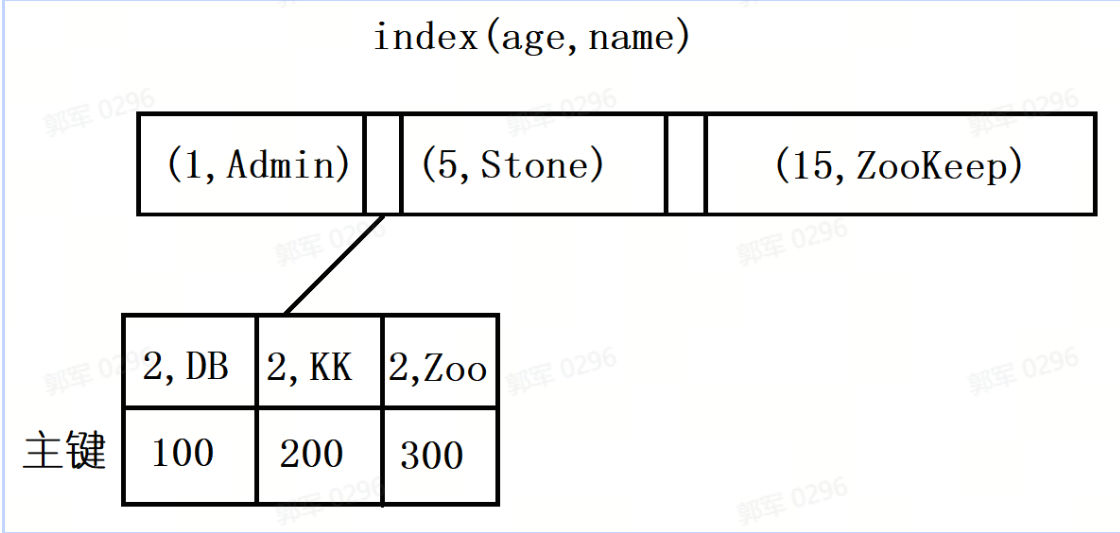

# 什么是最左匹配原则? 为什么要遵循最左匹配原则?

最左匹配原则是指在使用多列联合索引时,索引可以从左到右按顺序匹配查询条件,并提供有效的索引访问。最左匹配原则要求,查询中的条件必须按照联合索引的顺序,从最左边的列开始出现,并且不能跳过任何中间的列。

需要注意的是,在最左匹配的过程中如果遇到范围查询(>、<、between、like)就会停止匹配,其中范围列可以用到索引,但是范围列后面的列无法用到索引,即索引最多用于一个范围列。

为什么一定要遵循最左匹配原则?

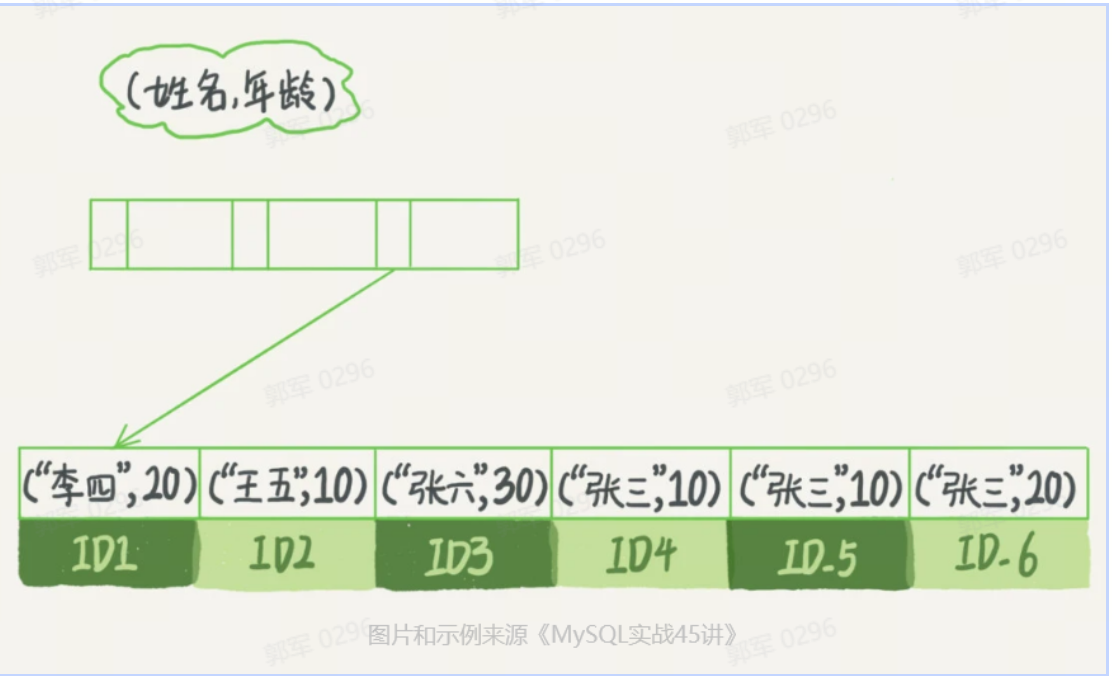

因为对于联合索引来说,它在构造 B+ 树的时候,会先按照左边的 key 进行排序,左边的 key 相同时,再依次按照右边的 key 排序,如下图所示:

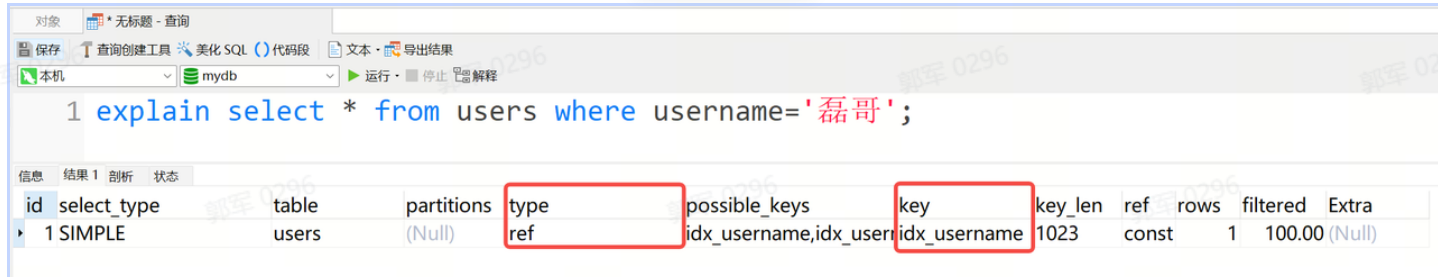

因此,在进行联合查询的时候,必须要遵守最左匹配原则,也就是需要从联合索引的最左边开始进行匹配,才能够准确的进行匹配。 16. #### 日常工作中,如何排查某个SQL是否正确使用了索引? 在日常工作中,可以使用 SQL 查询计划,也就是 explain 来排查某个 SQL 是否使用了索引,以此来实现索引失效排查的问题。 explain 查询计划如下图所示:

查询结果中的字段有很多,我们关注的字段主要有以下两个:

查询结果中的字段有很多,我们关注的字段主要有以下两个:- type:表示查询时使用的访问方法或策略,描述了 MySQL 在执行查询时如何访问数据。常见的 type 值包括:

- ALL:全表扫描,表示 MySQL 将扫描整个表来找到匹配的行。

- index:索引扫描,表示 MySQL 将通过索引进行扫描,但可能需要回表访问数据行。

- range:范围扫描,表示 MySQL 将使用索引的范围条件来定位匹配的行。

- ref:使用非唯一索引进行查找,返回匹配某个值的所有行。

- eq_ref:使用唯一索引进行查找,返回匹配某个值的单个行。

- const:使用常量值进行查找,通常是通过主键或唯一索引进行精确匹配。

- NULL:无效或未知的访问类型。

- key:- 表示查询时使用的索引。如果查询使用了索引,key 字段将显示使用的索引名称;如果查询没有使用索引,key 字段将显示 NULL。

也就说,当 explain 查询计划中的 key 不等于 NULL,并且 type 等于 index、range、ref、eq_ref、const 等时都表示此语句执行了索引查询,也就是索引并未失效。

- type:表示查询时使用的访问方法或策略,描述了 MySQL 在执行查询时如何访问数据。常见的 type 值包括:

# 索引失效的场景有哪些?

索引失效的场景有以下几种:

- 联合索引非最左匹配:当使用联合索引时,未遵循最左匹配原则,则不能正常使用索引,也就是索引失效了。

- 不当模糊查询:模糊查询 like 的常见用法有 3 种(只有第 1 种的会走索引,其他都会导致索引失效):

- 模糊匹配后面任意字符:like '张%'。

- 模糊匹配前面任意字符:like '%张'。

- 模糊匹配前后任意字符:like '%张%'。

- 使用列运算:如果索引列使用了运算,那么索引也会失效。

- 使用函数:查询列如果使用任意 MySQL 提供的函数就会导致索引失效。

- 类型转换:如果索引列存在类型转换,那么也不会走索引,比如某列为字符串类型,而查询的时候设置了 int 类型的值就会导致索引失效。

- 使用 is not null:当在查询中使用了 is not null 也会导致索引失效,而 is null 则会正常触发索引的。

- 使用 or 操作符:当查询条件包含 or 连接的条件,索引也会失效。

# 索引和MySQL中的约束有什么关系?

在 MySQL 中,索引和约束是完全不同的两个概念,其中:

- 索引:一种用于提高查询性能的数据结构,用于加快数据库表的数据检索速度。索引可以通过在列或多个列上创建索引来建立,并且可以使用 B+ 树的数据结构来维护索引的有序性。索引可以加速数据检索,减少磁盘 IO,提高查询效率。在 MySQL 中,可以对表中的列或列组合创建索引,以加速对这些列的查询。

- 约束:一种用于保证数据完整性和一致性的规则。约束可以定义在表和列级别,用于限制表中的数据、列的取值范围以及列之间的关系。常见的约束包括主键约束(PRIMARY KEY)、唯一约束(UNIQUE KEY)、非空约束(NOT NULL)和外键约束(FOREIGN KEY)等。约束可以作为数据的规则进行强制检查,以确保数据的一致性和完整性。

然而,在某些场景下,创建约束时为了加速查询性能所以会自动生成索引,例如以下这些:

- 主键约束(PRIMARY KEY):主键约束定义了表中的一列或多列的唯一性,并且 MySQL 会自动为主键创建一个唯一索引。这意味着当你声明一个字段为 PRIMARY KEY 时,数据库不仅确保该字段的值在全表内是唯一的,还会建立一个用于高效查找行记录的索引。

- 唯一约束(UNIQUE):唯一约束也要求指定列的值必须是唯一的,与主键类似,MySQL 也会为带有 UNIQUE 约束的列创建一个唯一索引,以支持高效的唯一性检查和查询。

- 外键约束(FOREIGN KEY):虽然外键约束本身并不直接创建索引,但在实践中,为了保证对外键引用效率,通常会在外键列上创建索引,以便快速定位到被引用的数据行。

但是,并不是所有的约束都会自动生成索引,例如非空约束就不会自动生成索引。

# 什么是索引覆盖?它给我们提供了什么启示?

索引覆盖(Index Covering)是指查询语句可以完全通过索引来满足,而无需进一步访问表的数据。当一个查询仅需要从索引中获取所需的数据列,而不需要访问表的实际数据行时,就称为索引覆盖。通过索引覆盖,可以减少对磁盘和内存的读取,提高查询的性能。

例如,select id from table where age between 18 and 22,其中 id 为主键,而 age 为二级索引,这时的 SQL 只需要查询主键 id 的值,而 id 的值已经在 age 索引树上了,因此可以直接提供查询结果,不需要回表,这就叫做覆盖索引。

索引覆盖给我们的启示是,在实际工作中,能不使用 select * 就不要使用 select *,因为 select * 一定会进行回表查询,降低查询的效率,并且因为其包含的信息较多,所以也会增加网络带宽的负担,传输效率被拖慢等问题。

# 什么是索引下推?为什么要有索引下推?

索引下推(Index Condition Pushdown,简称 ICP)是指在索引遍历过程中,对索引中包含的字段先做判断,直接过滤掉不满足条件的记录,减少回表次数就叫索引下推。

索引下推是 MySQL 5.6 版本中引入的功能。

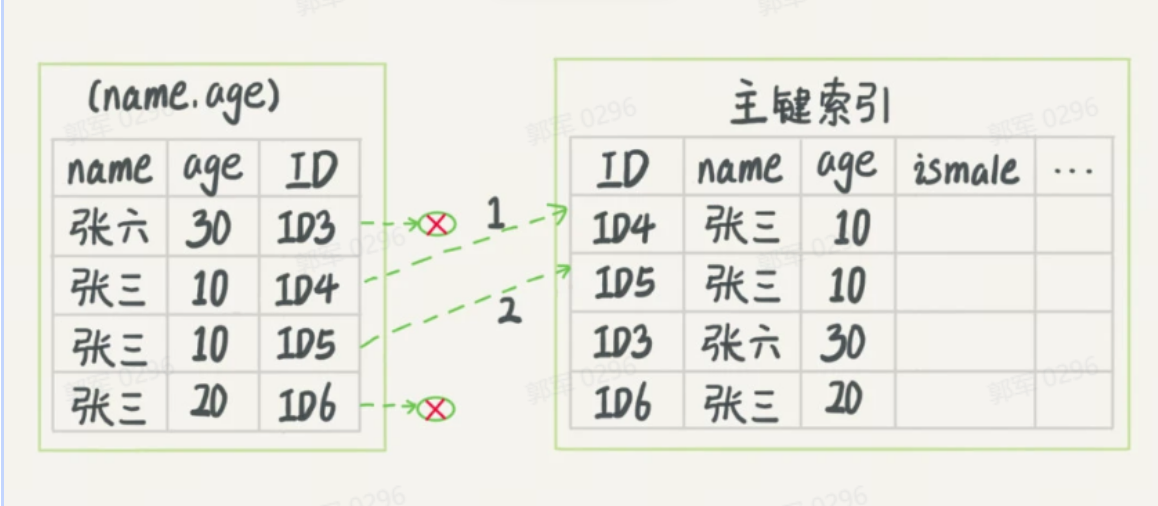

例如,以市民表的联合索引(name, age)为例,如果现在有一个需求:检索出表中“名字第一个字是张,而且年龄是 10 岁的男孩”,SQL 语句是这么写的:

select * from tuser where name like '张%' and age=10 and ismale=1;这个语句在搜索索引树的时候,只能用 “张”,找到第一个满足条件的记录 ID3,如下图所示:

在 MySQL 5.6 之前,查询流程如下图所示,只能根据 name 查询到结果,然后开始回表匹配 age 和 ismale,如下图所示:

而到了 MySQL 5.6 之后,因为有了索引下推技术,它会对索引中包含的字段先做判断,直接过滤掉不满足条件的记录,然后再进行回表查询,所以它的执行流程是这样的:

# 什么是事务?为什么需要事务?

事务(Transaction)是保证数据库可靠性和稳定性的一种机制。它是指数据库中的一组操作,要么全部成功执行,要么全部不执行,不存在中间状态。

为什么需要事务?

事务提供了一种逻辑上的一致性和数据完整性的机制,以确保对数据库的更改是可靠性和可恢复性。

# 事务有哪些特性?举例说明一下

事务具有以下四个特性(ACID 特性):

- 原子性(Atomicity):事务中的所有操作要么全部执行成功,要么全部失败回滚,不能只执行其中一部分操作。

- 一致性(Consistency):事务执行前后,数据库的完整性约束没有被破坏,数据总是从一个一致性状态转移到另一个一致性状态。例如,如果一个事务要求将某个账户的金额从 A 转移到 B,那么无论事务是否成功,最终账户 A 和账户 B 的总金额应该保持不变。

- 隔离性(Isolation):事务之间是相互隔离的,每个事务对其他事务的操作是透明的,一个事务的中间结果对其他事务是不可见的。隔离性可以防止并发执行的事务之间产生脏读、不可重复读和幻读等问题。

- 持久性(Durability):事务完成后,对数据库的修改将永久保存在数据库中,即使系统故障也不会丢失。

事务四大特性是为了保证数据库的数据一致性和可靠性的,使得数据库在并发访问和故障恢复等复杂环境下,仍能保持数据的完整性。

# MySQL如何保证事务四大特性?

以默认数据引擎 InnoDB 为例,它保证事务四大特性的手段分别是:

- 原子性是通过 Undo Log(回滚日志) 来保证的。InnoDB 使用日志(Undo Log)来记录事务的操作,包括事务开始、修改数据和事务提交等。如果事务执行失败或回滚,InnoDB 可以使用日志来撤销已经执行的操作,确保事务的原子性。

- 持久性是通过 Redo Log (重做日志) 来保证的。在事务提交之前,InnoDB 会将事务的修改操作先写入事务日志(Redo Log),然后再将数据写入磁盘。即使在系统崩溃或断电的情况下,InnoDB 可以通过重放事务日志来恢复数据,确保事务的持久性。

- 隔离性是通过 MVCC(多版本并发控制) 和锁机制来保证的。

- 一致性是通过各种约束,如主键、外键、唯一性约束等,加上事务的持久性、原子性和隔离性来保证的。

# 在日常开发中哪些功能会使用到事务?举例说明一下

在日常开发中只要涉及到多张表要一起执行的场景,要么一起成功、要么一起失败的情况,都会使用到事务。例如以下这些场景:

- 银行转账业务:需要给一个账号减钱、然后再给另一个账户加钱,这样使用到事务。

- 电商下单业务:在电商系统中的下单业务也需要事务,需要将账户余额扣减、库存扣减、添加订单等操作,这些都需要放到一个事务里。

- 用户中心完善资料业务:当涉及一个系统中有用户完善资料的场景中通常也需要使用事务,因为这个操作通常至少要修改两个表,一个是修改用户主表信息,然后再给用户积分表添加完善资料的积分操作,所以这种场景需要使用到事务。

类似的场景还有很多,大家可以根据自己业务系统的特点,找几个事务的使用场景。

# 在开发中是怎样使用事务的?

在日常开发中,会用到以下事务:

- 本地事务

- 编程式事务

- 声明式事务

- 分布式事务

具体使用如下。

①本地事务

编程式事务

编程式事务有两种实现方式:

- 使用 TransactionTemplate 对象实现编程式事务。

- 使用更加底层的 TransactionManager 对象实现编程式事务。

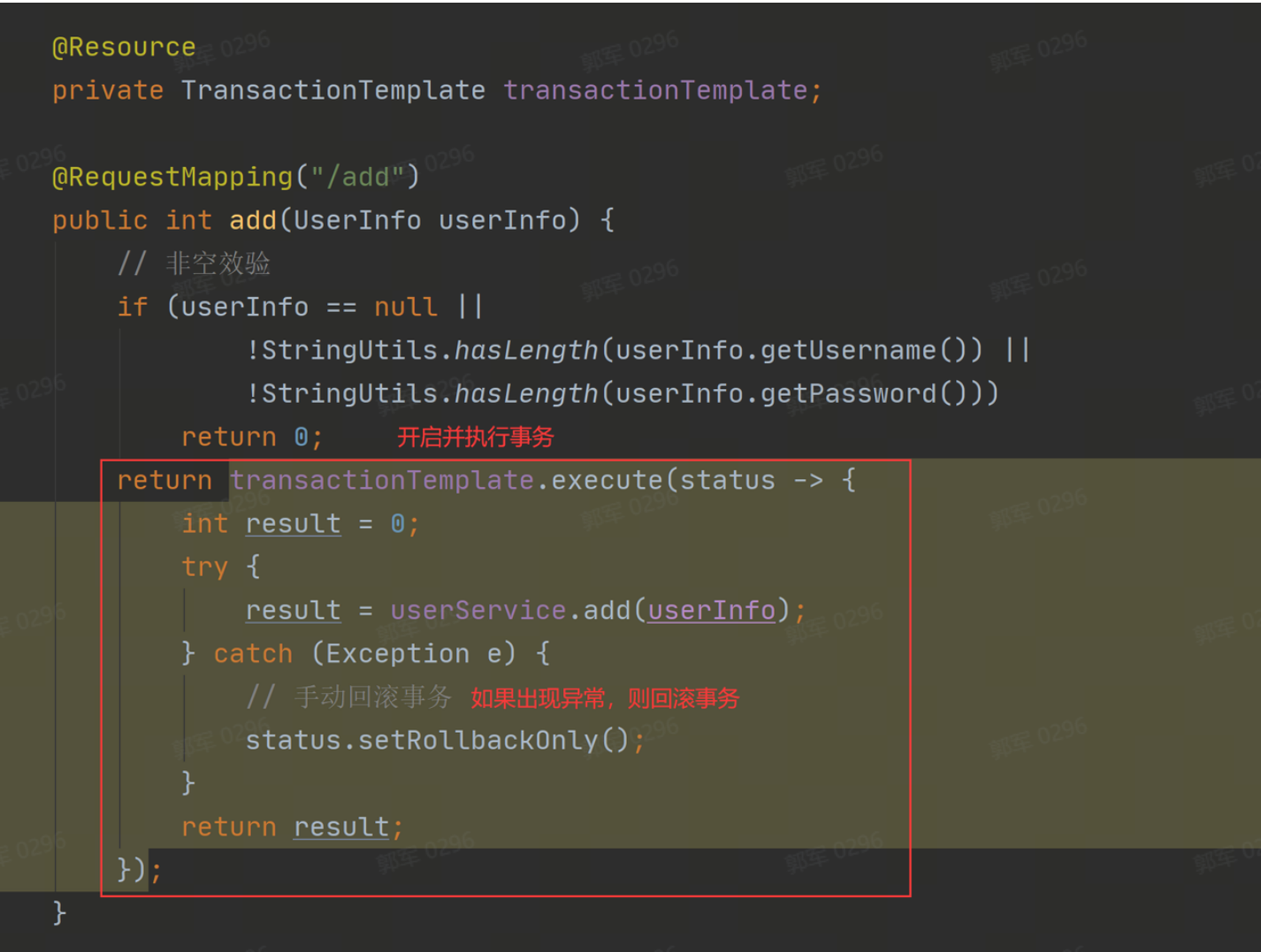

a.TransactionTemplate 编程式事务

要使用 TransactionTemplate 对象需要先将 TransactionTemplate 注入到当前类中 ,然后再使用它提供的 execute 方法执行事务并返回相应的执行结果,如果程序在执行途中出现了异常,那么就可以使用代码手动回滚事务,具体实现代码如下:

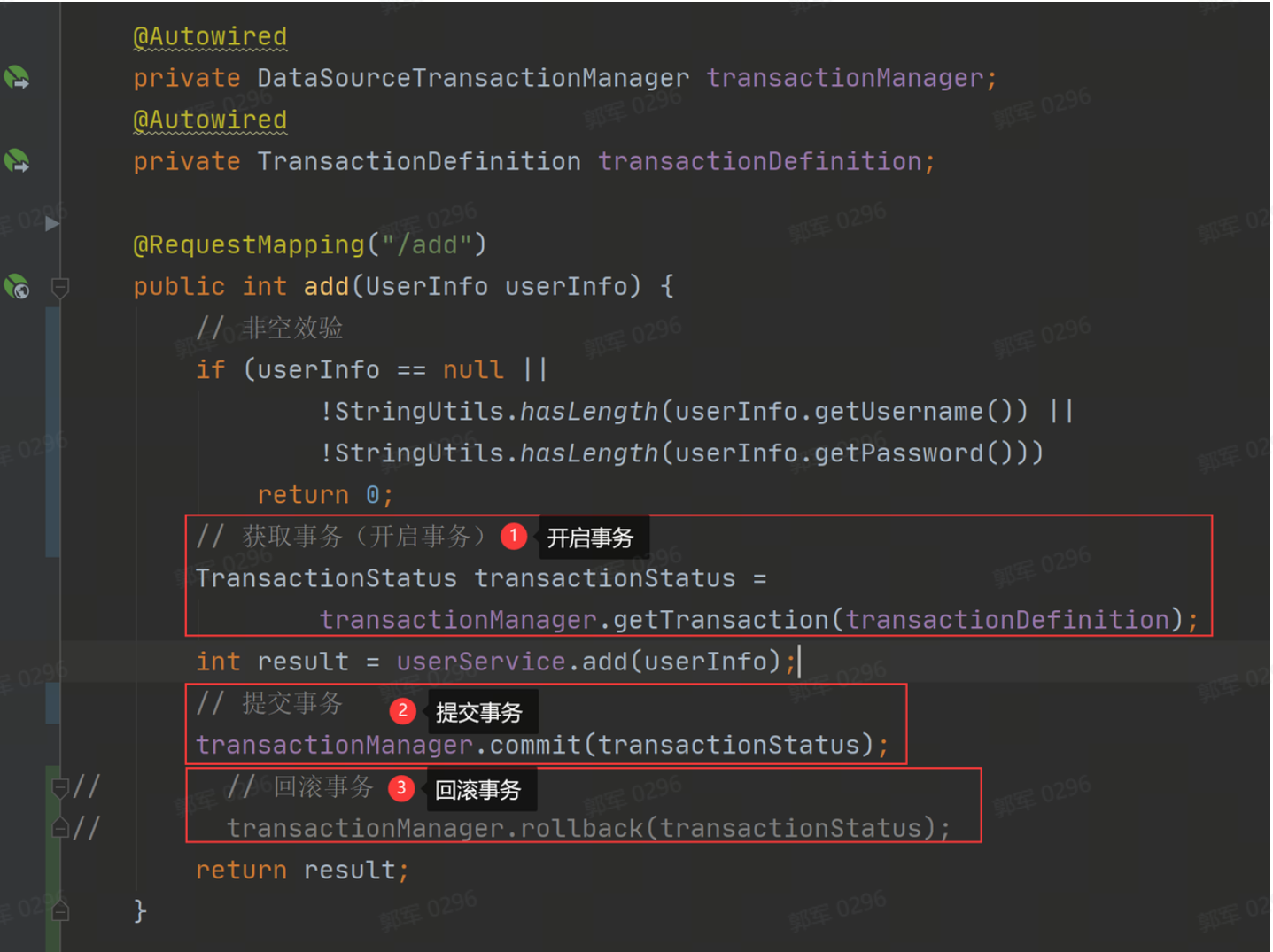

b.TransactionManager 编程式事务

TransactionManager 实现编程式事务相对麻烦一点,它需要使用两个对象:TransactionManager 的子类,加上 TransactionDefinition 事务定义对象,再通过调用 TransactionManager 的 getTransaction 获取并开启事务,然后调用 TransactionManager 提供的 commit 方法提交事务,或使用它的另一个方法 rollback 回滚事务,它的具体实现代码如下:

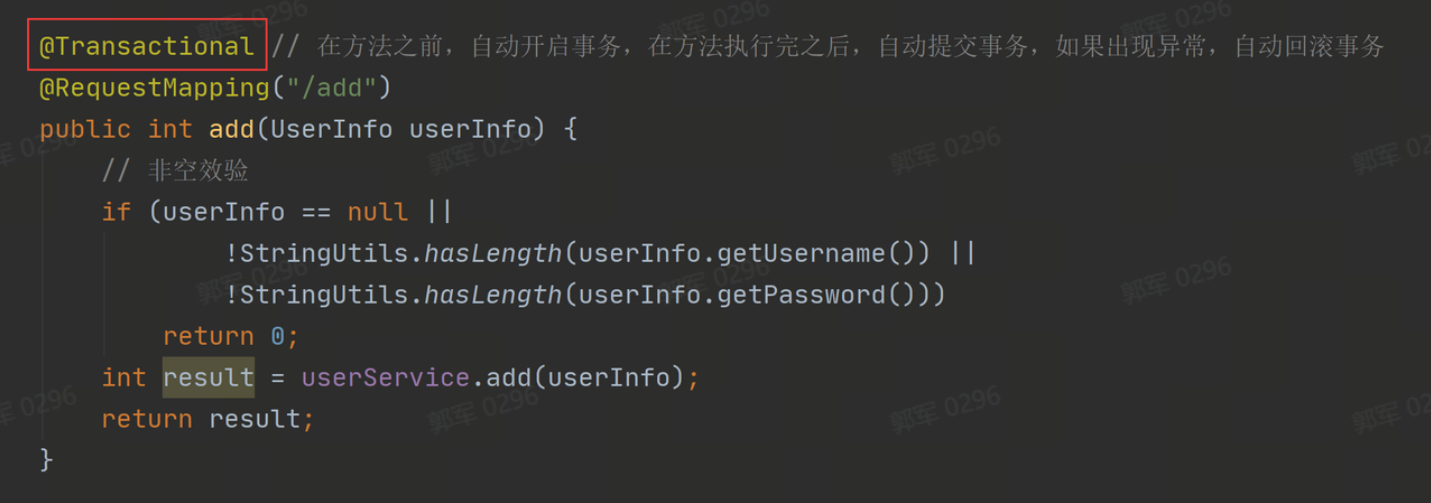

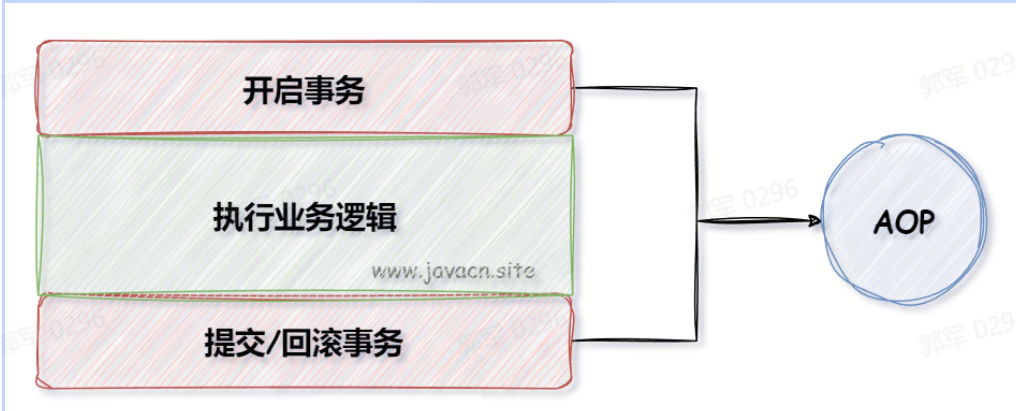

声明式事务

声明式事务的实现比较简单,只需要在方法上或类上添加 @Transactional 注解即可,当加入了 @Transactional 注解就可以实现在方法执行前,自动开启事务;在方法成功执行完,自动提交事务;如果方法在执行期间,出现了异常,那么它会自动回滚事务。

它的具体使用如下:

当然,@Transactional 支持很多参数的设置,它的参数设置列表如下:

参数的设置方法如下:

②分布式事务

分布式事务比较常用的是 Spring Cloud Alibaba Seata,通常会采用 Seata 中的 AT 模式来实现,这需要首先部署 Seata 服务,然后再在程序中配置 Seata 服务器信息,之后再通过注解 @GlobalTransactional 就可以使用分布式事务了。 分布式事务的执行流程如下:

- 本地事务

# MySQL中有哪些事务隔离级别?

MySQL 中有事务隔离级别总共有以下 4 种:

读未提交(Read Uncommitted) :最低的隔离级别,事务中未提交的修改数据,可以被其他事务读取到。

- 优点:并发性能最好,读取到的数据最新。

- 缺点:存在脏读(Dirty Read)问题,即读取到未提交的数据,可能导致数据不一致性。

读已提交(Read Committed):事务中未提交的修改数据,不会被其他事务读取到,此隔离级别看到的数据,都是其他事务已经提交的数据。

- 优点:避免了脏读的问题。

- 缺点:存在不可重复读(Non-Repeatable Read)问题,即同一个事务中,不同时间读取到的数据可能不一样。

可重复读(Repeatable Read):是指在一个事务中,多次执行相同的查询语句可能会得到不同的结果,因为其他并发事务在该事务正在进行时修改了数据。

- 优点:避免了不可重复读的问题。

- 缺点:存在幻读(Phantom Read)问题,即在一个事务中,两次查询同一个范围的记录,但第二次查询却发现了新的记录。

串行化(Serializable):最高的隔离级别,将所有的事务串行执行(一个执行完,另一个再执行),保证了数据的完全隔离。

- 优点:避免了幻读的问题。

- 缺点:并发性能最差,可能导致大量的锁等待和死锁。

MySQL 中的事务隔离级别就是为了解决脏读、不可重复读和幻读等问题的,这 4 种隔离级别与这 3 个问题之间的对应关系如下:

# 不可重复读和幻读有什么区别?

不可重复读(Non-Repeatable Read) 是指在一个事务中,多次执行相同的查询语句可能会得到不同的结果,因为其他并发事务在该事务正在进行时修改了数据。

幻读(Phantom Read) 是指在一个事务中,多次执行相同的查询语句可能会返回不同的结果集,因为其他并发事务在该事务正在进行时插入了新的数据行。

不可重复读 VS 幻读

不可重复读和幻读都是并发事务引起的读一致性问题,但两者关注的侧重点和解决方案不同。

侧重点不同:

- 不可重复读关注的是一行数据的变化,它是指在同一个事务中,多次读取同一行数据的结果不一致。这是由于其他并发事务对同一行数据做了修改(例如更新操作),导致两次读取之间数据发生了变化。

- 幻读关注的是范围数据的变化,它是指在同一个事务中,多次查询同一个范围的数据时,结果集的行数发生变化。这是由于其他并发事务在查询范围内插入了新的数据或者从中删除了数据,导致两次查询之间结果集中的行数发生了变化。

解决方案不同:

- 不可重复读通常使用行锁来解决,因为它关注的是一行数据。

- 幻读通常使用间隙锁来解决,因为它关注的是范围数据。

# 如何解决不可重复读和幻读的问题?

不可重复读和幻读都可以通过设置事务的隔离级别来解决,例如将事务隔离级别设置为串行化,那么不可重复读和幻读问题都没有了。但是串行化的执行效率比较低,所以在日常工作中我们是这样解决不可重复读和幻读问题的:

- 解决不可重复读问题:将数据库的隔离级别设置为可重复读 RR 级别(它是 MySQL 默认事务隔离级别)就可以解决不可重复读了。

- 解决幻读问题:通过 MVCC + MySQL 中的锁机制可以解决幻读问题。

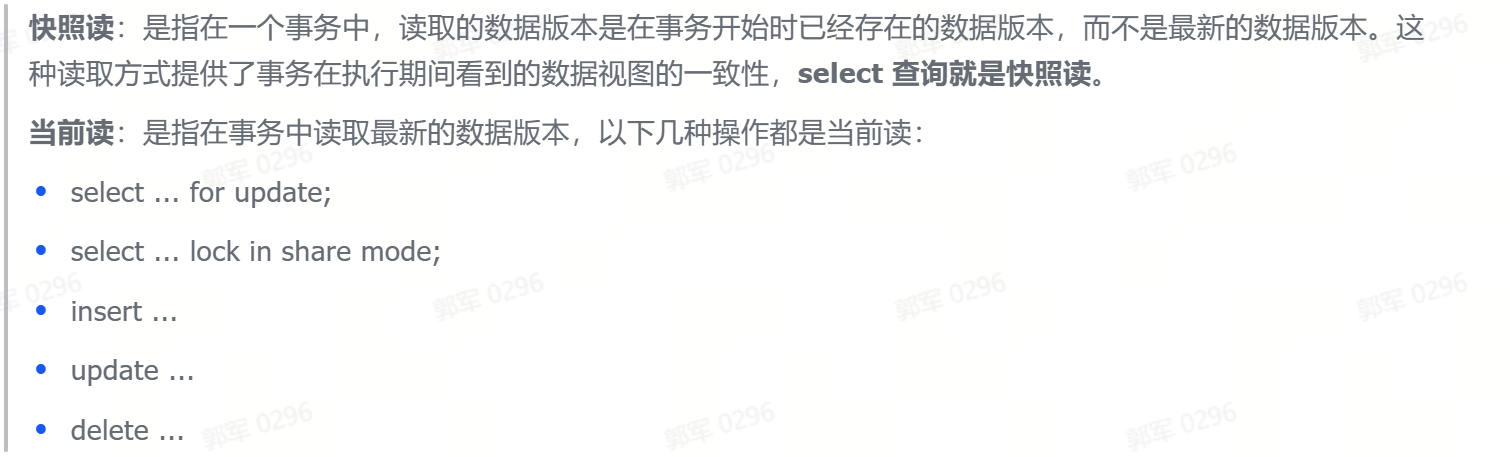

# 什么是MVCC机制?它能解决幻读问题吗?为什么?

MVCC(Multi-Version Concurrency Control)是一种并发控制机制,用于解决数据库并发访问中,数据一致性问题。

所谓的一致性问题,就是在并发事务执行时,应该看到哪些数据和不应该看到哪些数据。

在 MVCC 机制中,每个事务的读操作都能看到事务开始之前的一致性数据快照,而不受其他并发事务的修改的影响。核心思想是通过创建多个数据版本,保持事务的一致性和隔离性。

使用 MVCC 机制解决了 RR 隔离级别中,部分幻读问题,但又没把全部幻读问题都解决。

- MVCC 解决了 RR 隔离级别中,快照读的幻读问题。多次查询快照读时,因为 RR 级别是复用 Read View(读视图),所以没有幻读问题。

- 但 MVCC 解决不了 RR 隔离级别中,如果遇到快照读和当前读(读取当前最新的数据)中间发生过添加操作,那么 Read View 不能复用,就出现了幻读的问题。

所以说 MVCC 可以解决 RR 级别中快照读的幻读问题,但解决不了 RR 级别中的当前读的幻读问题,因为当前读是读取最新数据,此时 MVCC 机制也解决不了幻读问题了,但可以使用锁(Next-Lock)配合 MVCC 彻底解决幻读问题。

所以说 MVCC 可以解决 RR 级别中快照读的幻读问题,但解决不了 RR 级别中的当前读的幻读问题,因为当前读是读取最新数据,此时 MVCC 机制也解决不了幻读问题了,但可以使用锁(Next-Lock)配合 MVCC 彻底解决幻读问题。

# MySQL 有哪些重要的日志?

MySQL 中的重要日志有以下这些:

- 慢查询日志(Slow Query Log):记录执行时间超过指定阈值的查询语句。慢查询日志可以帮助识别性能较差的查询语句,以便进行优化。此日志默认关闭,需要手动开启。

- 二进制日志(Binary Log):记录对数据库进行更改的所有操作,包括 INSERT、UPDATE、DELETE 等。二进制日志可以用于数据恢复、主从复制和数据同步等场景。

- 回滚日志(Undo Log):InnoDB 引擎中的日志,主要用于事务回滚和 MVCC 机制。

- 重做日志(Redo Log):InnoDB 引擎中的日志,主要用于掉电或其他故障恢复的持久化日志。

# 五. Redis模块

# Redis为什么执行这么快?

Redis 运行比较快的原因主要有以下几点:

- 纯内存操作:Redis 将所有数据存储在内存中,这意味着对数据的读写操作直接在内存中进行,而内存的访问速度远远高于磁盘。这种设计使得 Redis 能够以接近硬件极限的速度处理数据读写。

- 单线程模型:Redis 使用单线程模型来处理客户端请求。这可能听起来似乎效率不高,但实际上,这种设计避免了多线程频繁切换和过度竞争所带来的性能开销。Redis 每个请求的执行时间都很短,因此在单线程下,也能够处理大量的并发请求。

- I/O多路复用:Redis 使用了 I/O 多路复用技术,可以在单个线程中同时监听多个客户端连接,只有当有网络事件发生时才会进行实际的 I/O 操作。这样有效地利用了 CPU 资源,减少了无谓的等待和上下文切换。

- 高效数据结构:Redis 提供了多种高效的数据结构,如哈希表、有序集合等。这些数据结构的实现都经过了优化,使得 Redis 在处理这些数据结构的操作时非常高效。

# Redis是单线程执行还是多线程执行?它有线程安全问题吗?为什么吗?

在 Redis 的早期版本中(Redis 6.0 之前)确实是单线程运行的,所有客户端的请求处理、命令执行以及数据读写操作都是在一个主线程中完成。这种设计最初的目的就是为了避免,多线程环境下的锁竞争和上下文切换所带来的性能开销,从而保证高并发场景下的性能。 然而,在 Redis 6.0 版本中,开始引入了对多线程的支持,但这仅限于网络 I/O 层面,即在网络请求阶段使用工作线程进行处理,以提高网络吞吐量。

也就是说,在 Redis 6.0 之后,采用了多个 IO 线程来处理网络请求,网络的请求和解析由这些 IO 多线程来完成的,但解析完成之后,会把解析的结果交由主线程来执行。

所以,即使在 Redis 6.0 当中,也是没有多线程的并发问题的,因为多线程只负责解析网络请求,之后的读写操作都是统一由 Redis 的主线程(单线程)统一来执行的。

# 在实际工作中,使用Redis实现了哪些业务场景?

Redis 在实际工作当中,实现的常见功能有以下几个:

- 缓存服务:Redis 常被用作数据库查询结果或动态生成内容的缓存服务,能够显著提高应用程序的性能。

- 分布式锁:在分布式系统单机锁(synchronized、ReentrantLock)就失去作用了,此时就可以使用 Redis 来实现分布式锁,因为 Redis 天然就是分布式系统,所以使用它来实现分布锁也很方便。

- 存储会话信息:一些小型公司可能会使用 Redis 来存储用户会话信息,还有一些中型公司会使用 Redis 配合 JWT(JSON Web Token,一种登录的认证方式)来实现会话的自动续期功能。

- 布隆过滤器: Redis 4.0 之后,可以根据此版本中提供的 modules (扩展模块) 的方式,非常方便的引入布隆过滤器(插件)的功能了,使用它可以实现大数据下的高性能数据筛查。布隆过滤器的特点是:它说没有的值一定没有,它说有的值有可能没有。

# Redis常用数据类型有哪些?

在 Redis 中,常用的数据类型有以下这些:

- String(字符串):常见使用场景是存储 Session 信息、存储缓存信息(如详情页的缓存)、存储整数信息,可使用 incr 实现整数+1,和使用 decr 实现整数 -1。

- List(列表类型):常见使用场景是实现简单的消息队列、存储某项列表数据。

- Hash(哈希表):常见使用场景是存储 Session 信息、存储商品的购物车,购物车非常适合用哈希字典表示,使用人员唯一编号作为字典的 key,value 值可以存储商品的 id 和数量等信息、存储详情页信息。

- Set(集合):一个无序并唯一的键值集合,它的常见使用场景是实现关注功能,比如关注我的人和我关注的人,使用集合存储,可以保证人员不会重复。

- Sorted Set(有序集合):相比于 Set 集合类型多了一个排序属性 score(分值),它的常见使用场景是可以用来存储排名信息、关注列表功能,这样就可以根据关注实现排序展示了。

PS:有序集合 Sorted Set 也被称为 ZSet,原因是有序列表的底层数据库实现是 ziplist 或 zskiplist,所以也被称之为 ZSet。

# 存储Session信息你会使用哪种数据类型?为什么?

在实际工作中,小型项目会使用 Redis 存储 Session 信息,但不同的业务场景存储 Session 信息的类型也是不同的,具体来说:

- 存储数据简单(不涉及局部更新):使用 String 类型存储 Session,这样做的优缺点如下:

优点:

- 存取操作简单直观,只需要对单个键执行操作即可。

- 对于小型 Session,存储开销相对较小。 缺点:

- 如果 Session 数据复杂或者需要频繁更新其中的部分字段,则每次更新都需要重新序列化整个 Session 对象。

- 不利于查询 Session 内的特定字段值。

- 存储数据复杂(涉及局部更新):如果 Session 数据结构复杂且需要频繁更新或查询其中的个别字段,通常建议使用哈希表来存储 Session。每个 Session 视为一个独立的哈希表(Hash),Session ID 作为 key,Session 内的各个字段作为

field-value 对存储在该哈希表内。示例:HSET session:123 userId 123 username user1,这样做的优缺点如下:

优点:

- 可以方便地进行字段级别的读写操作,例如 HGET session:123 userId 和 HSET session:123 lastAccessTime now。

- 更新部分字段时无需修改整个 Session 内容。 缺点:

- 相对于简单的字符串存储,哈希表占用的空间可能更大,尤其是当 Session 数据包含许多字段时。

小结:如果 Session 数据结构复杂且需要频繁更新或查询其中的个别字段,通常建议使用哈希表来存储 Session;而在 Session 数据较为简单、不涉及局部更新的情况下,使用字符串存储也是可行的选择。

- 存储数据简单(不涉及局部更新):使用 String 类型存储 Session,这样做的优缺点如下:

优点:

# 有序集合底层是如何实现的?

有序列表在 Redis 7 之前底层是使用 ziplist(压缩列表)+ skiplist(跳跃表),其中:

- 当数据列表元素个数要小于 128 个,并且所有元素成员的长度都必须小于 64 字节时,会使用压缩列表来存储。

- 否则,则使用跳跃表 skiplist 来存储。

但是,到了 Redis 7 之后,就开始使用紧凑列表 listpack 替代了压缩列表 ziplist 来实现了。

所以说:

- Redis 7 之前(不含 Redis 7):有序列表使用的是 ziplist(压缩列表)+ skiplist(跳跃表)实现的。

- Redis 7 及之后:有序列表使用的是 listpack(紧凑列表)+ skiplist(跳跃表)实现的。

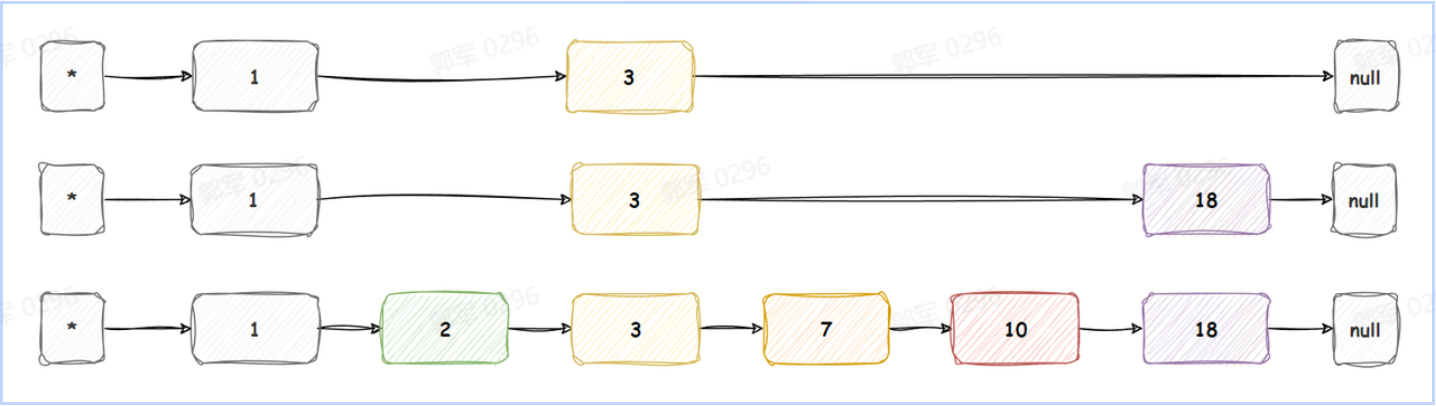

# 什么是跳表?为什么要用跳表?

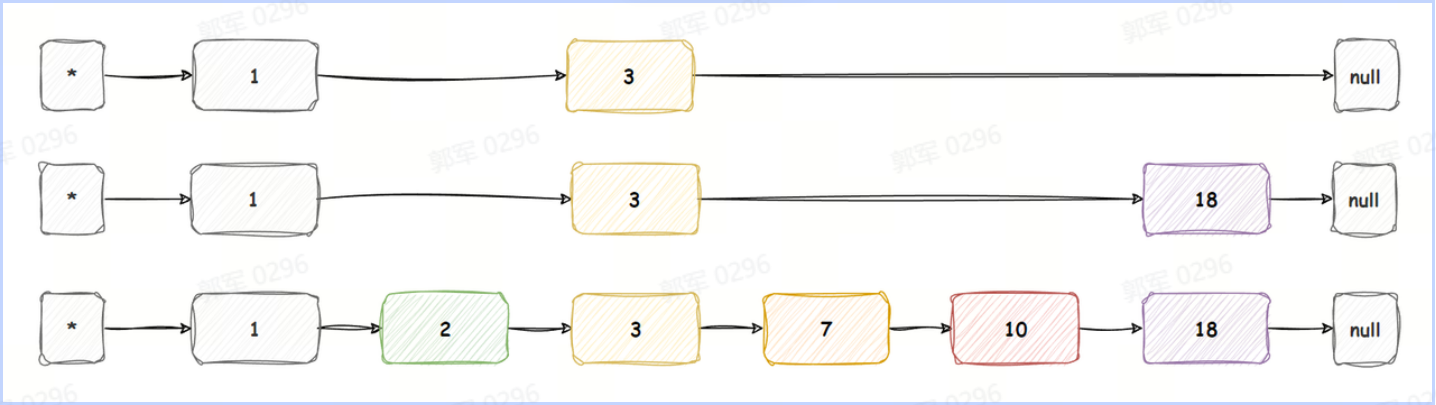

跳跃表 SkipList,也称之为跳表,是一种数据结构,用于在有序元素的集合中进行高效的查找操作。它通过添加多层链表的方式,提供了一种以空间换时间的方式来加速查找。

跳跃表由一个带有多层节点的链表组成,每一层都是原始链表的一个子集。最底层是一个完整的有序链表,包含所有元素。每个更高层级都是下层级的子集,通过添加额外的指针来跳过一些元素。这些额外的指针称为“跳跃指针”,它们允许快速访问更远的节点,从而减少了查找所需的比较次数。

跳跃表的平均查找时间复杂度为 O(log n),其中 n 是元素的数量,这使得它比普通的有序链表具有更快的查找性能,并且与平衡二叉搜索树(如红黑树)相比,实现起来更为简单。

简单的跳跃表如下图所示:

所以说,之所以使用跳表的原因是因为它可以提高有序列表的查询速度,查询性能从链表 O(n) 复杂度提升到了 O(log n) 时间复杂度,是一种以空间换时间的解决方案。

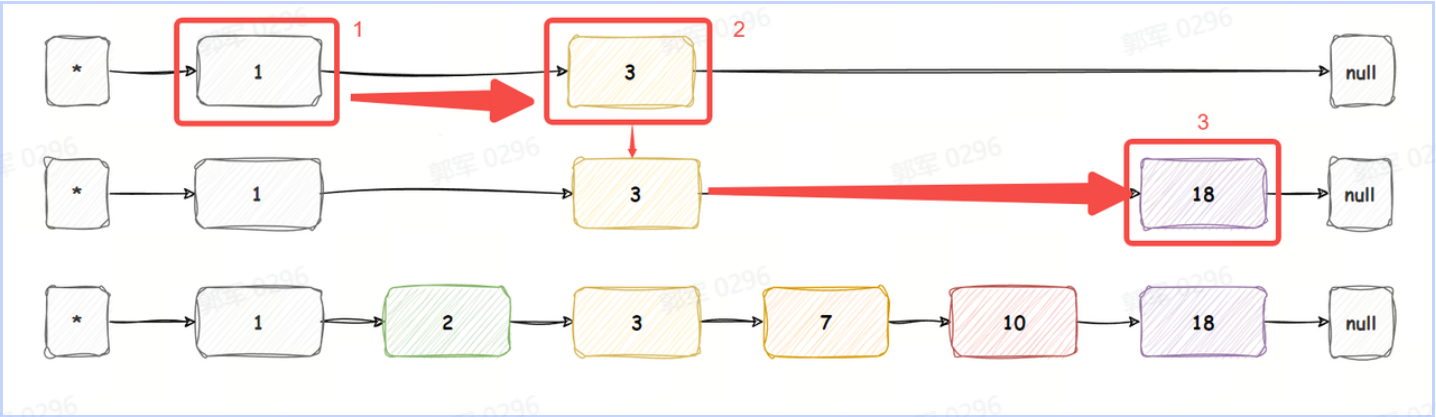

# 说一下跳表的查询流程?

跳表的查询流程如下:

- 起始搜索:查询操作从跳表的顶层开始,跳表的顶层包含一个或多个节点,从最顶层的头节点开始,将当前节点设为头节点。

- 检查下一个节点:检查当前节点的下一个节点,如果节点的分值小于目标分值,则右移检查下一个节点,然后重复此步骤,直到找到一个大于目标分值的节点,或为最后一个节点。

- 逐层下探:如果当前下一个节点的值大于目标分值,或为最后一个节点,则将当前指针向下一层级进行搜索,重复上述步骤。

- 终止并返回:在查找的过程中,如果找到了和目标分值相同的值,或者遍历完所有层级仍然未找到对应节点,则说明要查找的元素不存在于跳表中,则终止查找并返回查询到的内容或 NULL 值。

例如,以下跳跃表,查询分值为 18 的元素,查询流程如下:

从最顶层开始查询,查询流程如下图所示:

经过 3 次就找到了该节点。

PS:如果从最上层找到最下层,无匹配的节点就返回 null。

# 说一下跳表的添加流程?为什么要有“随机层数”这个概念?

要搞懂跳跃表的添加流程,首先要搞懂下面的前置知识。 前置知识:节点随机层数

所谓的随机层数指的是每次添加节点之前,会先生成当前节点的随机层数,根据生成的随机层数来决定将当前节点存在几层链表中。 为什么要这样设计呢? 这样设计的目的是为了保证 Redis 的执行效率,如果使用固定规律的跳表,为了维护固定的规律,所以在添加和删除节点时,跳表的整体变动非常大,效率也非常低。而使用随机层数,在添加和删除时,其他节点无需改动,因此效率要比固定规律的跳表性能高很多,所以 Redis 采用了节点随机层数。

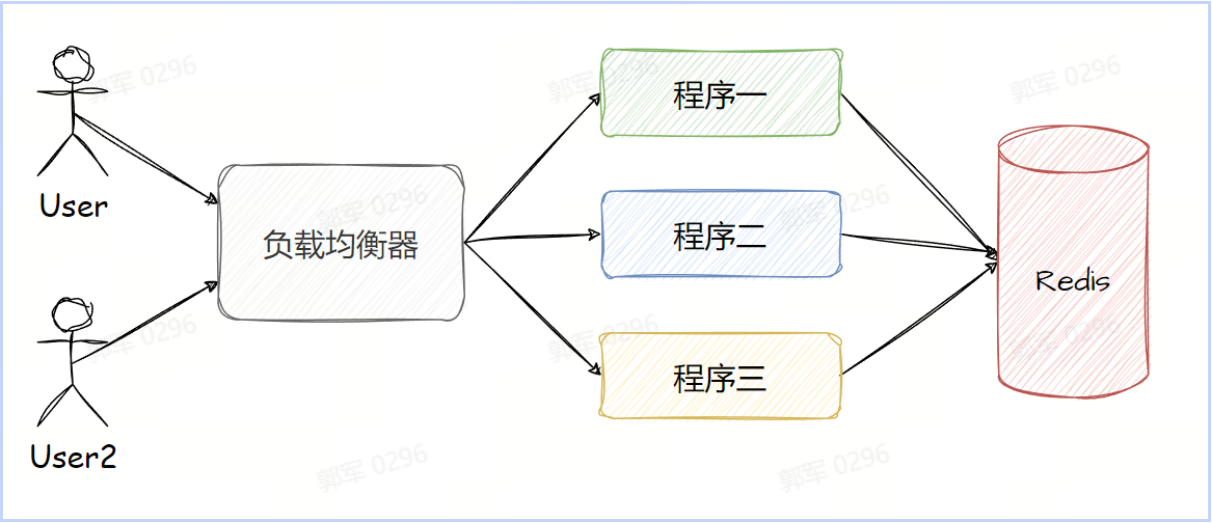

# 使用Redis如何实现分布式锁?

首先来说 Redis 作为一个独立的三方系统,其天生的优势就是可以作为一个分布式系统来使用,因此使用 Redis 实现的锁都是分布式锁,如下所示:

实现分布式锁 使用 Redis 实现分布式锁可以通过 setnx(set if not exists)命令实现,当我们使用 setnx 创建键值成功时,则表明加锁成功,否则既代码加锁失败,实现示例如下:

127.0.0.1:6379> setnx lock true (integer) 1 #创建锁成功 #逻辑业务处理...当我们重复加锁时,只有第一次会加(分布式)锁成功,执行结果如下:

127.0.0.1:6379> setnx lock true # 第一次加锁 (integer) 1 127.0.0.1:6379> setnx lock true # 第二次加锁 (integer) 0从上述命令中可以看出,我们可以使用执行的结果是否为 1 来判断加锁是否成功。

释放分布式锁

127.0.0.1:6379> del lock (integer) 1 #释放锁然而,如果使用 setnx lock true 实现分布式锁会存在死锁问题,以为 setnx 如未设置过期时间,锁忘记删了或加锁线程宕机都会导致死锁,也就是分布式锁一直被占用的情况。

解决死锁问题 死锁问题可以通过设置超时时间来解决,如果超过了超时时间,分布锁会自动释放,这样就不会存在死锁问题了。也就是 setnx 和 expire 配合使用,在 Redis 2.6.12 版本之后,新增了一个强大的功能,我们可以使用一个原子操作也就是一条命令来执行 setnx 和 expire 操作了,实现示例如下:

127.0.0.1:6379> set lock true ex 30 nx OK #创建锁成功 127.0.0.1:6379> set lock true ex 30 nx (nil) #在锁被占用的时候,企图获取锁失败其中 ex 为设置超时时间, nx 为元素非空判断,用来判断是否能正常使用锁的。 因此,我们在 Redis 中实现分布式锁最直接的方案就是使用 set key value ex timeout nx 的方式来实现。

# 有序集合在日常工作中的使用场景有哪些?

有序集合在工作中的应用场景有很多,例如以下这些常见的使用场景:

- 排行榜:可以将用户的得分作为有序集合的分值,用户的 ID 作为成员,通过有序集合的排名功能可以得到用户的排名信息。当然也可以是文章的热度、商品的热度等排行榜,如下所示:

zadd hot 100 aid_1 99 aid_2 95 aid_3 90 aid_4- 用户关注集合:可以将用户的关注数作为有序集合的分值,用户 ID 作为成员,通过分值的排序可以得到关注数最多的用户。当然也可以把用户的关注时间戳作为分值,如下所示:

zadd user_1_friends 1704179221 zhangsan 1704179222 lisi- 商品价格排序:可以将商品的价格作为有序集合的分值,商品 ID 作为成员,通过有序集合的排序功能可以得到价格从高到低的商品列表。

- 时间轴(timeline):可以将事件的时间戳作为有序集合的分值,事件内容作为成员,通过有序集合的排序功能可以得到按时间顺序排列的事件内容。例如某某事件最新进展(每隔一段时间,例如 60s 更新一下时间轴事件)。

# 使用Redis实现分布式锁存在什么问题?如何解决这些问题?

默认情况下,如果使用 setnx lock true 实现分布式锁会存在以下问题:

- 死锁问题:setnx 如未设置过期时间,锁忘记删了或加锁线程宕机都会导致死锁,也就是分布式锁一直被占用的情况。

- 锁误删问题:setnx 设置了超时时间,但因为执行时间太长,所以在超时时间之内锁已经被自动释放了,但线程不知道,因此在线程执行结束之后,会把其他线程的锁误删的问题。

- 不可重入问题:也就是说同一线程在已经获取了某个锁的情况下,如果再次请求获取该锁,则请求会失败(因为只有在第一次能加锁成功)。也就是说,一个线程不能对自己已持有的锁进行重复锁定。

- 无法自动续期:线程在持有锁期间,任务未能执行完成,锁可能会因为超时而自动释放。SETNX 无法自动根据任务的执行情况,设置新的超时实现,以延长锁的时间。

而这些问题的解决方案也是不同的。

① 解决死锁问题 死锁问题可以通过设置超时时间来解决,如果超过了超时时间,分布锁会自动释放,这样就不会存在死锁问题了。也就是 setnx 和 expire 配合使用,在 Redis 2.6.12 版本之后,新增了一个强大的功能,我们可以使用一个原子操作也就是一条命令来执行 setnx 和 expire 操作了,实现示例如下:

127.0.0.1:6379> set lock true ex 30 nx OK #创建锁成功 127.0.0.1:6379> set lock true ex 30 nx (nil) #在锁被占用的时候,企图获取锁失败其中 ex 为设置超时时间, nx 为元素非空判断,用来判断是否能正常使用锁的。

② 解决锁误删问题

锁误删可以通过将锁标识存储到 Redis 中来解决,删除之前先判断锁归属(也就是将线程 id 存储到分布式的 value 值内,删除之前先判断锁 value 值是否等于当前线程 id),如果属于你的锁再删除,否则不删除就可以,这就解决了锁误删的问题。

但这样解决因为判断和删除是非原子操作,所以依旧有问题,这个问题可以通过编写 lua 脚本或使用 Redisson 框架来解决,因为他们两都能保证判断和删除的原子性。

Lua 脚本指的是使用 Lua 语言编写的一段可执行的程序代码。Lua 是一种轻量级、高效、可嵌入的脚本语言,广泛应用于各种领域,包括游戏开发、嵌入式应用、脚本扩展等。 在 Redis 中,通过使用内置的 Lua 解释器,用户可以通过编写 Lua 脚本来执行一系列的操作。用户可以将一段 Lua 脚本传递给 Redis,并在 Redis 服务器端进行执行。Redis 提供了一系列的功能函数和 API 供 Lua 脚本使用,例如,命令操作、数据读写、事务处理等。

③ 通用解决方案

以上问题有一个通用的解决方案,那就是使用 Redisson 框架来实现 Redis 分布式锁,这样既可以解决死锁问题,也可以解决锁误删、不可重入和无法自动续期的问题了。

# 说一下什么是Redisson?使用它如何实现分布式锁?它实现的分布式锁有什么优点?

Redisson 是一个开源的用于操作 Redis 的 Java 框架。与 Jedis 和 Lettuce 等轻量级的 Redis 框架不同,它提供了更高级且功能丰富的 Redis 客户端。它提供了许多简化 Redis 操作的高级 API,并支持分布式对象、分布式锁、分布式集合等特性。

Redisson 优点

- Redisson 可以设置分布式锁的过期时间,从而避免锁一直被占用而导致的死锁问题。

- Redisson 在为每个锁关联一个线程 ID 和重入次数(递增计数器)作为分布锁 value 的一部分存储在 Redis 中,这样就避免了锁误删和不可重入的问题。

- Redisson 还提供了自动续期的功能,通过定时任务(看门狗)定期延长锁的有效期,确保在业务未完成前,锁不会被其他线程获取。

Redisson 实现分布锁 ① 添加 Redisson 框架支持 如果是 Spring Boot 项目,直接添加 Redisson 为 Spring Boot 写的如下依赖:

<!-- Redisson --> <!-- https://mvnrepository.com/artifact/org.redisson/redisson-spring-boot-starter --> <dependency> <groupId>org.redisson</groupId> <artifactId>redisson-spring-boot-starter</artifactId> <version>3.25.2</version> <!-- 请根据实际情况使用最新版本 --> </dependency>其他项目,访问 https://mvnrepository.com/search?q=Redisson 获取具体依赖配置。

② 配置 RedissonClient 对象

将 RedissonClient 重写,存放到 IoC 容器,并且配置连接的 Redis 服务器信息。

import org.redisson.Redisson; import org.redisson.api.RedissonClient; import org.redisson.config.Config; import org.springframework.context.annotation.Bean; import org.springframework.context.annotation.Configuration; @Configuration public class RedissonConfig { @Bean public RedissonClient redissonClient() { Config config = new Config(); // 也可以将 redis 配置信息保存到配置文件 config.useSingleServer().setAddress("redis://127.0.0.1:6379"); return Redisson.create(config); } }③ 创建分布式锁

Redisson 分布式锁的操作和 Java 中的 ReentrantLock(可重入锁)的操作很像,都是先使用 tryLock 尝试获取(非公平)锁,最后再通过 unlock 释放锁,具体实现如下:

import org.redisson.api.RLock; import org.redisson.api.RedissonClient; import org.springframework.beans.factory.annotation.Autowired; import org.springframework.web.bind.annotation.GetMapping; import org.springframework.web.bind.annotation.RestController; import java.util.concurrent.TimeUnit; @RestController public class LockController { @Autowired private RedissonClient redissonClient; @GetMapping("/lock") public String lockResource() throws InterruptedException { String lockKey = "myLock"; // 获取 RLock 对象 RLock lock = redissonClient.getLock(lockKey); try { // 尝试获取锁(尝试加锁)(锁超时时间是 30 秒) boolean isLocked = lock.tryLock(30, TimeUnit.SECONDS); if (isLocked) { // 成功获取到锁 try { // 模拟业务处理 TimeUnit.SECONDS.sleep(5); return "成功获取锁,并执行业务代码"; } catch (InterruptedException e) { e.printStackTrace(); } finally { // 释放锁 lock.unlock(); } } else { // 获取锁失败 return "获取锁失败"; } } catch (InterruptedException e) { e.printStackTrace(); } return "获取锁成功"; } }# 说一下Redisson中的看门狗机制?

Redisson 看门狗(Watchdog)机制是一种用于延长分布式锁的有效期的机制。它通过定时续租锁的方式,防止持有锁的线程在执行操作时超过了锁的有效期而导致锁被自动释放。

看门狗(Watchdog)的执行过程大致如下:

- 获取锁并设置超时时间:当客户端通过 Redisson 尝试获取一个分布式锁时,会使用 Redis 命令将锁存入 Redis,并设置一个初始的有效时间(即超时时间)。

- 启动看门狗线程:如果开启了看门狗的功能(默认开启),在成功获取锁后,Redisson 会在客户端内部启动一个后台守护线程,也就是所谓的“看门狗”定时任务定时去执行并续期。

- 定时检查与续期:看门狗按照预设的时间间隔(默认为锁有效时间的三分之一)周期性地检查锁是否仍然被当前客户端持有。如果客户端仍然持有锁,看门狗会调用 Redis 的相关命令或者 Lua 脚本来延长锁的有效期,确保在业务处理期间锁不会因超时而失效。

- 循环监控和更新:这个过程会一直持续到客户端显式地释放锁,或者由于其他原因(例如客户端崩溃、网络中断等)导致无法继续执行看门狗任务为止。

- 终止看门狗任务:客户端在完成业务逻辑后,会主动调用解锁方法释放锁,此时 Redisson 不仅会解除对 Redis 中对应键的锁定状态,还会同步停止看门狗的任务。

通过看门狗机制,即使在长时间运行的业务场景下,也能有效地避免由于锁超时而导致的数据不一致或其他并发控制问题,提高了系统的稳定性和可靠性。

# 什么是RedLock吗?它有什么优缺点?推荐使用RedLock吗?为什么?

RedLock 是 Redis 分布式锁的一种实现方案,由 Redis 的作者 Salvatore Sanfilippo 提出。RedLock 算法旨在解决单个 Redis 实例作为分布式锁时可能出现的单点故障问题,通过在多个独立运行的 Redis 实例上同时获取锁的方式来提高锁服务的可用性和安全性。

RedLock 实现代码

在 Java 开发中,可以使用 Redisson 框架很方便的实现 RedLock,具体操作代码如下:

import org.redisson.Redisson; import org.redisson.api.RedisClient; import org.redisson.api.RedissonClient; import org.redisson.config.Config; import org.redisson.redisson.RedissonRedLock; public class RedLockDemo { public static void main(String[] args) { // 创建 Redisson 客户端配置 Config config = new Config(); config.useClusterServers() .addNodeAddress("redis://127.0.0.1:6379", "redis://127.0.0.1:6380", "redis://127.0.0.1:6381"); // 假设有三个 Redis 节点 // 创建 Redisson 客户端实例 RedissonClient redissonClient = Redisson.create(config); // 创建 RedLock 对象 RedissonRedLock redLock = redissonClient.getRedLock("resource"); try { // 尝试获取分布式锁,最多尝试 5 秒获取锁,并且锁的有效期为 5000 毫秒 boolean lockAcquired = redLock.tryLock(5, 5000, TimeUnit.MILLISECONDS); if (lockAcquired) { // 加锁成功,执行业务代码... } else { System.out.println("Failed to acquire the lock!"); } } catch (InterruptedException e) { Thread.currentThread().interrupt(); System.err.println("Interrupted while acquiring the lock"); } finally { // 无论是否成功获取到锁,在业务逻辑结束后都要释放锁 if (redLock.isLocked()) { redLock.unlock(); } // 关闭 Redisson 客户端连接 redissonClient.shutdown(); } } }优缺点分析

优点分析

RedLock 是对集群的每个节点进行加锁,如果大多数节点(N/2+1)加锁成功,则才会认为加锁成功。

这样即使集群中有某个节点挂掉了,因为大部分集群节点都加锁成功了,所以分布式锁还是可以继续使用的。

缺点分析

RedLock 主要存在以下两个问题:

- 性能问题:RedLock 要等待大多数节点返回之后,才能加锁成功,而这个过程中可能会因为网络问题,或节点超时的问题,影响加锁的性能。

- 并发安全性问题:当客户端加锁时,如果遇到 GC 可能会导致加锁失效,但 GC 后误认为加锁成功的安全事故,例如以下流程:

- 客户端 A 请求 3 个节点进行加锁。

- 在节点回复处理之前,客户端 A 进入 GC 阶段(存在 STW,全局停顿)。

- 之后因为加锁时间的原因,锁已经失效了。

- 客户端 B 请求加锁(和客户端 A 是同一把锁),加锁成功。

- 客户端 A GC 完成,继续处理前面节点的消息,误以为加锁成功。

- 此时客户端 B 和客户端 A 同时加锁成功,出现并发安全性问题。

推荐使用 RedLock 吗?为什么?

不推荐使用 RedLock,因为 RedLock 存在的问题争议较大(性能和并发问题),且没有完美的解决方案,所以 Redisson 中已经废弃了 RedLock,这一点在 Redisson 官方文档中能找到

RedLock 替代方案

虽然 Redisson 中已经废弃了 RedLock,但是你可以直接使用 Redisson 中的普通的加锁即可,因为它的普通锁会基于 wait 机制,等待锁将信息同步到从节点,从而保证数据一致性的,虽然不能完全避免数据一致性问题,但也能最大限度的保证数据的一致性。

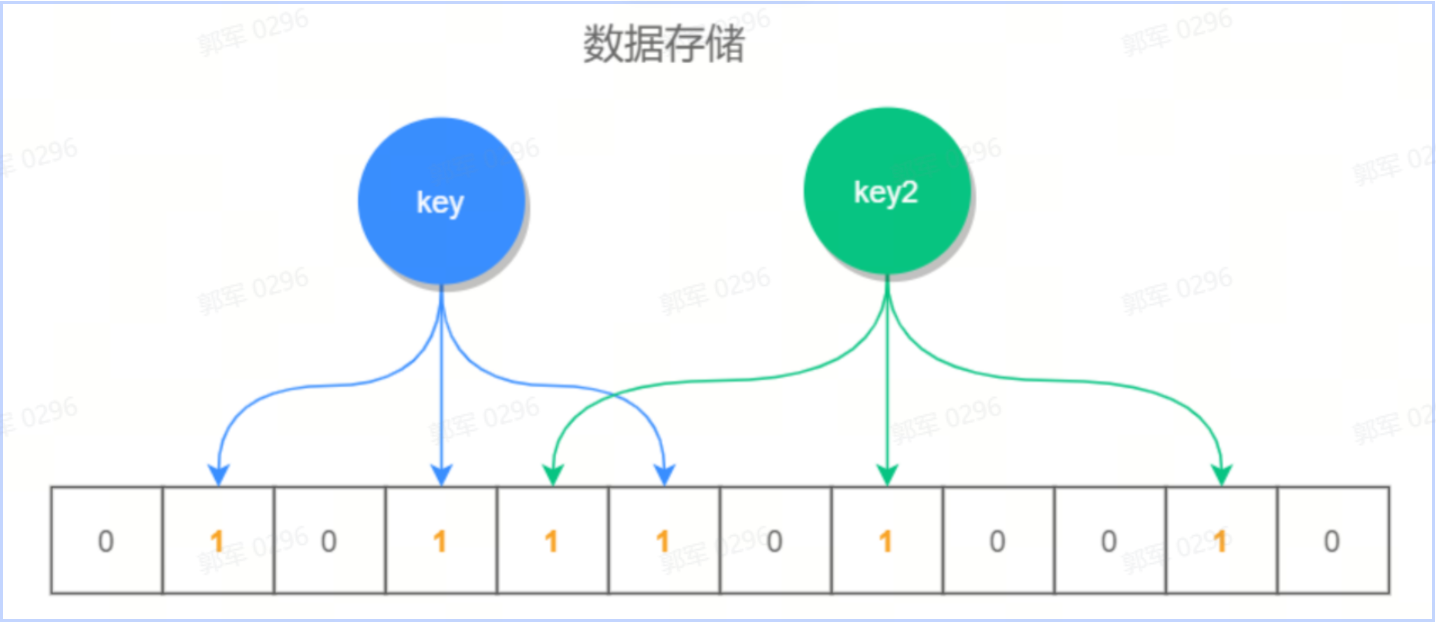

# 什么是布隆过滤器?它有什么特点?说一下它的底层实现原理?

布隆过滤器(Bloom Filter)是一种空间效率极高的概率型数据结构,用于判断一个元素是否在一个集合中。它基于位数组和多个哈希函数的原理,可以高效地进行元素的查询,而且占用的空间相对较小,如下图所示:

根据 key 值计算出它的存储位置,然后将此位置标识全部标识为 1(未存放数据的位置全部为 0),查询时也是查询对应的位置是否全部为 1,如果全部为 1,则说明数据是可能存在的,否则一定不存在。

布隆过滤器特点

也就是说,如果布隆过滤器说一个元素不在集合中,那么它一定不在这个集合中;但如果它说一个元素在集合中,则有可能是不存在的(存在误差)。

底层实现原理

布隆过滤器的具体执行步骤如下:

- 在 Redis 中创建一个位数组,用于存储布隆过滤器的位向量,每个位置的值设置为 0。

- 添加元素到布隆过滤器时,对元素进行多次哈希计算,并将对应的位数组位置设置为 1。

- 查询元素是否存在时,对元素进行多次哈希计算,并检查对应的位数组位置是否都为 1,都为 1 表示可能存在,其中有一个为 0 则一定不存在。

也就是说布隆过滤器是通过一个位数组,加上多组哈希算法来实现的,每次添加一个 key 的时候,通过多组哈希算法计算得到位数组的保存位置,然后将其设置为 1,查询时候也是如此,在查找中只要有一个位元素为 0,则表示当前 key 是不存在的,如果都为 1,则表示可能存在。

# 在Redis中如何实现布隆过滤器?

在 Redis 中不能直接使用布隆过滤器,但我们可以通过 Redis 4.0 版本之后提供的 modules (扩展模块) 的方式引入,它的实现步骤如下。

① 打包RedisBloom插件

git clone https://github.com/RedisLabsModules/redisbloom.git cd redisbloom make # 编译redisbloom

编译正常执行完,会在根目录生成一个 redisbloom.so 文件。

② 启用RedisBloom插件

重新启动 Redis 服务,并指定启动 RedisBloom 插件,具体命令如下:

redis-server redis.conf --loadmodule ./src/modules/RedisBloom-master/redisbloom.so

③ 创建布隆过滤器

创建一个布隆过滤器,并设置期望插入的元素数量和误差率,在 Redis 客户端中输入以下命令:

BF.RESERVE my_bloom_filter 0.01 100000

④ 添加元素到布隆过滤器

在 Redis 客户端中输入以下命令:

BF.ADD my_bloom_filter leige

⑤ 检查元素是否存在

在 Redis 客户端中输入以下命令:

BF.EXISTS my_bloom_filter leige

# 除了Redis还有其他实现布隆过滤器的手段吗?它们和Redis有什么区别?

除了 Redis 可以实现布隆过滤器之外,我们还可以使用以下方法实现布隆过滤器:

- 使用 Google Guava 实现布隆过滤器。

- 使用 Hutool 框架实现布隆过滤器。

但是以上方式实现的布隆过滤器为单机版的布隆过滤器,而 Redis 实现的布隆过滤器为分布式布隆过滤器。

# Redis中存储的数据会丢失吗?为什么?

Redis 存储的数据不会丢失,保证数据不丢失的手段主要有以下两个:

- 持久化:持久化是指将内存中的数据保存到硬盘上,以防止在服务器重启、宕机等意外情况下导致数据丢失。由于 Redis 是一个基于内存的数据库系统,默认情况下所有的数据都存储在内存中,这意味着一旦服务进程终止或硬件故障,内存中的所有数据都将消失。而 Redis 提供了 3 种持久化的手段,以保证 Redis 可以将内存中的数据保存到磁盘上,这样无论是服务器重启,还是宕机、掉电等问题,Redis 的数据都不会丢失。

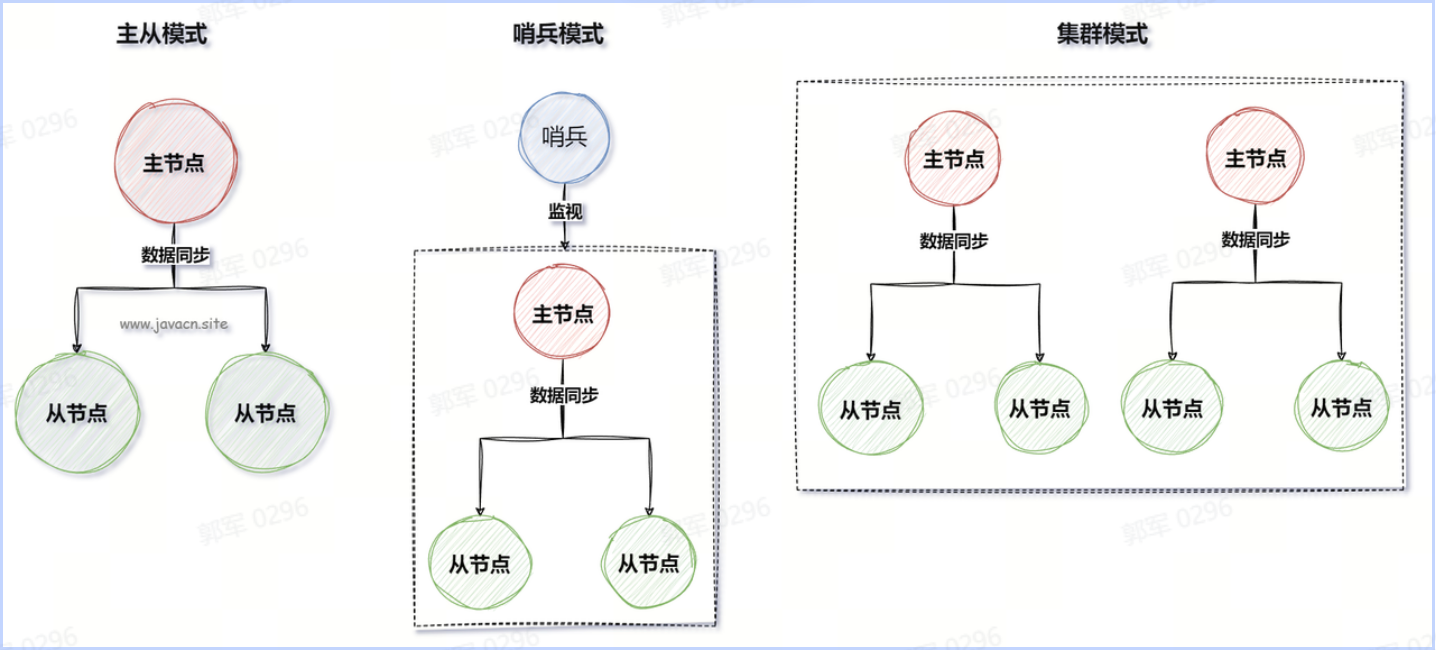

- 多机部署:多机部署是指在多个独立的服务器或虚拟机上部署和运行 Redis 服务实例,以实现数据冗余、高可用性、可扩展性和负载均衡等目标。Redis 多机运行部署的实现总共有三种:主从模式、哨兵模式和集群模式。

# Redis会怎么处理过期之后的键值对?它为什么要这样设计?

Redis 中过期的键值对不会立即删除,而是使用以下手段来删除过期键的:

- 惰性删除(Lazy Expire):Redis 不会主动地、周期性地检查和删除所有过期的键。惰性删除是指在 Redis 访问某个键值时,才会检查该键是否已经过期,如果已过期,则返回 NULL,并同时删除它。

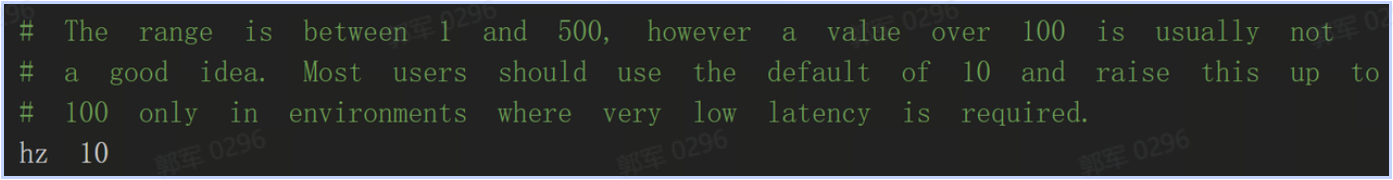

- 定期删除(Periodic Expire):每隔一段时间检查一次数据库,随机删除一些过期键。定期删除在 redis.conf 配置文件中配置,如下图所示:

hz 等于 10 表示每秒钟删除 10 次,也就是每 100 毫秒执行一次定期删除。

hz 等于 10 表示每秒钟删除 10 次,也就是每 100 毫秒执行一次定期删除。

之所以要采用这两种方式来删除是为了保证清除过期数据,不影响 Redis 整体的执行效率。

# 什么是缓存雪崩?如何解决缓存雪崩?

缓存雪崩是指在短时间内,有大量缓存同时过期,导致大量的请求直接查询数据库,从而对数据库造成了巨大的压力,严重情况下可能会导致数据库宕机的情况叫做缓存雪崩。

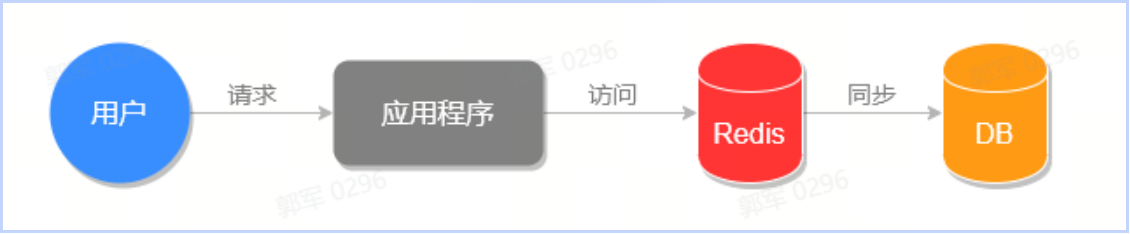

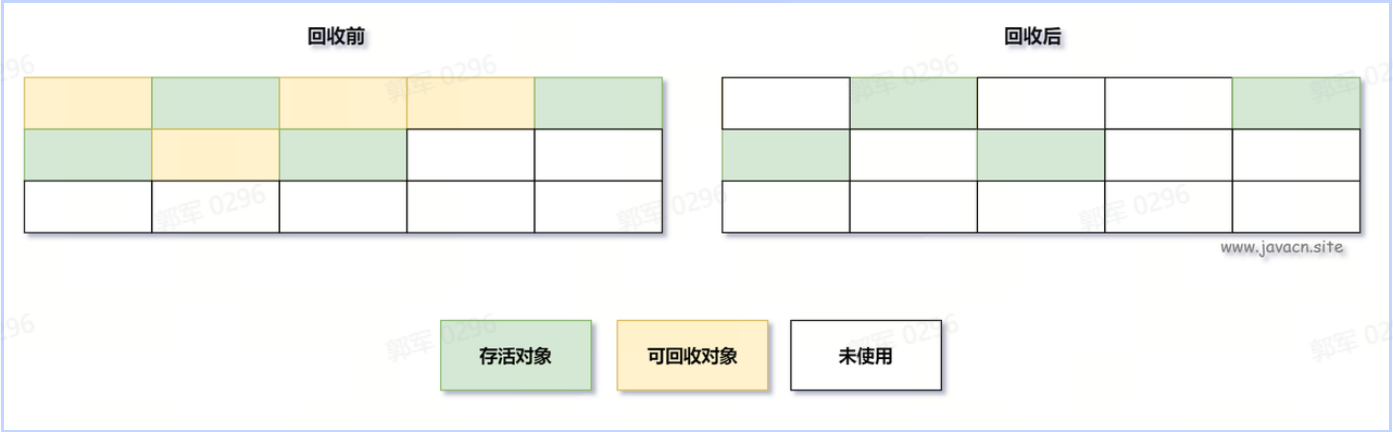

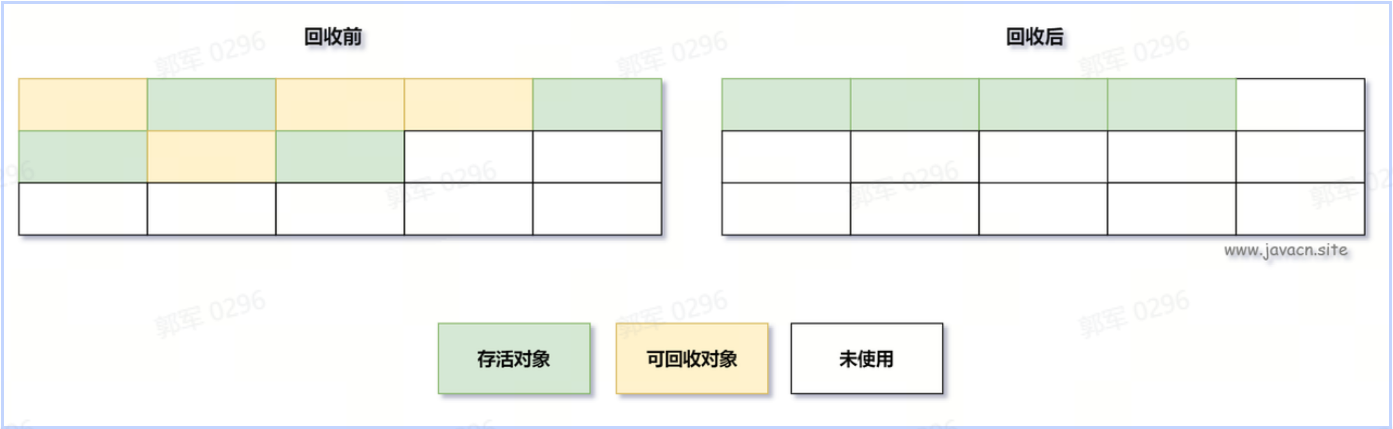

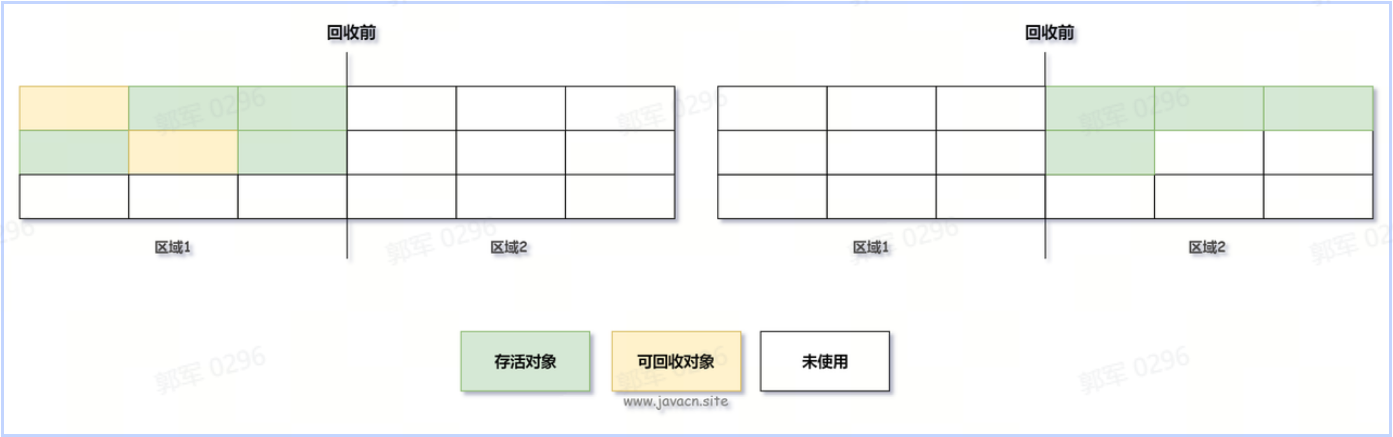

我们先来看下正常情况下和缓存雪崩时程序的执行流程图,正常情况下系统的执行流程如下图所示:

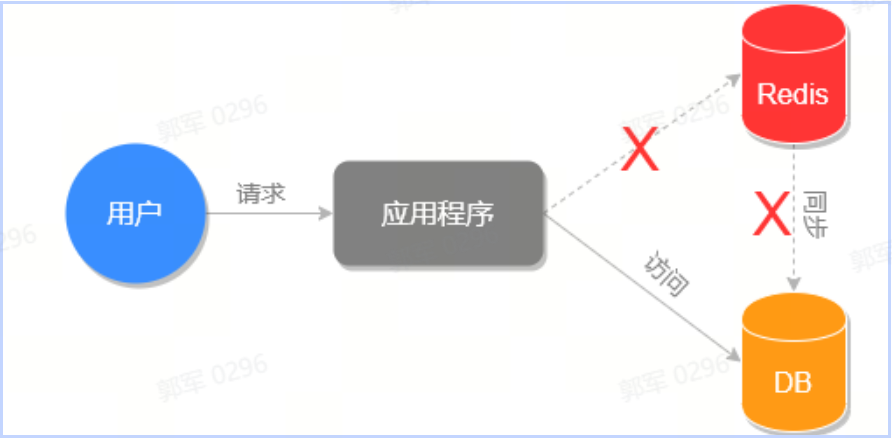

缓存雪崩的执行流程,如下图所示:

以上对比图可以看出缓存雪崩对系统造成的影响,导致缓存雪崩的主要原因有以下几个:

- 缓存过期时间设置不合理:当大量缓存数据在同一时间失效时,会导致大量请求直接打到数据库或者后端服务。

- 缓存服务器故障:如果缓存服务器发生故障,无法提供缓存服务,那么所有请求将直接访问数据库或者后端服务。

- 缓存数据的热点分布不均匀:如果某些热门数据集中在一部分缓存节点上,当这些节点发生故障或者数据失效时,会导致请求直接打到数据库或者后端服务。

如何解决缓存雪崩问题?

缓存雪崩的常见解决方案有以下几个:

- 随机生成缓存过期时间:随机生成缓存过期时间,可以避免缓存同时过期,从而避免雪崩问题的发生。

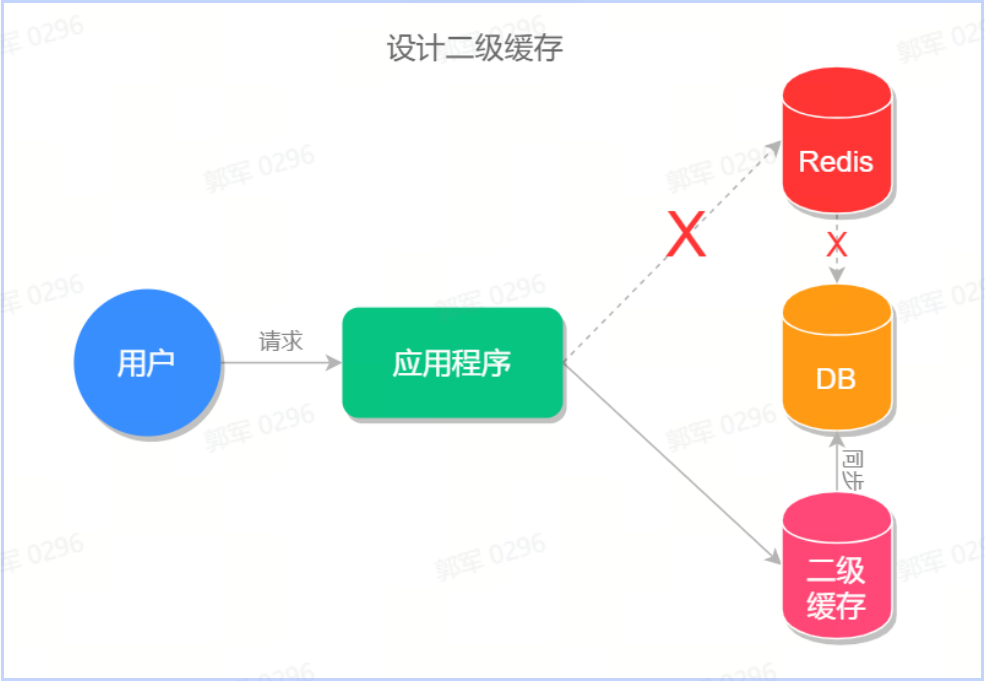

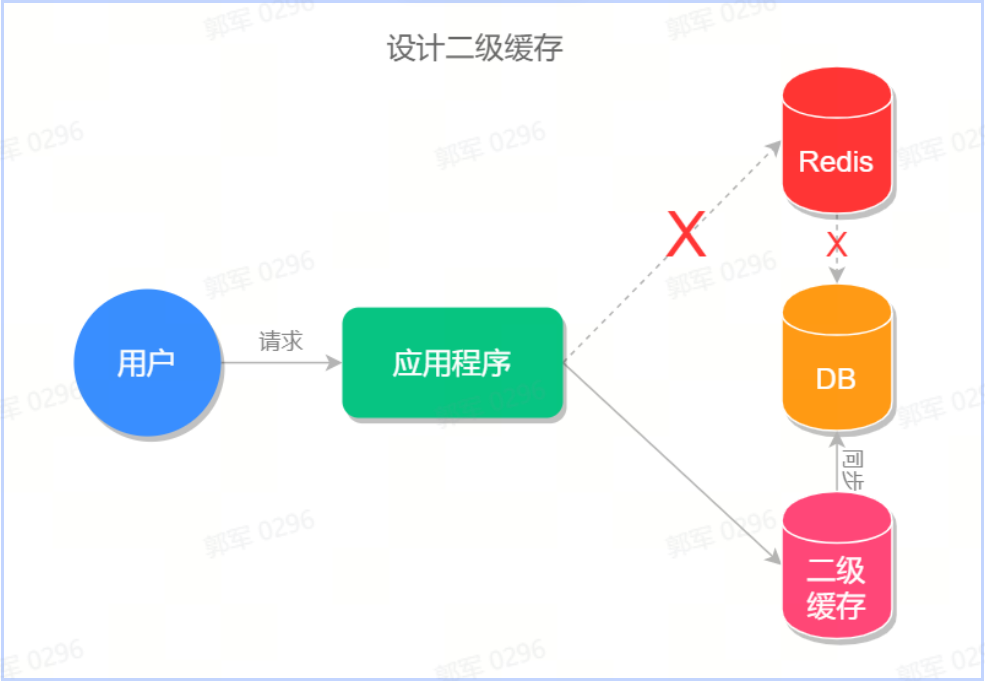

// 缓存原本的失效时间 int exTime = 10 * 60; // 随机数生成类 Random random = new Random(); // 缓存设置 jedis.setex(cacheKey, exTime+random.nextInt(1000) , value);使用多级缓存:可以使用多级缓存架构,将热门数据同时缓存在多个缓存节点上,避免单一节点故障导致请求直接访问数据库或者后端服务,例如可以设计二级缓存(分布式缓存+本地缓存),如下图所示:

缓存过期前预加载:在缓存即将过期之前,提前异步加载缓存,避免在缓存失效时大量请求直接打到数据库或者后端服务。

开启限流或降级功能:当缓存发生雪崩时,采用限流或降级的机制来减少服务器的压力,保证系统的可用性。

实时监控和预警:通过监控缓存的状态和命中率,及时发现缓存问题,预警系统管理员或运维人员。

# 什么是缓存穿透?如何解决缓存穿透?

缓存穿透是指查询数据库和缓存都无数据,因为数据库查询无数据,出于容错考虑,不会将结果保存到缓存中,因此每次请求都会去查询数据库,从而给数据库带来了额外的压力,降低了系统性能的情况就叫做缓存穿透。

也就是说缓存穿透是因为数据库查询无数据,出于容错考虑,不会将结果保存到缓存中,因此每次请求都会去查询数据库,这种情况就叫做缓存穿透。

缓存穿透执行流程如下图所示:

其中红色路径表示缓存穿透的执行路径,可以看出缓存穿透会给数据库造成很大的压力。

其中红色路径表示缓存穿透的执行路径,可以看出缓存穿透会给数据库造成很大的压力。解决缓存穿透

缓存穿透的常见解决方案有以下几个:

- 缓存空对象:对于查询结果为 null 或不存在的数据,也可以将它们以特殊值(如"NULL"、特定标识符)进行缓存,并设置较短的过期时间。这样,短时间内相同的查询请求就可以直接从缓存中获得响应,避免了对数据库的直接查询。

- 布隆过滤器(Bloom Filter):在请求到达缓存之前,先通过布隆过滤器判断数据可能存在还是一定不存在。对于确定不存在的数据,可以直接返回;可能存在则继续查询缓存和数据库。布隆过滤器是一种空间效率极高的概率型数据结构,它会给出“可能存在”或“肯定不存在”的答案。

- 开启限流功能:当发现大量连续未命中的请求时,可以采用限流策略限制同一时间段内向数据库发送的查询请求数量,减轻数据库压力。

# 什么是缓存击穿?如何解决缓存击穿?

缓存击穿指的是某个热点缓存,在某一时刻恰好失效了,然后此时刚好有大量的并发请求,此时这些请求将会给数据库造成巨大的压力,这种情况就叫做缓存击穿。

缓存击穿的执行流程如下图所示:

缓存击穿的主要原因是热点数据在缓存中失效或被淘汰,并发请求同时访问该数据,导致缓存无法命中。

解决缓存击穿

缓存击穿的常见解决方案有以下几个:

- 设置永不过期:对于某些热点缓存,我们可以设置永不过期,这样就能保证缓存的稳定性,但需要注意在数据更改之后,要及时更新此热点缓存,不然就会造成查询结果的误差。

- 缓存过期前预加载:在缓存即将过期之前,提前异步加载缓存,避免在缓存失效时大量请求直接打到数据库或者后端服务。

- 使用多级缓存:可以使用多级缓存架构,将热门数据同时缓存在多个缓存节点上,避免单一节点故障导致请求直接访问数据库或者后端服务,例如可以设计多级缓存,也就是使用分布式缓存(Redis)+本地缓存(Caffeine/Guava Cache),如下图所示:

- 开启限流或降级功能:当缓存发生雪崩时,采用限流或降级的机制来减少服务器的压力,保证系统的可用性。

# 什么是缓存预热?如何实现缓存预热?

缓存预热指的是在系统启动、高峰期来临之前或数据变更之后,提前将热门或需要经常访问的数据加载到缓存中,以提高系统的响应性能和缓存命中率。通过缓存预热,可以避免在实际请求到来时出现缓存穿透或缓存击穿的情况,减少对后端存储的直接访问。

实现步骤 实现缓存预热的一般步骤如下:

- 确定热门数据:首先需要确定哪些数据是热门或需要经常访问的数据。可以通过系统日志、业务需求、数据统计分析等方式进行判断和评估。

- 加载数据到缓存:在系统启动、高峰期来临之前或数据变更之后,提前将热门数据加载到缓存中。可以通过定时任务、异步加载、批量加载等方式来实现数据加载。

- 设置适当的过期时间:根据业务需求和数据的访问频率,设置适当的缓存过期时间。过期时间可以根据不同的数据进行灵活调整,以保证缓存数据的有效性。

- 监控和维护:在缓存预热完成后,需要进行监控和维护。可以通过监控缓存命中率、缓存失效率等指标来评估缓存的效果,及时进行调优和维护。

缓存预热实现

缓存预热的方法有很多种,下面是一些常见的实现方式:

- 手动初始化:在应用程序启动阶段或者服务初始化的时候,通过编写代码主动地从数据库加载热点数据,并将其放入缓存(如 Redis)。

// 初始化阶段加载热点数据 public void warmUpCache() { List<HotData> hotDatas = loadHotDataFromDatabase(); for (HotData data : hotDatas) { String key = buildKey(data.getId()); redisTemplate.opsForValue().set(key, data, expirationTime, TimeUnit.MINUTES); } }- 定时任务:使用定时任务定期刷新或加载数据到缓存,可以是固定时间间隔,也可以是在数据变更后触发。

- 事件驱动:当有新的数据添加到数据库时,触发一个事件来通知缓存系统加载新数据。

- 使用框架:某些框架或中间件提供了缓存预热功能的支持。例如,在 Spring Boot 项目中,可以通过实现 CommandLineRunner 或 ApplicationRunner 接口,在应用启动后自动加载数据到缓存。

import org.springframework.boot.ApplicationArguments; import org.springframework.boot.ApplicationRunner; import org.springframework.boot.CommandLineRunner; import org.springframework.stereotype.Component; @Component public class MyRunner implements CommandLineRunner, ApplicationRunner { @Override public void run(String... args) throws Exception { System.out.println("This is CommandLineRunner"); // 实现自定义操作 } @Override public void run(ApplicationArguments args) throws Exception { System.out.println("This is ApplicationRunner"); // 实现自定义操作 } }上述示例中,MyRunner 类同时实现了 CommandLineRunner 和 ApplicationRunner 接口,可以通过重写的两个 run 方法分别执行不同的操作。

PS:CommandLineRunner 执行时机早于 ApplicationRunner 接口,但 CommandLineRunner 适用于简单的命令行参数场景,例如在命令行中指定一些参数来配置应用程序行为。ApplicationRunner 适用于更复杂的场景,可以通过键值对的方式传递参数,以及获取更多关于应用程序参数的元数据。

# 六. Spring

# 在SpringBoot中如何实现缓存预热?

SpringBoot 缓存预热是指在 Spring Boot 项目启动时,预先将数据加载到缓存系统(如 Redis)中的一种机制。

实现方案概述

在 Spring Boot 启动之后,可以通过以下手段实现缓存预热:

- 使用启动监听事件实现缓存预热。

- 使用 @PostConstruct 注解实现缓存预热。

- 使用 CommandLineRunner 或 ApplicationRunner 实现缓存预热。

- 通过实现 InitializingBean 接口,并重写 afterPropertiesSet 方法实现缓存预热。

具体实现方案

① 启动监听事件 可以使用 ApplicationListener 监听 ContextRefreshedEvent 或 ApplicationReadyEvent 等应用上下文初始化完成事件,在这些事件触发后执行数据加载到缓存的操作,具体实现如下:

@Component public class CacheWarmer implements ApplicationListener<ContextRefreshedEvent> { @Override public void onApplicationEvent(ContextRefreshedEvent event) { // 执行缓存预热业务... cacheManager.put("key", dataList); } }或监听 ApplicationReadyEvent 事件,如下代码所示:

@Component public class CacheWarmer implements ApplicationListener<ApplicationReadyEvent> { @Override public void onApplicationEvent(ApplicationReadyEvent event) { // 执行缓存预热业务... cacheManager.put("key", dataList); } }ContextRefreshedEvent VS ApplicationReadyEvent

ContextRefreshedEvent 和 ApplicationReadyEvent 发生的时间和应用场景略有不同:

- ContextRefreshedEvent(上下文刷新事件):当 ApplicationContext 容器初始化或刷新时触发该事件,这个事件在 Bean 的初始化方法之前触发,意味着在该事件完成之前,Bean 已经完成实例化和配置了。

- ApplicationReadyEvent(应用就绪事件):当 Spring Boot 应用完全启动并准备接受请求时触发该事件。在该事件触发时,Spring Boot 应用的所有初始化工作已完成,包括 Bean 的实例化、依赖注入等。这个事件通常用于在应用启动完成后执行一些特定的操作,比如启动定时任务、加载缓存数据等。

所以说,ContextRefreshedEvent 事件被触发时,Spring容器中的 Bean 已经准备好了,但应用可能还没有完全启动,尚未准备好接收请求。而 ApplicationReadyEvent 事件则表示应用已经完全启动并准备好处理请求。

② @PostConstruct 在需要进行缓存预热的类上添加 @Component 注解,并在其方法中添加 @PostConstruct 注解和缓存预热的业务逻辑,具体实现代码如下:

@Component public class CachePreloader { @Autowired private YourCacheManager cacheManager; @PostConstruct public void preloadCache() { // 执行缓存预热业务... cacheManager.put("key", dataList); } }③ CommandLineRunner或ApplicationRunner

CommandLineRunner 和 ApplicationRunner 都是 Spring Boot 应用程序启动后要执行的接口,它们都允许我们在应用启动后执行一些自定义的初始化逻辑,例如缓存预热。

CommandLineRunner 实现示例如下:

@Component public class MyCommandLineRunner implements CommandLineRunner { @Override public void run(String... args) throws Exception { // 执行缓存预热业务... cacheManager.put("key", dataList); } }ApplicationRunner 实现示例如下:

@Component public class MyApplicationRunner implements ApplicationRunner { @Override public void run(ApplicationArguments args) throws Exception { // 执行缓存预热业务... cacheManager.put("key", dataList); } }CommandLineRunner 和 ApplicationRunner 区别如下:

方法签名不同:

- CommandLineRunner 接口有一个 run(String... args) 方法,它接收命令行参数作为可变长度字符串数组。

- ApplicationRunner 接口则提供了一个 run(ApplicationArguments args) 方法,它接收一个 ApplicationArguments 对象作为参数,这个对象提供了对传入的所有命令行参数(包括选项和非选项参数)的访问。

参数解析方式不同:

- CommandLineRunner 接口更简单直接,适合处理简单的命令行参数。

- ApplicationRunner 接口提供了一种更强大的参数解析能力,可以通过 ApplicationArguments 获取详细的参数信息,比如获取选项参数及其值、非选项参数列表以及查询是否存在特定参数等。

使用场景不同:

- 当只需要处理一组简单的命令行参数时,可以使用 CommandLineRunner。

- 对于需要精细控制和解析命令行参数的复杂场景,推荐使用 ApplicationRunner。

④ 实现InitializingBean接口

实现 InitializingBean 接口并重写 afterPropertiesSet 方法,可以在 Spring Bean 初始化完成后执行缓存预热,具体实现代码如下:

@Component public class CachePreloader implements InitializingBean { @Autowired private YourCacheManager cacheManager; @Override public void afterPropertiesSet() throws Exception { // 执行缓存预热业务... cacheManager.put("key", dataList); } }# 什么是IoC?它解决了什么问题?为什么要使用它?

IoC 和 AOP 是 Spring 中最核心的两个概念。

IoC 是 Inversion of Control 的缩写,翻译成中文是“控制反转”的意思,它不是一个具体的技术,而是一个实现对象解耦的思想。

控制反转的意思是将要使用的对象生命周期的控制权进行反转,传统开发是当前类控制依赖对象的生命周期的,现在交给其他人(Spring),这就是控制(权)反转。

也就是说 IoC 解决了将对象的生命周期控制权从原来的类型,反转给 IoC 框架了,这样程序中就无需在关注对象的生命周期了,这些都由 IoC 框架来控制了。

为什么要使用 IoC?

使用 IoC 主要是因为 IoC 有以下几个优点:

- 解耦和松散耦合:IoC 通过将组件之间的依赖关系从代码中分离出来,实现了松散耦合。这意味着组件不需要直接了解它们之间的详细实现,从而提高了代码的可维护性和可重用性。

- 代码简洁性:IoC 使你的代码更加专注于业务逻辑,而不需要过多关注依赖的创建和管理。这使得代码更加清晰、简洁和易于理解。

- 生命周期管理:IoC 容器可以管理组件的生命周期,确保它们在合适的时间进行创建、初始化和销毁。

- 可重用性:由于依赖关系由容器管理,可以更容易地将组件在不同的应用程序中重用。

- AOP 实现基础:IoC 是实现 AOP(面向切面编程)的基础,允许你将横切关注点(如日志、安全性)与核心业务逻辑分离。

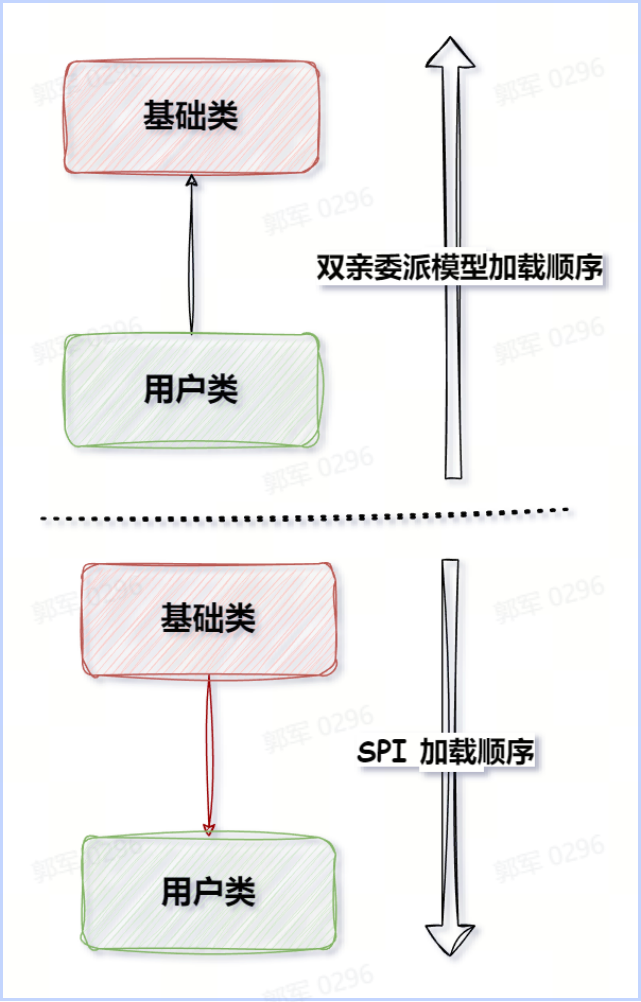

# IoC和DI有什么关系?IoC的实现除了DI之外,还有其他实现方式吗?

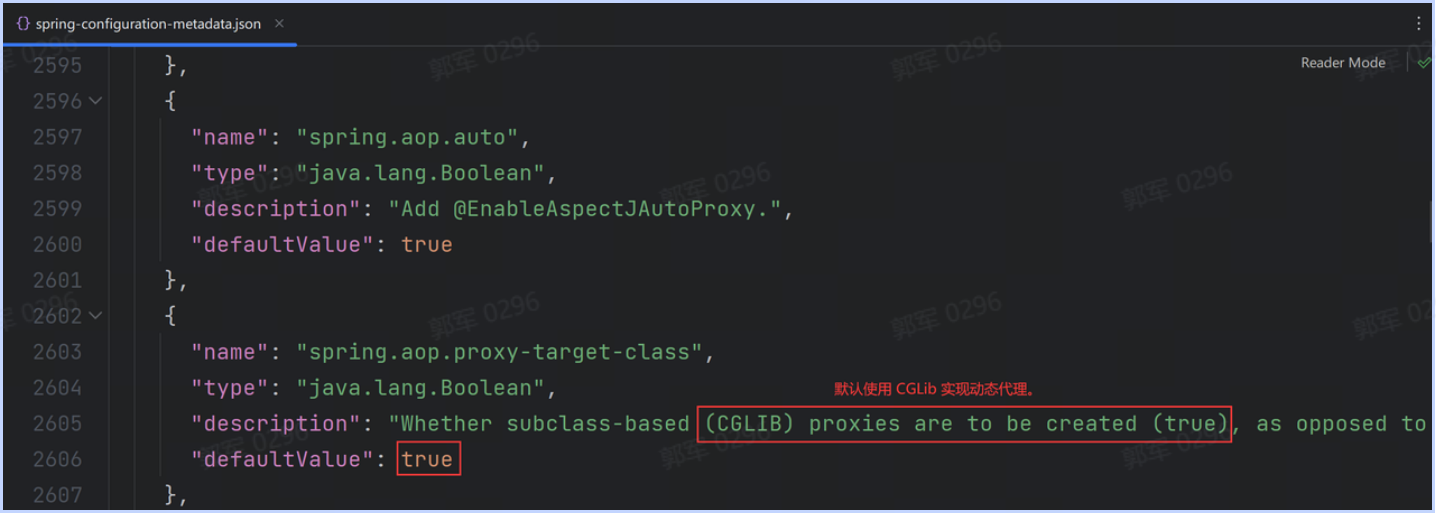

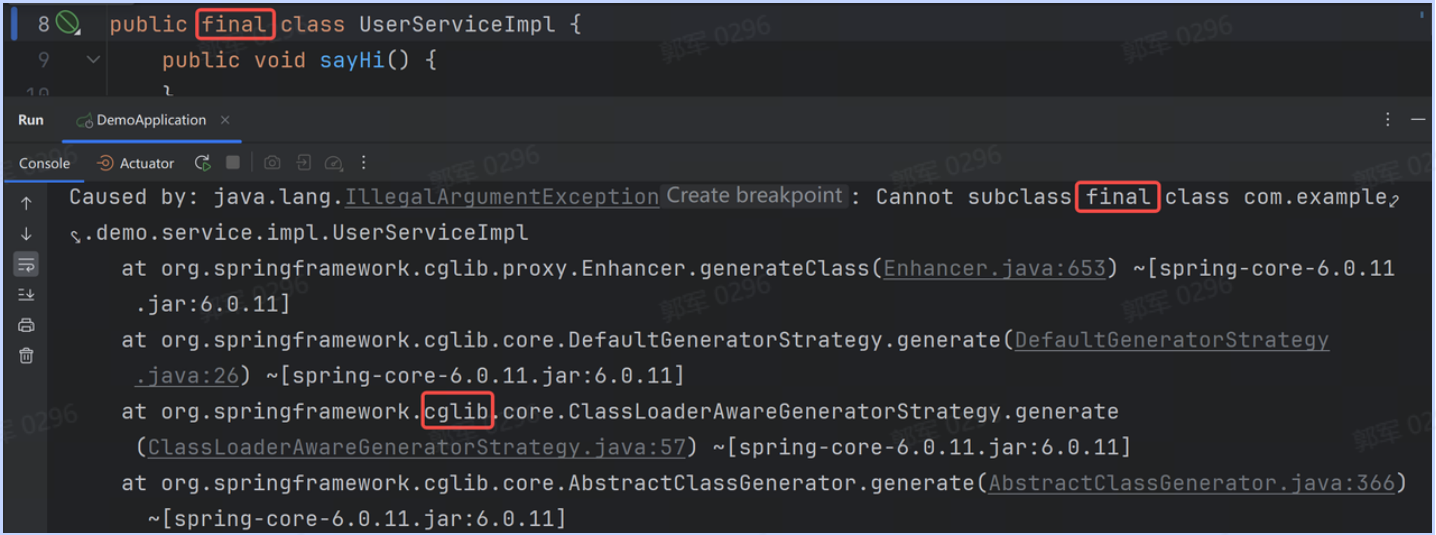

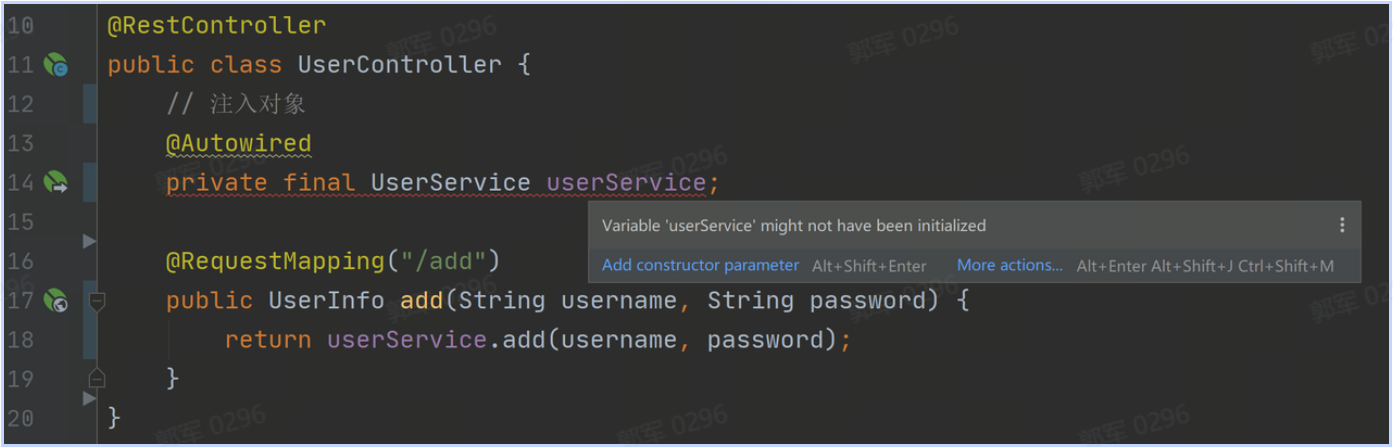

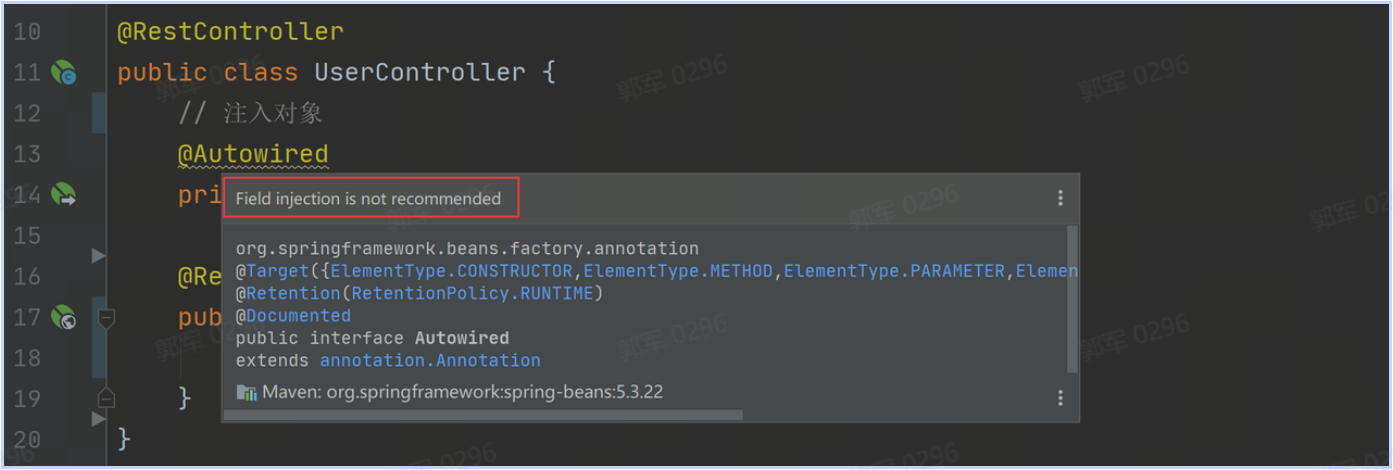

DI 是 Dependency Injection 的缩写,翻译成中文是“依赖注入”的意思。依赖注入不是一种设计实现,而是一种具体的技术,它是在 IoC 容器运行期间,动态地将某个依赖对象注入到当前对象的技术就叫做 DI(依赖注入)。